亚马逊云科技多年深耕结硕果,定制芯片值此re:Invent大会全面开花

但就在上周,英特尔公司CEO Pat Gelsinger宣布离职,而亚马逊云科技则在拉斯维加斯召开了一年一度的re:Invent大会。今年的大会吸引到6万人亲临现场,40万人在线关注,是谁在控制着超大规模计算厂商和云服务商的技术发布命脉已经不言而喻。

没错,就是亚马逊。

事实上,亚马逊云科技还占据着不发布新产品的主动权,毕竟他们不像其他芯片厂商那样必须定期更新自家阵营。相较于英特尔、AMD和英伟达那样拼命向ODM和OEM厂商推销计算引擎,亚马逊云科技直接创建虚拟化实例并以租赁形式向客户提供原始容量的访问权限。从各个方面来讲,这都是一种更加顺畅且便于操作的业务形态。

如果大家关注了亚马逊云科技公共计算高级副总裁Peter DeSantis的开幕主题演讲,以及亚马逊云科技 CEO Matt Garman以及母公司亚马逊CEO Andy Jassy带来的最新消息,肯定会和我们一样对后续计算引擎相关公告抱有极大热情。没错,相信很多人都期待在今年的re:Invent大会舞台上,亚马逊云科技能够一举公布了Graviton 5服务器CPU、Inferentia 3 AI推理加速器以及Trainium 3 AI训练加速器等重磅消息。

可惜的是,除了Garman在一张幻灯片中提到Trainium 3将采用3纳米制程工艺(可能由台积电提供),性能为Trainium 2的两倍、每瓦性能较Trainium 2高40%之外,再没有关于亚马逊云科技这些自主研发芯片的更多具体细节。另有一篇新闻稿补充称,Trainium 3 UltraServers的性能将达到Trainium 2版UltraServers的4倍,意味着其将从Trainium 2的16设备规模扩展至Trainium 3时代的32设备。

Garman还提到,Trainium 3“将于明年晚些时候推出”,由此看来其正式交付时间很可能是re:Invent 2025大会。早在今年6月,就在会议称亚马逊云科技高管证实Trainium 3的热功耗将突破1000瓦,但这也完全在意料之中,毕竟英伟达那边的旗舰级“Blackwell”B200 GPU的峰值功率同样高达1200瓦。

而且这个数字还不如我们家中常见的吹风机大,虽然我已经很多年没用过吹风机了。另外换算下来,这也就相当于十几枚白炽灯泡。

真正让我们感到惊讶的是,亚马逊云科技居然没有在上个月的SC24超算大会上公布面向高性能计算(HPC)类应用的Graviton4E。这显然不符合亚马逊云科技当初在2021年11月公布普版Graviton 3,于2022年11月公布增强版Graviton 3E的套路。目前的Graviton 4可以说是市面上最强大的Arm架构服务器CPU之一,当然也是泛用性最强的选项之一。Graviton 4于2023年11月问世,并在今年8月迎来了内存提升。

亚马逊云科技最大的优势,就是其不需要每年都为CPU、AI加速器和DPU制定升级路线。相比之下,英伟达和AMD的GPU路线图就显然遵循着每两年发布一次,中间这年针对前一年发布的GPU进行内存升级或者性能优化的固定节奏。

亚马逊云科技的芯片更新节奏看似是两年,但中间也会有小幅波动。需要强调的是,Graviton 1实际上是一款强化版的“Nitro”DPU卡,所以不能算数。根据DeSantis在2018年发布Graviton 1时的主题演讲中所说,Graviton 1是“向市场发出的信号”,旨在验证客户是否准备好在数据中心内使用Arm架构CPU。而随着2019年Graviton 2的推出,亚马逊云科技开始采用台积电的现代7纳米制程工艺,同时配合Arm的“Ares”N1核心设计出这款64核处理器。与亚马逊云科技上运行的英特尔及AMD x86 CPU相比,Graviton 2不仅同样能够支撑起现实业务,而且性价比还要高出40%。

两年之后,Graviton 3采用Arm更强大的“Zeus”V1核心——尽管“只有”64核,但却可以承载起强度更大的任务。又是两年,Graviton 4如期而至,我们猜测其采用更先进的4纳米台积电工艺,将96个“Demeter”V2核心塞入插槽,并辅以十几个DDR5内存控制器(内存带宽为537.6 GB/秒)。直接按单核心进行比较,Graviton 4比Graviton 3的每核性能高了30%、核心数量增加50%,因此粗略来看其性能可达Graviton 3的2倍。根据我们之前推测得出的定价模型,其性价比相当于提高了13%到15%。而在实际基准测试当中,Graviton 4往往可实现40%的性能增量。

坦率地讲,亚马逊云科技也必须用两年时间才能从这笔高昂的处理器设计投资中收回成本。因此,本周re:Invent 2014也确实不太可能发布关于Graviton 5的消息。但从DeSantis、Garman和Jassy的主题演讲中,还是能够窥探到新款芯片的一点端倪。

亚马逊云科技的各位高层确实在主题演讲中发布关于Graviton芯片家族的一些有趣统计数据。亚马逊云科技计算与网络服务副总裁Dave Brown展示了一张非常有趣的图表,这也在一定程度上解释了英特尔最近几个季度的财务状况为何如此糟糕:

粗略地看,亚马逊云科技四项核心服务(包括Redshift Serverless 和 Aurora 数据库、Managed Streaming for Kafka 以及ElastiCache 搜索)之下的约半数负载都运行在Graviton实例之上。在刚刚过去的Prime Day购物节中,亚马逊调用了超过25万块Graviton处理器支持这场盛事。

Brown继续补充道,“最近我们又迎来了另一个重要里程碑。在过去两年之间,我们数据中心内超过50%的CPU容量都由亚马逊云科技 Graviton提供。也就是说,Graviton处理器的数量比所有其他类型的处理器加起来还要多。”

这正是微软多年之前希望达成的目标,也符合我们长久以来的期待。从长远来看,x86只能算是一种具有传统价值的遗留平台,地位可能跟之前的大型机与RISC/Unix类似。RISC-V最终可能也会掀起又一次革命,让Arm架构同样成为“前浪 ”。(除此之外,兼具开源属性与可组合构建块,并由专家监督的开源ISA似乎也是一条可行的道路。总之,期待Linux在操作系统领域大杀四方,最终让Windows Server也沦为传统平台。)

Garman的演讲,则让我们了解到亚马逊云科技内部Graviton服务器集群的庞大规模。“Graviton正在疯狂增长,这里我们要结合背景来看。2019年,整个亚马逊云科技业务总值为350亿美元。现如今,亚马逊云科技机群中运行的Graviton,其算力规模与2019年的总体算力相当。这无疑是相当令人印象深刻的增长速度。”

我们倒是很好奇2019年亚马逊云科技的服务器机群规模和现在的规模具体是多大。总之比较靠谱的估算是,Graviton服务器机群的增长速度比亚马逊云科技自身更快,而且可能是快得多得多。而且这对英特尔的伤害要比对AMD的伤害大得多,毕竟近年来AMD的x86服务器CPU一直就比英特尔做得好。

Trainium芯片将对AMD和英伟达形成压力

Garman提及Trainium 3的唯一理由,就是AI训练(以及越来越多的推理负载)在高性能计算层面的需求增长速度,要远远快于市场所能提供的计算引擎数量。随着英伟达加大其“Blackwell”B100与B200 GPU的供货规模,加上AMD不断推进其“Antares”MI300系列的产能,如果亚马逊云科技想让客户能够放心把自己的AI工作负载转移到Trainium上,就必须得表现出全力加速自家AI芯片研发的决心。于是乎,Trainium 3就登上了本届re:Invent大会的舞台。

话虽如此,但我们确实希望亚马逊云科技能在明年11月或12月召开re:Invent大会之前,带来更多关于Trainium 3的细节消息。毕竟包括谷歌和微软在内,其他各大科技巨头都打算在2025年全力宣传其自主研发的AI加速器。

与Graviton家族一样,我们认为Trainium系列芯片从现在起也将保持每两年一代的更新速度。毕竟这类设备价格昂贵,亚马逊云科技必须在尽可能多的设备上摊销Trainium开发成本,才能像Graviton CPU那样达成预期财务目标。另外跟Graviton芯片一样,我们认为亚马逊云科技将半数AI训练和推理工作负载运行在自主研发的Trainium芯片上的日子也已不远。由此看来,英伟达和AMD的滋润生活可能也不长久了,毕竟谷歌、微软、腾讯、百度和阿里巴巴都有可能走上相同的自给自足道路。

亚马逊云科技当然不会愚蠢到想在GPU加速器市场上跟英伟达直接竞争,但如同谷歌的TPU、SambaNova的RDU、Groq的GroqChip以及Graphcore的IPU一样,这位云服务巨头绝对能够打造出一款相对够用的差异化加速器满足自己的AI训练和推理需求,同时为云客户提供价值增量。而且跟直接采购英伟达GPU相比,原研道路很可能有着更大的利润空间或者至少更主动的形势掌控能力。

正如我们之前提到,亚马逊云科技高管并没有过多讨论Trainium 3,但他们对Trainium 2在UltraServer pod中Trn2实例上的正式开放表现得相当兴奋。

去年re:Invent大会结束之后,我们于2023年12月详细介绍了Trainium 2及其前身Trainium 1,包括用于AI推理的配套Inferntia 1与Inferentia 2加速器架构。本周,亚马逊云科技进一步讨论了采用Trainium 2加速器的系统架构,并展示了为这些加速器横向及纵向扩展AI集群所打造的相关网络硬件。

下面咱们就看图说话。

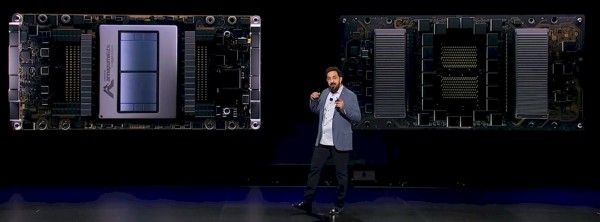

下图是DeSantis展示的Trainium 2卡:

Trainium 2似乎是将两个芯粒以互连形式塞进了同一封装,而且可能使用NeuronLink实现芯片到芯片互连。该互连设计则以负责将Trainium 1和Trainium 2芯片相互连接的结构为基础,以便二者能在共享的HBM内存之上实现工作负载的连贯共享。

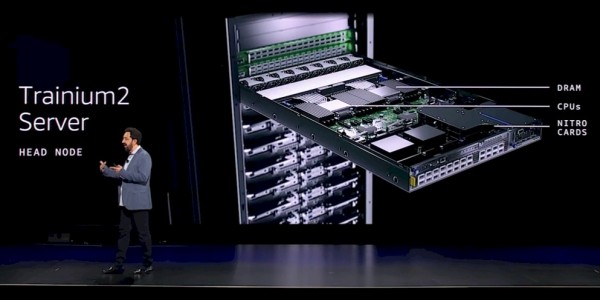

Trainium 2服务器中设有一个头节点,该节点带有两块主机处理器(大概是Graviton 4,但DeSantis没有说明),并大小便三个Nitro DPU,如下图所示:

下图是该计算节点的俯视图,前端有四个Nitro,后端是两块Trainium 2,采用无明线设计以加快部署速度:

两个交换机托架、一个主机托架外加八个计算托架共同组成一台Trainium 2服务器,其使用2 TB/秒的NeuronLink线缆将16块Trainium 2芯片互连成为2D环面配置,每台设备上的96 GB HBM3主内存均与其他设备共享。每台Trainium 2服务器配备有1.5 TB的HBM3内存,总内存带宽为46 TB/秒(合每张Trainium 2卡接近3 TB/秒)。此节点在密集FP8数据上的性能为20.8千万亿次,在稀疏FP8数据上的性能为83.3千万亿次。(亚马逊云科技在稀疏数据上的压缩率为4:1,而英伟达的「Hopper」与「Blackwell」GPU的压缩率为2:1,Cerebras Systems晶圆级引擎的压缩率则为10:1。)

四台这样的服务器互连,即可建立起Trainium 2 UltraServer。该服务器在64张AI加速器上总计拥有6 TB的HBM 3内存容量,总内存带宽高达184 TB/秒。此pod还拥有12.8 Tb/秒的以太网带宽,可使用EFAv3适配器进行互连。UltraServer pod在密集FP8数据上拥有83.2千万亿次运算能力,在稀疏FP8数据上则具有332.8千万亿次算力。

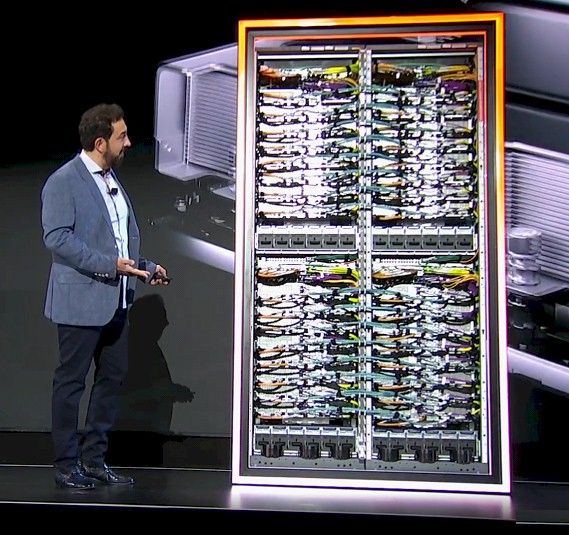

下图是DeStantis在展示Trn2 UltraServer实例背后的硬件构成:

在机架顶部,埋在大量线缆后面的是两个交换机,它们共同构成3.2 Tb/秒的EFAv3以太网网络端点。该网络将多台Trainium 2服务器相互连接以构建起UltraServer pod,再将各pod互连并与外部连接:

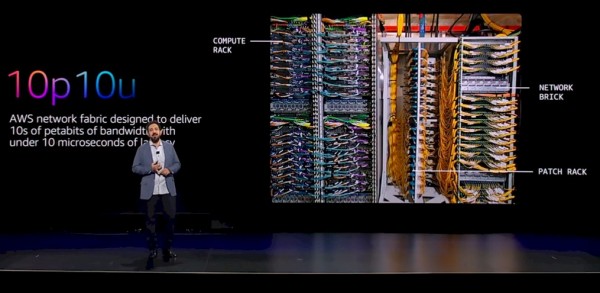

千万不要以为这就是网络设计的全部。如果想要运行大规模基础模型,需要的加速器肯定远远不止64张。为了将数十万张加速器整合起来,让它们能够运行高强度的训练,亚马逊云科技设计出一种新的网络结构(大概基于以太网),名为10p10u。其目标是在整个网络中以低于10微秒的延迟提供每秒高达数十PB的传输带宽。

采用10p10u网络结构的机架如下图所示:

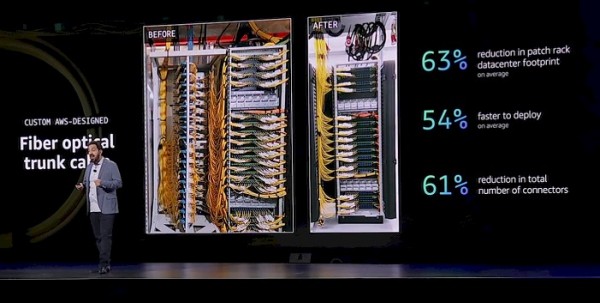

可以看到上图配线架中的布线极其复杂,因此亚马逊云科技发明了一种光纤主干线缆。凭借将数百条光纤连接放进同一条粗管内的设计,其一举将需要管理的线材数量压缩至1/16,整理之后整个配线架更加整洁,如下图所示:

右侧的配线架负责容纳光纤主干线缆,结果确实更整洁且占用空间更小。减少需要管理的连接和线缆数量,代表着出错的机率会更低,这一点对于快速构建AI基础设施非常重要。

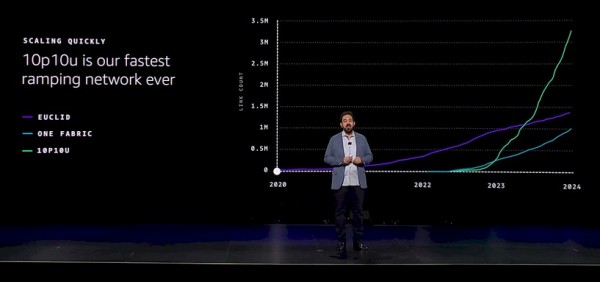

据我们所知,这套10p10u网络并非仅适用于AI工作负载,但AI工作负载明显才是其快速普及的最大驱力。DeSantis还展示了与亚马逊云科技开发的原有(可能相对更慢)以太网网络相比,10p10u网络的增长速度有多快:

假设这里公布的是累积链接数量,那么原有Euclid网络结构(大概是100 Gb/秒)在四年之内逐渐增长至近150万个端口,名为One Fabric的网络与10p10u网络则在2022年中期大致同时推出。我们假设前者使用的是400 Gb/秒以太网,而10p10u几乎肯定是基于800 Gb/秒以太网。当然,这些都只是猜测。目前One Fabric拥有约100万条链接,而10p10u在链接数量约为330万条。

总而言之,Garman表示与亚马逊云科技上基于GPU的实例相比,Trn2实例的性价比要高出30%到40%。我们之前是不是听过这个数字?对了……Graviton在亚马逊云科技上比x86更具性价比优势。

当然,亚马逊云科技可以随意调整自主研发计算引擎同外部计算引擎之间的应用比例。如果他们希望Trainium在不久的未来在其AI训练机群中占比一半,那么这30%到40%的性价比优势就是最充分的理由。

再说最后一点。作为主题演讲中的一环,DeSantis和Garman都谈到亚马逊云科技正在构建的代号为Project Ranier的超级集群,以供AI大模型合作伙伴Anthropic(亚马逊迄今为止已向其投资80亿美元)用于训练其下一代Claude 4基础模型。Garman表示,Project Ranier将拥有“数十万”个Trainium 2芯片,其性能将达到Claude 3模型训练设备的5倍。

好文章,需要你的鼓励

苏州大学团队重磅发现:让AI精准抓住长文重点的“降噪“训练法,8B模型媲美GPT-4o

苏州大学研究团队提出"语境降噪训练"新方法,通过"综合梯度分数"识别长文本中的关键信息,在训练时强化重要内容、抑制干扰噪音。该技术让80亿参数的开源模型在长文本任务上达到GPT-4o水平,训练效率比传统方法高出40多倍。研究解决了AI处理长文档时容易被无关信息干扰的核心问题,为文档分析、法律研究等应用提供重要突破。

专访|AI浪潮下的“卖水人”:Cloudera解构企业AI的“源”与“治”

在Cloudera的“价值观”中,企业智能化的根基可以被概括为两个字:“源”与“治”——让数据有源,智能可治。

清华大学团队破解AI训练中的“幽灵故障“:为什么大模型训练会莫名其妙地崩溃?

清华大学团队首次揭示了困扰AI训练领域超过两年的"幽灵故障"根本原因:Flash Attention在BF16精度下训练时会因数字舍入偏差与低秩矩阵结构的交互作用导致训练崩溃。研究团队通过深入分析发现问题源于注意力权重为1时的系统性舍入误差累积,并提出了动态最大值调整的解决方案,成功稳定了训练过程。这项研究不仅解决了实际工程问题,更为分析类似数值稳定性挑战提供了重要方法论。

数智惠闽企,展车进福州|华为坤灵中国行2025·福建站成功举办,推动闽企智能化发展新征程

AI时代的影像实验:记录你眼中的“变化”

大象转身,亦或重塑大象:Unity团结引擎的“中国本土”进化

无万卡,不VLA:元戎启行与阿里云的“想法”和“解法”

AI爬虫让“价格战”变成“算法战”,利润正在被看不见的流量吞噬 AI 爬虫程序流量在短短一年内暴增 300%

做好可持续数字化转型的“必答题”

SUSE Linux Enterprise Server (SLES) 16全新发布:AI赋能,智领企业管理

SAP商业AI获乌镇峰会精品案例奖,助推中国企业实现确定性增长

专访|Cloudera致力于打造AI时代的企业级“数据操作系统”

专访|AI浪潮下的“卖水人”:Cloudera解构企业AI的“源”与“治”

SAP TechEd柏林观察:企业AI如何发挥飞轮效应?

CIO策略观察——软件测试:从传统困局到 AI 无人测试转型