极智芯 | 解读NVIDIA B100 B200 以及两个"留了一手"

NVIDIA GTC 2024 大会已经于 2024 年 3 月 18 日至 21 日举行,今年的 GTC 大会的焦点毫无疑问就是新一代 GPU 架构 Blackwell 以及搭载新一代 GPU 架构的产品 B100、B200 以及 GB200 等。这里先来解读一下 B100 和 B200。

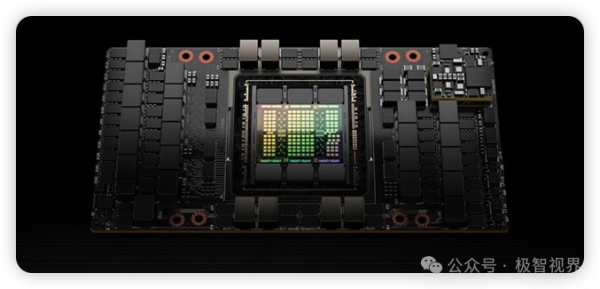

老黄整个的介绍下来,可能你会发现英伟达是在弱化 PCIe 板卡的概念,并在向 SXM 架构收敛。介绍一下 SXM,SXM 架构是一种高带宽插座式解决方案,用于将 NVIDIA Tensor Core 加速器连接到其专有的 DGX 和 HGX 系统。而 SXM 架构其实并不算 "新鲜玩意",在 NVIDIA 的每一代企业级计算产品中都是有 SXM 形态的,比如 P100、V100、A100、H100。SXM 相比于 PCIe 的优势在哪里呢,一个在带宽互联、一个在体型体态。PCIe 的带宽通常较低,虽然可以通过 NVLInk 桥接达到和 SXM 相同的带宽,但仍然会受到 PCIe 总线的限制,而且 SXM 在多 GPU 互联方面也具有优势,而这些优势在大模型时代尤其重要。另外由于 SXM 没有板卡外壳,不依赖于 PCIe 卡槽,同样密度的机箱能够插更多的计算卡,能够提升计算卡的布置密度。所以在大模型 AI 计算中心构建方面,SXM 架构形态的优势明显。下面的是 H100 SXM 的产品图。

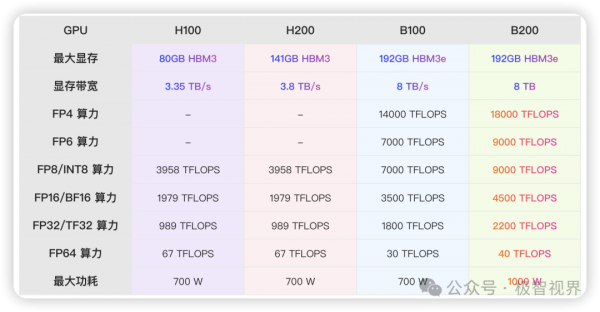

回到 Blackwell,B100 其实可以直接参考英伟达的传统,比如看作是 A100、H100 的延伸,是其系列的下一代。但是英伟达似乎这次是直接越过了 B100,重心是在推 B200。那么 B200 又是什么呢,这个可以原地参考之前的 H200,关于 H200,可以翻翻我之前的对于 H200 的解读内容《极智芯 | 不要神乎其神 来看全球最强芯H200的提升到底在哪里》。其实简单理解就是两颗 B100 die Chiplet 了一下,形成了 die-to-die 的架构,关于 Chiplet 的解读,可以翻下我的这篇内容《极智芯 | 先进封装技术Chiplet》。当然,B200 相对于 B100 和 H200 相对于 H100 又不太一样,之前的 H200 相对于 H100,其提升点主要是在显存方面,但是 B200 相对于 B100 的提升则是全方位的。为了说明这一点,我整理了 H100、H200、B100、B200 的主要性能参数对比。

来分析一下,H200 相对于 H100,显存提升到了 141 GB,而这里的 B100 和 B200 在显存容量方面进一步提升,已经来到 192GB (这个 192GB 是不是稍微有些熟悉,苹果 M2 Ultra 最大也是支持 192GB 的统一内存),当然这种提升会是直接来自 HBM3 -> HBM3e 带来的提升受益。你可能还会发现,B200 其实相对于 B100 在显存方面是一致的,包括显存容量和显存带宽。这里就需要好好解释一下了,H200 相对于 H100 的显存提升主要是因为堆叠了更多颗的 HBM3,而 B100 相对于 H100 或者说 B200 相对于 H200 的提升主要受益于 HBM 本身的提升,而 B200 和 B100 的显存情况一致是因为 B200 和 B100 都是 HBM3e,而且颗数也一样。这样应该解释清楚了。除了显存,另外很重要的点在算力,Blackwell 架构新增加了 FP4 和 FP6 精度,这可以认为是之前 FP8 精度的更低版,所以 FP4 相对于 FP8、FP8 相对于 FP16 算力之间会有倍数的差别。在算力方面,B200 相对于 B100 对比 H200 相对于 H100 就不一样了,B200 相对于 B100 在算力方面可谓全面提升,但是并不是理想状态下 two-die 呈倍数的提升,这里其实你也可以认为英伟达给自己 "留了一手"。

好文章,需要你的鼓励

Zopa银行提前推出活期账户服务

Zopa银行正式推出可在几分钟内开户的活期账户服务,面向其150万储蓄和贷款客户以外的更广泛用户群体。该账户此前已有6万名现有客户参与测试,正式发布时间比预期提前。作为金融科技先驱,Zopa在2020年获得完整银行牌照后推出首款储蓄产品,目前拥有140万客户,年收入超过3亿英镑,存款规模超过50亿英镑。

机器人团队协作新突破:上海人工智能实验室让多个机器人像人类团队一样高效合作

上海人工智能实验室的研究团队开发了VIKI-R框架,首次实现了让不同类型机器人像人类团队一样协作。该研究建立了全球首个多机器人视觉协作评估平台VIKI-Bench,通过队员选择、任务规划、轨迹感知三层测试体系全面评估协作能力。VIKI-R采用监督学习预热加强化学习优化的两阶段训练方法,在所有测试层级都取得显著性能提升,为智能制造、医疗服务等领域的机器人应用提供了重要技术突破。

Mozilla发布Firefox 140扩展支持版本并引入多项新功能

Mozilla正式推出Firefox 140浏览器,作为扩展支持版本(ESR)发布。新版本增加了标签页卸载功能,可清理内存并在需要时重新加载。垂直标签页用户可调整固定标签区域大小,隐私翻译功能现可跟随滚动位置优先翻译当前查看区域。Android版本支持批量选择标签页,私人标签可通过密码或指纹保护。该版本同时更新ESR 128用户,为下游项目如Waterfox和Thunderbird提供新版本基础。

告别文档分块难题:Yellow.ai如何用AI“眼睛“让机器真正看懂PDF文件

Yellow.ai研究团队开发了革命性的多模态文档分块技术,让AI系统能像人类一样"看"PDF文档,而非仅仅"读"文字。该方法采用批量视觉处理和上下文保持机制,解决了传统固定长度分块导致的表格分割、内容破碎等问题。在RAG系统测试中,准确率从78%提升至89%,显著改善了文档理解质量。