AI热潮正在拉动数据中心基础设施支出

如果说有哪种事物丝毫不受通胀态势的抑制,甚至在一定程度上加剧了全球经济的通胀压力,那必然就是生成式AI。从我们目前掌握的关于全球服务器和存储支出的有限数据来看,AI基础设施支出似乎已经成为服务器和存储领域的收入支柱。相比之下,面向其他类型工作负载的数据中心设备基础支出则每况愈下,目前的销售态势甚至不及今年年初。

坦白讲,核心服务器与存储市场正在陷入衰退。这是因为企业暂停行动,超大规模基础设施运营商仍在“消化”去年年底已经采购的基础设施。行业内唯一仍然保持旺盛活力的,就只有AI系统以及伴随而来的爆发式需求增长。

事实上,传统HPC仿真与建模社区一直都梦想让“高性能计算”迎来这样的爆发式增长,但却从来未能如愿。其实这颇有几分遗憾,因为人们普遍认为,HPC在帮助我们创造新成果或修复旧方案时的贡献要高于生成式AI。更不要说生成式AI中还潜藏着一种巨大隐患——直接在“适当的时候”消灭无数工作岗位。正因如此,亚马逊公司首席执行官Andy Jassy在讨论全球经济的长期趋势时,才总把这种威胁挂在嘴边。

有点跑题了,但大家要记住上述前提条件,咱们继续对数据中心基础设施市场展开分析。

大学物理教授曾经教导我们,在开始解决问题之前要先对答案做个粗略的估计,并在处理过程中不断纠正错误。因此让我们从今年夏初的传闻说起,即英伟达在整个2023年内只能生产约50万个“Hopper”H100 GPU。

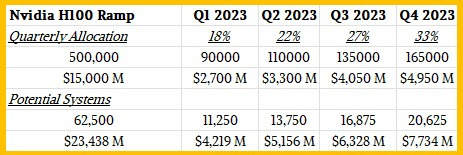

假设英伟达的合作渠道商制定的H100 GPU平均售价为3万美元,那么单凭H100销量就能支撑起150亿美元的收入。IDC等公司也是据此计算季度收入数字的。但如果假设随着2023年的推进,这50万个H100 GPU在各季度的分布并不均衡(例如第一季度生产18%,第二季度生产22%,第三季度为27%,第四季度为33%),那么在合理的增长猜测之下,H100 GPU单在2023年第二季度就能带来33亿美元销售额。而如今的普通数据中心系统往往要搭载8个这样的GPU,同时匹配与英伟达DGX H100类似的内存、闪存和网络接口。由此可知,这些基于H100的GPU型系统将带来约52亿美元的总销售额。再加上英伟达其他加速器和可以进行大规模矩阵数学计算的在售加速器,也许其单凭AI热潮就能斩获约70亿美元的收入数字。

下图所示,为我们整理的粗略估算表,仅供大家参考:

根据IDC公布的历史数据,在这波生成式AI浪潮之前,服务器的平均售价为7000美元——数字来自机器学习占据AI主流,大规模HPC系统保持稳定,IBM刚刚对大型机/Power Systems进行升级的2021年。(这也是IDC最后一次向公众发布季度服务器跟踪报告。)

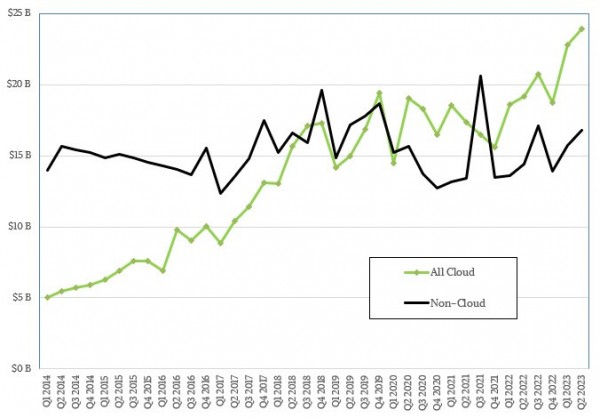

而在对IDC刚刚发布的2023年第二季度数据中心基础设施支出数据进行切片剖析之后,我们认为390亿美元支出总额中的很大一部分都来自AI系统。如果按照我们前面提出的70亿美元预估数字来计算,那么用于支撑其他类型工作负载的全部基础设施该季度支出将为320亿美元。而且可以看到,2023年第二季度服务器与存储基础设施的整体支出仅增长了1.3%,要比IDC今年4月报告的第一季度8.2%的增幅要低得多。当然,第一季度与第二季度间出现连续增长绝对是件好事,从第一季度的358亿美元起步,现在我们正逐步向着2022年第三季度的407亿美元回归,也期待这波生成式AI的革命能拉动市场重回2022年第四季度的428亿美元支出峰值。

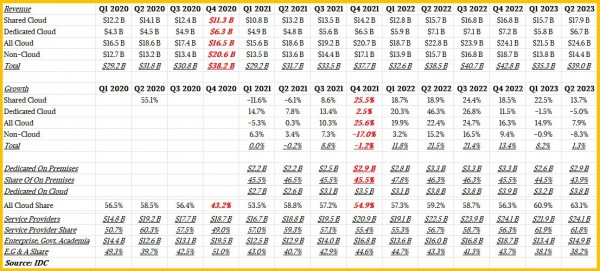

以下是IDC在2021年推出的数据中心服务器存储模型的汇总数据,其中消除了服务器与存储销售额之间被重复计入的部分。对于超大规模基础设施运营商和云服务商来说,所谓存储已经不再是纯粹的存储,而是大容量磁盘/闪存加上较弱CPU的组合。在这种情况下,我们该如何划分,它算是服务器还是存储?IDC认为全都算,也就是说除非能搞清楚IDC在计算中使用的原始数据,否则我们根本没法搞清二者的确切数字。

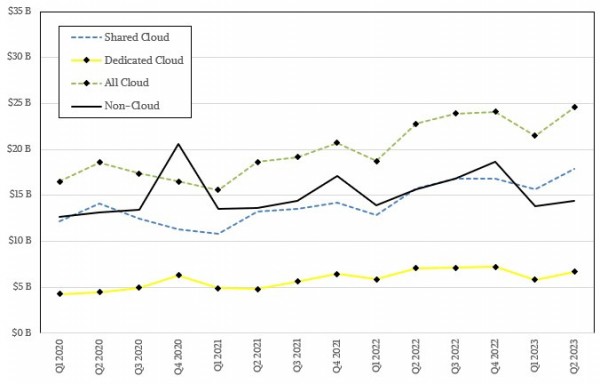

下表所示,为2020年第一季度至2023年第二季度期间用IDC新方法统计得出的云与非云基础设施支出数据:

表中红色粗体的部分,是我们为了填补数据空白而添加的估计值。

因为上个礼拜2023年的第三季度才刚刚过去,所以目前还没有可用的数据。加上IDC也需要一段时间来核对上市企业的所有财务数据,包括构建数据中心支出模型,所以我们可能要到2024年1月才能看到今年第三季度的统计结果。

在今年第二季度,超大规模基础设施运营商和云服务商在共享云基础设施(同时涵盖服务器和存储,但不包括网络)上的支出增长了13.7%,达到179亿美元;但在专用云基础设施方面的支出(也就是成规模的企业数据中心或者主机跨站托管设施)同比下降超5%,来到67亿美元。第一季度,专用云支出同样下降1.5%,总额为58亿美元。连续两个季度下降,当然可以理解为衰退。

非云基础设施(例如大型x86、Power或大型机系统,及其支持关系数据库与ERP、供应链管理、仓库管理和客户关系管理应用程序所使用的SAN存储)的支出下降了8.3%,来到144亿美元。同样的,这部分非云细分市场较2023年第一季度的138亿美元实现了环比增长,但非云基础设施的整体支出第一季度下降了0.9%、第二季度继续下降8.3%,连续两个季度的缩水同样代表需求衰退。

目前的情况是,GPU供不应求的客观现实导致生成式AI领域最具实力的三位参与者——微软、谷歌和亚马逊云科技,正在从英伟达处获得优先配额,这反过来又加快了云服务商对外租赁基础设施的脚步。毕竟只要有短缺,这种“二道贩子”式的行为就不可能断绝。但根据报道,英伟达方面有望在2024年将H100 GPU的生产能力提升至150万至200万个,届时产品稀缺性或将有所缓解、价格随之下降,服务器市场也将重新归于正常。类似的情况在2018年和2019年的服务器内存领域也曾出现,当时DRAM价格曾经暴涨一倍,同样拉高了服务器的平均售价。

关键在于,如果大家需要2万到2.5万个GPU来训练最先进的生成式AI模型,那么50万个H100 GPU就只能构建20到25个大规模集群。目前全球也只有20到25家机构愿意承受这么高的建设成本。再考虑到模型的实际训练往往需要几个月时间,包括筛选数万亿个参数并消化同等规模的数据token,也许整个基础设施将由数百个组织或部门进行共享。也就是说,即使2024年英伟达能够把H100 GPU的产量推向最乐观的200万,还是不一定能满足生成式AI的旺盛需求。

如果真是这样,那么GPU的售价将继续居高不下,导致AI系统的成本也将保持高位。

更令我们担心的是,第二季度服务器和存储出货量下降了23.2%——我们不清楚实际出货的机器数量,因为IDC没有发布这项数据。而且2023年第一季度,服务器与存储出货量已经缩水了11.4%。连续两个季度的萎缩,自然就是需求衰退的标志。

展望今年下半年,IDC预计云基础设施的支出将增长10.6%,来到1014亿美元;高于三个月前提出的全球7.3%的增长预期。2023年全年,共享云部分的销售额预计将增长13.5%,达到720亿美元;专用云部分将增长4.1%,来到294亿美元。非云服务器和存储支出则将会下降7.9%,来到585亿美元。我们认为云领域的所有增长都将由AI服务器所驱动,而AI服务器又以英伟达GPU及其竞争对手的其他AI引擎为底层驱力。

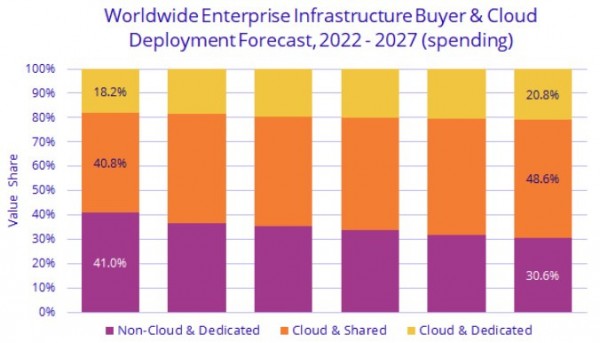

从长期来看,预计2022年至2027年(含)间云基础设施支出将保持11.3%的年均复合增长率(CAGR),到2027年年底时将达到1567亿美元,占服务器与存储总支出的69.4%。到2027年,共享云规模将达到1097亿美元,年均复合增长率为11.6%;专用云规模将达到470亿美元,年均复合增长率为10.7%。而且不管大家是否相信,IDC预计非云服务器和存储支出也将增长至691亿美元,在2022年至2027年之间实现1.7%的处均复合增长率。

好文章,需要你的鼓励

AI如何重振电商客户信任度

生成式AI在电商领域发展迅速,但真正的客户信任来自可靠的购物体验。数据显示近70%的在线购物者会放弃购物车,主要因为结账缓慢、隐藏费用等问题。AI基础设施工具正在解决这些信任危机,通过实时库存监控、动态结账优化和智能物流配送,帮助商家在售前、售中、售后各环节提升可靠性,最终将一次性买家转化为忠实客户。

SCB集团团队突破传统RAG技术壁垒:打造超大规模网络知识库的高速检索新方案

泰国SCBX金融集团开发的DoTA-RAG系统通过动态路由和混合检索技术,成功解决了大规模知识库检索中速度与准确性难以兼得的难题。系统将1500万文档的搜索空间缩小92%,响应时间从100秒降至35秒,正确性评分提升96%,为企业级智能问答系统提供了实用的技术方案。

Qumulo推出Stratus架构实现安全多租户环境

存储供应商Qumulo发布多租户架构Stratus,为每个租户提供独立的虚拟环境,通过加密技术和租户专用密钥管理系统实现隔离。该统一文件和对象存储软件支持本地、边缘、数据中心及AWS、Azure等云环境部署。Stratus采用加密隔离技术确保敏感数据安全,同时提供任务关键操作所需的灵活性和效率,帮助联邦和企业客户满足合规要求。

VGR:中科院和字节跳动的AI突破——让机器真正“看懂“图片再推理

中科院和字节跳动联合开发了VGR视觉锚定推理系统,突破了传统AI只能粗略"看图"的局限。该系统能在推理过程中主动关注图片关键区域,像人类一样仔细观察细节后再得出结论。实验显示VGR在图表理解等任务上性能大幅提升,同时计算效率更高,代表了多模态AI"可视化推理"的重要进展。

Qumulo推出Stratus架构实现安全多租户环境

氛围编程诞生四个月后:软件开发正在发生根本性变革

拉美数据中心淘金热背后的重大风险

诺基亚发布自主网络架构平台

华为携手产业达成移动AI基础网共识,加速5G-A体验变现

北京联通携手华为拥抱AI技术革命,加速迈入智能时代

算力狂飙时代:新华三如何掀起底座革命?

AI应用核爆时代,智算网络如何“接招”?

训练成本低至惊人!MiniMax 开源Flash Attention机制的 M1 推理模型

马斯克现身YC大会:谈"智能大爆炸"时代的生存法则,结合PayPal、SpaceX、特斯拉、xAI创业史,详解如何使用第一性原理

全球领头CRM,如何在中国跑出新模式?

研究显示LLM转化率高9倍,答案引擎优化时代来临