META PLATFORMS迎来新成员:专为驱动人工智能而生

如果说过去三十年来HPC集群和这十年间AI训练系统有什么发展共性的话,那就是随着工作负载的增长,网络在这类系统中的重要性正在愈发凸显。其决定性意义,甚至不亚于芯片本身的物理尺寸与发热量升级。

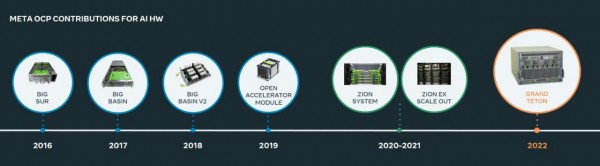

特别是在AI训练领域,没有什么能比Meta Platforms创建的定制化服务器发展更能体现这一趋势。早在2016年时,还名唤Facebook的社交巨头就已经将首个AI系统设计捐赠给其2011年创立的开放计算项目。最近十年可谓摩尔定律衰落的十年,硬件与应用软件间的协同设计成为这段时间的核心主题。更重要的是,超大规模服务商和云基础设施运营商一直在努力从以往的HPC高性能计算中汲取经验教训,借此推动面向AI的一系列积极探索。

在本周于硅谷举行的开放计算项目(OCP)全球峰会上,Meta Platforms推出了其全新“Grand Teton”AI系统,以及基于磁盘对口的配套“Grand Canyon”大容量存储阵列。相关设计均将被捐赠给开放计算项目,以供其他制造商能够借此建立供自家AI软件堆栈使用的裸机Meta Platforms兼容系统。

Grand Teton系统的完整规格尚未公开,但Meta公司基础设施副总裁Alexis Bjorlin发布的博文倒是给出了一点可供玩味的线索。另一方面,Grand Canyon存储阵列的规格已经在开放计算项目网站上正式公开。

幸运的是,通过四处寻找,我们翻出Meta Platforms在今年4月发表的一篇论文,内容正是关于软硬件协同设计的Neo系统。该系统意义重大,曾启发2019年建立的上一代“Zion”AI系统,以及从2021年着手研究的新一代“ZionEX”系统。关于ZionEX,Meta方面直到今年才陆续披露相关资料。Neo系统其实是一款由Meta Platforms创建的内存缓存管理程序,可供用户更灵活且可扩展地使用集群内存的各个层次结构,确保一切皆处于软件的控制之下。顺带一提,ZionEX设计也已被贡献给开放计算项目,详情可参阅Zion 1.0规范文档(https://www.opencompute.org/documents/facebook-zion-system-spec-1-0-pdf)。根据Meta Platforms的内部消息人士透露,Grand Teton也将于2023年4月被贡献给开放计算项目。

ZionEX机器和Neo缓存内存管理程序将共同用于训练深度学习推荐模型(DLRM)。这类模型已经成为现代企业中的关键工作负载,供包括Facebook、Instagram、WhatsApp等知名堆栈向用户展示有针对性的广告和宣传内容。

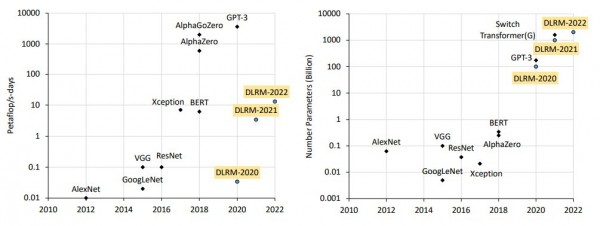

深度学习推荐模型和Transformer模型(主要用于自然语言处理)都比算力资源有着近乎疯狂的需求。下面来看4月论文中展示的图表:

Meta Platforms使用多个Zion系统耦合而成的ZionEX集群,对规模从950亿参数到12万亿参数不等的DLRM模型进行训练,由此较以往简单Zion机器集群实现了一个数量级的速度跃升。据Meta Platforms介绍,最初的Zion设计难以实现良好扩展,且训练运行往往被困于单一设备之内。但通过ZionEX,Meta Platforms为GPU提供了一个全连接拓扑结构,能够利用RDMA over Converged Ethernet绕过CPU网络堆栈,保证GPU能够通过以太网结构完全访问彼此内存。更多细节,我们将在后文中具体介绍。

据推测,考虑到Grand Teton系统将采用“Hopper”H100 GPU,其性能应该达到ZionEX机器中原先使用的“Ampere”A100 GPU的3到6倍,主机GPU带宽提升至4倍,网络传输带宽提升至2倍,再加上功率水平的倍增,Grand Teton设备应该能帮助Meta Platforms进一步扩展所训练的DLRM规模,或者将同等大小的模型更快训练至理想状态。

META PLATFORMS上的AI裸机演变

各家超大规模服务商和云基础设施运营商也都意识到,他们需要同时为特定应用程序堆栈或云客户的应用程序堆栈设计共通的硬件和软件。另外,他们还得控制设备中的各项物料与零配件来源,确保能够在供应链遭受新冠疫情冲击的大背景之下,仍然较为稳定地达成产能规划目标。

因此,Facebook希望通过开放计算项目解决这些问题。随着整个项目正式转化为Meta Platforms,他们对于客户硬件的需求也变得愈发迫切。正因为如此,Meta Platforms才会在过去一年间以饥不择食的方式尝试各种硬件,包括基于英伟达加DGX服务器、再加Mellanox交换基础设施打造出的,几乎已经没有任何定制空间可言的Research Super Computer(RSC)系统。这当然不是Facebook和Meta Platforms愿意选择的路线,但就目前的情况来看,从英伟达那边购买系统恐怕是唯一能够准时准点获取GPU资源的途径。

Zion、ZionEX和现在的Grand Teton服务器GPU都采用Facebook和微软三年前建立的OCP应用程序模块(OAM)外形尺寸。之前的GPU加速AI设备(包括2016年公布的Big Sur、2017年的Big Basin和2018年的Big Basin 2)都采用PCI-Express GPU加速器,并未选择英伟达专为其最高性能系统保留的带NVLink网络接口的定制化SXM插槽。

与其他超大规模服务商一样,Meta Platforms也在努力摆脱专有技术的束缚。但奇怪的是,这又跟Meta先收购RSC系统、最近再依托微软Azure云构建基于英伟达A100 GPU的虚拟超级计算机相冲突。也正是因为这一“神奇”操作,微软和Meta Platforms才联手打造出了OAM这一外形尺寸。

AMD和英特尔都在自家GPU产品中支持OAM外形尺寸——AMD这边是2020年11月开始推出的“Arcturus”Instinct MI100系列,外加去年推出的最新“Aldebaran”Instinct MI200系列。英特尔则在其延迟已久的“Ponte Vecchio”Xe HPC离散GPU加速器上支持OAM外形尺寸。

英伟达倒是从未正面讨论过这个问题,但其还是为Zion和ZionEX服务器的Meta Platforms提供了OAM版本的“Pascal”P100和“Ampere”A100 GPU加速器(对原PCI-Express版本的定制化变体)。由此看来,英伟达应该也会为Grand Teton系统提供同样的定制化H100变体,同时为微软制造能够与OAM相兼容的GPU加速器。

Meta Platforms之所以可能会从微软那边购买云端AI集群,或者是采购英伟达的DGX专有系统,理由应该就是英伟达在H100发货之前,还会坚持面向OAM供应一定数量的GPU。

从ZION到GRAND TETON

由于Meta Platforms一直遮遮掩掩,所以我们没法断言Grand Teton系统到底会是怎样的设计思路,唯一的线索就只有分析现有Zion和ZionEX,再了解这些设计如何演变、又为何这样演变。

Zion系统之所以值得关注,主要原因有下面几点。除了设计中固有的OAM外形尺寸加可重配置的PCI-Express交换结构拓扑,Zion设备还非常直接地关注CPU与GPU,为二者各自匹配了又大又慢的普通DDR和又小又快的HBM内存。另外,Facebook(当时还不叫Meta Platforms)要求英特尔在“Cooper Lake”至强SP处理器的AVX-512矢量引擎中添加BF16半精度浮点数学指令,借此匹配当时GPU上常见的BF16浮点运算。

通过这样的内存设计与通用的数据格式加处理方法,Facebook得以简化一部分机器学习数据流和转换负载。具体来讲,Zion服务器节点的8个CPU与6 TB内存,意味着TB级的DLRM能够全面被放置进主CPU内存当中,而DLRM的计算部分则可移交至GPU,并根据需要快速从CPU主内存处提取数据、放入HBM高速内存。

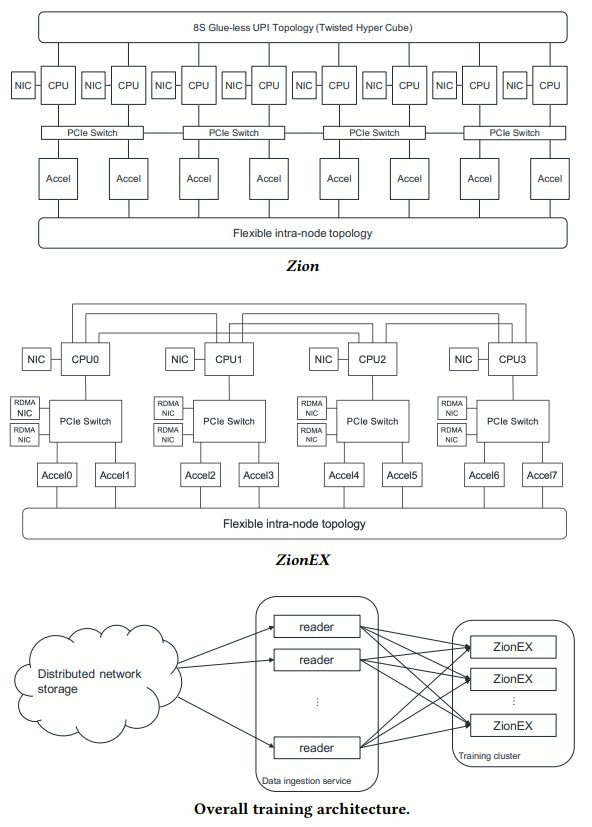

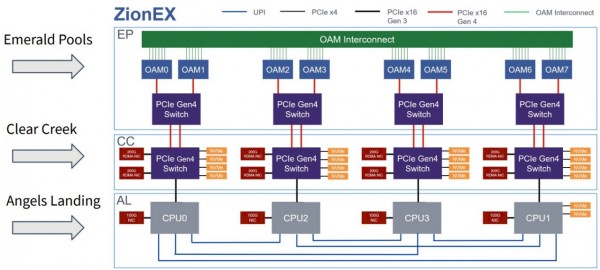

如上图所示,Zion中的八个Cooper Lake至强SP通过英特尔UltraPath Interconnect(UPI)以扭曲的超立方体拓扑(就是说八个CPU中的六个间有一个跃点,而另外两个CPU间则有两个跃点)无缝接入CPU上的100 Gb/s网络接口。另有四个嵌入OAM板的PCI-Express交换机,各交换机都拥有可重配置的结构,能够将GPU相互连接并接入CPU。

Zion内的八路CPU服务器实际上由四块双插槽“Angles Landing”CPU卡组成,单卡配备高达1.5 TB的内存和四个支持OCP 3.0规格夹层卡的100 Gb/s以太网卡。堆叠其上的则是“Emerald Pools”GPU机箱,其中包含四个PCI-Express 4.0交换机,用于将八个OAM GPU相互连接,再逐一接入Zion系统中的八个CPU。

借助ZionEX系统,Facebook在GPU和CPU之间添加了一个中间交换层。居于蹭的PCI-Exprses交换机综合体名为“Clear Creek”,由四个PCI-Express 4.0交换机组成,可提供八个200 Gb/s以太网卡以实现Zion各节点的相互捆绑,同时为16个E1.2或M.2闪存驱动器提供本地存储空间。其中每个PCI-Express交换机最多可以接入四块NVM-Express闪存驱动器。

另外,Facebook虽然没有提到,但Zion和ZionEX设备都能配置单、双或四个双插槽CPU计算底座,而不必配备完整的四底座。其中ZionEX采用了双底座加四插槽的默认设计,而如果DLRM模型未超过CPU计算和DDR4内存容量上限,也可选择单底座配置。

下面来看另一张ZionEX示意图,这里明确给出了整个层次结构的连接方式:

不同于包含多个独立子系统的Zion和ZionEX,Grand Teton系统采取的是单主板设计,所有组件(包括CPU、GPU、PCI-Express交换机和网络接口卡)都可插入其中。

这样能提升系统可靠性,减少线缆和连接数量,降低故障几率。事实上,Grand Teton的设计完全取消了除电源和网络之外的任何外部走线。

Meta Platforms目前对Grand Teton系统的性能指标避而不谈,所以只能从搭载的CPU和GPU身上找线索。考虑到Facebook在基础设施工作负载方面长期依赖于英特尔的至强D处理器,所以我们猜测Grand Teton将继续使用“Sapphire Rapids”至强SP承载CPU计算,PCI-Express 5.0负责提供交换功能,GPU则提供英伟达/AMD/英特尔三种选择。

这非常符合逻辑。Cooper Lake至强SP提供16条指向Clear Creek交换机节点的PCI-Express 3.0链路,将其直接升级为PCI-Express 5.0链路可以直接将主机交换带宽提升4倍。为了与之写道我,Grand Teton系统板应该会使用相应的PCI-Express交换机,并将与GPU连接的交换机上的网络接口升级为400 Gb.s RoCE Ethernet。而且根据Meta Platforms博文所言,CPU主机也将采用200 Gb/s以太网端口以提供2倍的计算和数据网络带宽。

更有趣的是Grand Teton系统能够承受两倍的系统发热量,Bjorlin在博文中对这项优化的重要意义做出了解释。

“可以看到,功率增长和对液冷设计的需求已经成为主流趋势,迫使我们以不同于以往的思路看待平台、机架、电源以及数据中心内的各种设计元素。下图所示为高带宽内存(HBM)和训练模块在未来几年内的功率增长预测,以及这些趋势将如何随时间推移匹配不同的冷却技术和运行极限。”

借助主液冷、辅风冷的设计(即先由液体冷却在机箱内转移热量,再集中至数据中心的热通道内通过风冷降温)以及设施整体水冷体系,机架中的热量将被高效转移。Meta Platforms的这套方案能够容纳发热量更大的GPU和HBM内存堆栈,将每个插槽的功率极限提升至1300瓦,借此满足DLRM系统对于更大资源容量的疯狂需求。

用数据填满Grand Canyon

Meta Platforms在讨论新一代“Grand Canyon”存储阵列时,提到其同时支持磁盘驱动器与闪存模块。相关规格已经于9月14日正式发布,感兴趣的朋友可以点击此处查看(https://www.opencompute.org/documents/grand-canyon-storage-system-specification-v1-0-pdf)。

Grand Canyon存储阵列能在单一4OU OpenRack机箱中容纳72块驱动器,分为两个控制平面。每个控制平面对应一个“Barton Springs”微服务器,带有一块26核“Cooper Lake”至强SP处理器、64 GB/128 GB DDR2内存、两个2 TB E1.S闪存单元、博通SAS控制器及扩展器,以及一个50 Gb/s OCP 3.0网络接口(最终将升级至100 Gb/s)。Grand Canyon主要充当高密度存储系统,因此速度表现也许不会太好。

好文章,需要你的鼓励

AI如何重振电商客户信任度

生成式AI在电商领域发展迅速,但真正的客户信任来自可靠的购物体验。数据显示近70%的在线购物者会放弃购物车,主要因为结账缓慢、隐藏费用等问题。AI基础设施工具正在解决这些信任危机,通过实时库存监控、动态结账优化和智能物流配送,帮助商家在售前、售中、售后各环节提升可靠性,最终将一次性买家转化为忠实客户。

SCB集团团队突破传统RAG技术壁垒:打造超大规模网络知识库的高速检索新方案

泰国SCBX金融集团开发的DoTA-RAG系统通过动态路由和混合检索技术,成功解决了大规模知识库检索中速度与准确性难以兼得的难题。系统将1500万文档的搜索空间缩小92%,响应时间从100秒降至35秒,正确性评分提升96%,为企业级智能问答系统提供了实用的技术方案。

Qumulo推出Stratus架构实现安全多租户环境

存储供应商Qumulo发布多租户架构Stratus,为每个租户提供独立的虚拟环境,通过加密技术和租户专用密钥管理系统实现隔离。该统一文件和对象存储软件支持本地、边缘、数据中心及AWS、Azure等云环境部署。Stratus采用加密隔离技术确保敏感数据安全,同时提供任务关键操作所需的灵活性和效率,帮助联邦和企业客户满足合规要求。

VGR:中科院和字节跳动的AI突破——让机器真正“看懂“图片再推理

中科院和字节跳动联合开发了VGR视觉锚定推理系统,突破了传统AI只能粗略"看图"的局限。该系统能在推理过程中主动关注图片关键区域,像人类一样仔细观察细节后再得出结论。实验显示VGR在图表理解等任务上性能大幅提升,同时计算效率更高,代表了多模态AI"可视化推理"的重要进展。

AI如何重振电商客户信任度

Qumulo推出Stratus架构实现安全多租户环境

氛围编程诞生四个月后:软件开发正在发生根本性变革

拉美数据中心淘金热背后的重大风险

诺基亚发布自主网络架构平台

华为携手产业达成移动AI基础网共识,加速5G-A体验变现

北京联通携手华为拥抱AI技术革命,加速迈入智能时代

算力狂飙时代:新华三如何掀起底座革命?

AI应用核爆时代,智算网络如何“接招”?

训练成本低至惊人!MiniMax 开源Flash Attention机制的 M1 推理模型

马斯克现身YC大会:谈"智能大爆炸"时代的生存法则,结合PayPal、SpaceX、特斯拉、xAI创业史,详解如何使用第一性原理

全球领头CRM,如何在中国跑出新模式?

最热门的 AI 模型:它们的功能和使用方法

这款古怪的 AI 智能手机可以创建你的数字分身

Faireez 获 750 万美元融资,为租赁市场提供 AI 驱动的酒店式管家服务

Broadcom 大获全胜:70% 大型 VMware 客户购买其最全面解决方案

Peer 获得1050万美元元宇宙引擎投资,推出3D个人星球功能

获 3000 万美元融资,Crogl 发布面向安全分析师的全新 AI "钢铁侠战衣"

Turing 获得 1.11 亿美元融资,估值达到 22 亿美元,为 OpenAI 等大语言模型公司提供关键代码支持

Tavus 推出系列 AI 模型,实现实时人脸交互技术突破

Welevel 获得 570 万美元融资,革新程序化游戏开发

AI 驱动的卓越运营:企业如何通过人人可及的流程智能提升成功