谷歌第四代TPU详细信息曝光 AI负载运行速度大幅提升

谷歌今天分享了有关最新一代TPU芯片的早期细节。该芯片用于运行人工智能工作负载,性能是上一代的2倍多。

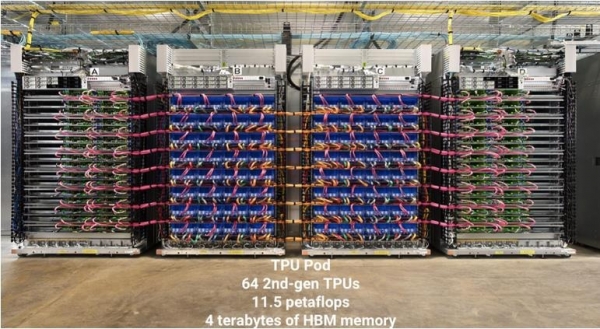

谷歌的TPU(Tensor Processor Unit)是一种基于AI的、应用特定的集成电路。今天谷歌详细介绍的是第四代TPU的情况,第三代和第二代此前展示出了令人印象深刻的性能水平,谷歌通过 Google Cloud Platform向企业提供这两代芯片。

谷歌称,第四代TPU的平均性能比第三代TPU高出2.7倍。谷歌在最近MLPerf行业竞赛中对比了这两代芯片训练五个主流AI模型的速度。第四代TPU在运行Mask R-CNN模型(用于自动驾驶等用例的图像分割AI)时达到了最高性能,训练速度比上一代芯片快3.7倍。

性能上的大幅提升主要源自于底层的巨大改进。谷歌工程师Naveen Kumar在博客文章中详细介绍称,谷歌已经大幅提高了TPU的内存带宽,也就是芯片从内存中获取数据并进行处理的速度,提高了执行专有计算的性能。

Kumar在帖子中详细介绍说:“谷歌第四代TPU ASIC在运行矩阵乘法(AI模型用来处理数据的一种数学运算方式)的TFLOP性能是TPU v3的2倍多。”与第四代芯片相比,第三代TPU的浮点运算性能为420万亿次。

Kumar称,客户可以很快将会获得有关新一代TPU的更多信息。考虑到目前Google Cloud平台上已经有两个上一代TPU可供租用,所以新一代应用很有可能最终也将落地在Google Cloud在会上。但是,客户可能需要一段时间了,根据ExtremeTech报告称,第四代TPU在MLPerf竞赛期间被列为研究类,也就是说,这款芯片至少在六个月内是无法商用的。

新一代芯片在速度上的提升尤其引人注目,因为它在性能上超过了第三代,在同一项比赛中打破了多个记录。谷歌利用4090个第三代TPU打造了所谓全球最快的AI训练超级计算机。该系统在8个MLPerf基准测试中创下了6项新的记录,并在不到30秒的时间内训练了4个测试模型。

好文章,需要你的鼓励

智能体将调用企业API:Atlassian等巨头的前瞻布局

Atlassian、Intuit和AWS三大企业巨头正在为智能代理时代做准备,重新思考软件构建方式。当前企业API为人类使用而设计,未来API将成为多模型原生接口。Intuit在QuickBooks中应用自动发票生成,使企业平均提前5天收款;AWS通过AI辅助迁移服务显著提升效率;Atlassian推出内部员工入职代理和客户代理,节省大量时间成本。专家强调需要建立强大的数据架构和信任机制。

研究机构能否教会AI自主扩展科学研究?波士顿大学团队揭示代码智能体的“研究盲区“

这项研究首次系统评估了AI代码智能体在科学研究扩展方面的能力。研究团队设计了包含12个真实研究任务的REXBENCH基准,测试了九个先进AI智能体的表现。结果显示,即使最优秀的智能体成功率也仅为25%,远低于实用化要求,揭示了当前AI在处理复杂科学推理任务时的显著局限性。

使用ChatGPT时大脑会发生什么?科学家进行了研究

MIT研究发现,使用生成式AI完成任务时,大脑运作方式与单纯依靠自身思考存在显著差异。研究显示,使用ChatGPT等工具的用户记忆力更差,神经连接活动减少,对所写内容的回忆能力明显下降。虽然AI工具能提高效率,但可能导致用户缺乏对知识的深度理解和掌控感。研究强调需要更多科学数据来了解AI使用对人类认知的长期影响。

俄罗斯研究团队推出光流估计新方法:让超高清视频分析更省内存、更精准

俄罗斯莫斯科国立大学研究团队开发出MEMFOF光流估计新方法,在保持顶尖精度的同时将1080p视频分析的GPU内存消耗从8GB降至2GB,实现约4倍内存节省。该方法通过三帧策略、相关性体积优化和高分辨率训练在多个国际基准测试中取得第一名成绩,为高清视频分析技术的普及奠定基础。

戴尔科技网络弹性解决方案,助力企业筑牢数据安全防线

智能体将调用企业API:Atlassian等巨头的前瞻布局

使用ChatGPT时大脑会发生什么?科学家进行了研究

花岗岩演示展现AI数据中心绿色挖掘能力

OpenAI与谷歌合作测试TPU芯片但暂无大规模部署计划

Cerabyte承诺到2030年推出快速、高密度、低成本的磁带替代方案

阿里巴巴扩展马来西亚和菲律宾AI云服务

超越计算机视觉:实验室培养大脑及其视觉机制

Digital Catapult获得英国先进连接技术里程碑式认证

Cloudian:AI推理将需要海量存储空间

智能体AI工作流自动化初创公司FileAI正式公开发布

AI机器人辩题、稳定币与AI竞赛持续发展