爱簿智能推出E300 AI计算模组:50TOPS国产算力,赋能边缘AI全场景高效部署

近日,爱簿智能正式推出面向边缘场景打造的E300 AI计算模组。

作为一家专注于系统级芯片(SoC)及智能终端设备的科技创新企业,爱簿智能致力于为业界提供领先的SoC、模组及智能终端解决方案。通过深度融合先进的半导体技术和人工智能技术,为用户打造更加智能、高效的全栈AI解决方案,助力各行各业加速数智化转型。

本次推出的产品,就是搭载爱簿智能自研AI SoC芯片AB100,其具备高达50TOPS的INT8算力和102GB/s LPDDR5内存带宽,支持FP16/FP32混合精度计算,专为边缘侧高性能AI任务设计,旨在为各行业提供高算力、低延迟、强可靠的国产化AI解决方案。依托全栈AI工具链与端云协同架构,E300深度融合边缘生成式AI与计算机视觉能力,可高效加速“云-边-端”等各AI场景的应用开发,为教育、能源、医疗、金融、交通等数字经济重点行业的智能化转型赋能。

技术创新:硬核算力,赋能边缘AI计算

E300所搭载的AB100芯片,采用“全大核CPU+先进GPU+高能效NPU”的异构计算架构,提供高达50TOPS的INT8算力,支持FP16/FP32混合精度计算,并配备102GB/s高带宽LPDDR5统一内存设计,可高效处理从轻量级推理到复杂模型部署的各类AI工作负载。通过架构级能效优化,AB100实现优异的功耗控制表现,确保设备在复杂边缘环境下长时间稳定运行。

针对边缘AI场景中图像识别、视频编解码、科学计算及深度学习训练等高密度计算场景中,E300展现出了卓越的性能表现:

- 大模型边缘推理:支持DeepSeek、Qwen、Llama等主流开源大模型;本地最高可部署32B参数的大语言模型。

- 计算机视觉全流程加速:支持YOLO、RESNET等上百种视觉模型的推理;基于CoCo128数据集的YOLOv8s AI训练,处理128张图的时间仅为21秒。

- 高性能图形处理:可实现34万面片的3D数字人实时Unity图形渲染,帧率最高达120 帧/秒;在WebGL-Aquarium性能测试中,相较于其他国产独立GPU,性能提升13倍。

- 科学计算优化:相较Arm V8架构大核CPU,FFT科学计算性能提升6倍。

- 专业级视频处理:支持8K30帧视频编解码,并可实现16路1080P30帧视频编码。

灵活部署:模块化设计,适配多元边缘场景

E300以创新的模块化系统设计,将强大算力浓缩于60mm×82mm的小巧模组中,集成SoC芯片、内存、电源管理单元及多种高速接口,具备出色的扩展性与适应性,可灵活部署于工业现场、户外环境等多种边缘场景。

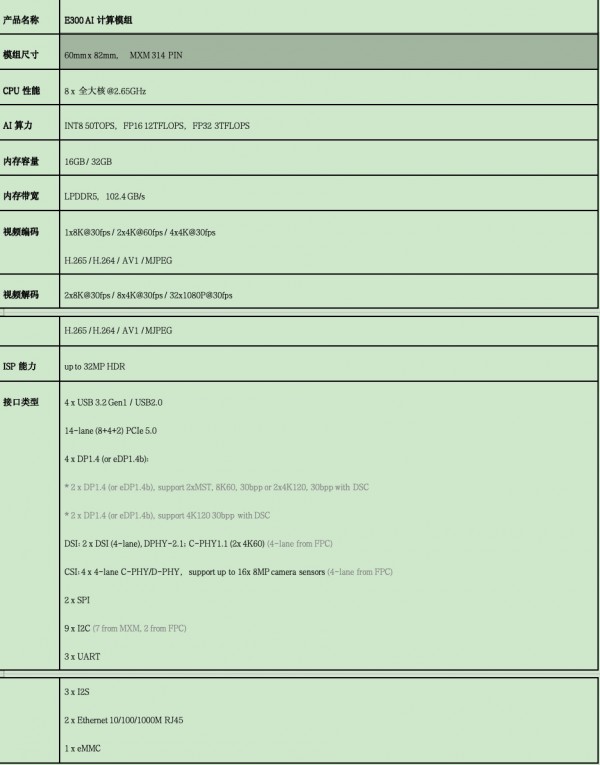

- 模块化+多接口,适配复杂场景:E300是一款小型化且高度集成的系统模组(SOM),支持从嵌入式集成到独立设备的多种部署形态。该模组提供卓越的扩展能力,支持4个USB 3.2 Gen1/USB 2.0、14通道PCIe 5.0高速总线,最高支持2个8K或最多8个4K高清显示输出(DP1.4/eDP1.4b),最多可支持16个8MP摄像头(4x4-lane C/D-PHY),还支持双千兆以太网、eMMC存储及丰富的工业接口(SPI/I2C/UART/I2S),满足边缘计算对多传感器接入、高速数据传输与多屏协同的应用需求。

- 完整的开发套件,快速实现产品化:爱簿智能提供E300模组的完整开发套件,包含模组、开发板、散热、存储和电源等组件,以及技术文档和专项支持,旨在大幅简化开发流程,降低开发门槛,显著缩短产品开发周期,助力用户快速实现产品化落地与规模扩展。

- 成熟的参考设计,推动商业化落地:依托爱簿智能完善的生态系统,用户可获取全面的软硬件设计参考方案,确保系统级的兼容性,实现从模组到整机的高效开发,加速AI边缘设备的商业化落地,助力用户在市场竞争中抢占先机。

全栈赋能:端云协同,覆盖“云边端”全场景

爱簿智能基于“芯片-系统-算法-应用”的全栈能力,构建了端云协同的智算基座,实现边缘AI的垂直优化与端云无缝协同,全面覆盖“云边端”全场景。

- 全栈AI开发与部署能力:兼容PyTorch、vLLM等主流AI框架,支持训练与推理全流程。在大模型优化领域,能够高效运行DeepSeek、Qwen、Llama 等主流开源大语言模型,并通过量化与剪枝技术,实现百亿参数大模型的边缘侧轻量化部署。同时,支持从边缘侧设备到云侧智算集群的弹性扩展,满足算力的平滑扩容需求。

- 多场景高性能加速:针对业界主流大语言模型,YOLO、ResNet等上百种计算机视觉模型,以及语音模型、文生图模型(如Stable Diffusion)、多模态模型和科学计算(如FFT)等各类模型,提供高效的推理加速,全方位满足多样化的边缘场景应用需求。

- 广泛的生态兼容性:支持国际主流的CUDA生态和国产MUSA生态,为开发者配备全套迁移工具链,可快速实现代码的跨平台迁移,显著降低技术适配成本。

- 全流程开发支持:提供从多传感器数据采集、模型训练到推理部署的一站式工具链,有效降低AI工程化门槛。

自主安全:打造国产可控的边缘AI平台

在数智化转型加速演进的浪潮中,算力自主可控逐渐成为产业发展的核心命题。E300搭载自研的国产AI SoC芯片AB100,构建起从硬件到软件的全栈安全。借助强大的边缘AI计算能力,E300支持数据本地处理与私有化部署,能够有效保护数据隐私与系统安全,全面满足工业、能源、水利、气象、政务、教育等关键领域对高安全性、高可靠性AI应用的严苛要求,为行业用户提供高性能、自主可控的边缘AI计算解决方案。

爱簿智能创始人兼CEO孙玉昆表示:“E300 AI计算模组的发布,是爱簿智能深耕智能计算领域的重要成果。这款全栈国产化的高性能边缘AI产品,将为各行业提供自主可控的算力新选择,加速重点行业智能化转型。未来,爱簿智能将持续以技术创新为引擎,联合产业链上下游生态伙伴,构建开放协同的智能计算新生态,推动AI算力在更多垂直场景中深度落地,为数字中国建设注入强劲动能。”

附:E300 AI模组详细参数

来源:业界供稿

好文章,需要你的鼓励

据说算力高达1000 TOPS,华硕Ascent GX10深度评测——开箱

当超级计算机被压缩进一个比书本还小的盒子里,这画面有多炸裂?想象一下,你桌面上摆着的不是什么花瓶摆件,而是一台能跑200B参数AI推理的"超算怪兽"——这就是我们今天要聊的主角:华硕Ascent GX10。

Adobe与UCLA联手突破AI模型速度瓶颈:让图像生成快一倍的“稀疏化魔法“

Adobe研究院与UCLA合作开发的Sparse-LaViDa技术通过创新的"稀疏表示"方法,成功将AI图像生成速度提升一倍。该技术巧妙地让AI只处理必要的图像区域,使用特殊"寄存器令牌"管理其余部分,在文本到图像生成、图像编辑和数学推理等任务中实现显著加速,同时完全保持了输出质量。

不用再训练AI模型,香港科技大学团队发明“智能管家“,让AI一眼就知道该抓哪里用哪里

香港科技大学团队开发出A4-Agent智能系统,无需训练即可让AI理解物品的可操作性。该系统通过"想象-思考-定位"三步法模仿人类认知过程,在多个测试中超越了需要专门训练的传统方法。这项技术为智能机器人发展提供了新思路,使其能够像人类一样举一反三地处理未见过的新物品和任务。

# 思科自研AI模型正式应用于产品,首先赋能身份安全服务

超大规模云厂商在2025年是解决了电力问题还是重新思考了问题?

# 英伟达成为唯一能免费提供AI模型的厂商

Retell AI推出自动化质检系统,解决语音智能体人工审核瓶颈

# 法国生物科技公司发布全球首个生物学通用AI模型

# JEDEC开发减少引脚数的HBM4标准以提升容量

# Ewigbyte光学归档存储技术及战略解析

2025年:可穿戴设备全面转向AI技术

# Oracle领衔科技巨头5000亿美元AI数据中心租赁狂潮

新农人:西云数据如何绘制智慧农牧“全景图”

据说算力高达1000 TOPS,华硕Ascent GX10深度评测——开箱

苹果发现:只需一个注意力层,就能让AI图像生成既快又好