领跑后训练时代,联想以“四维”进化重塑AI算力格局

作为一家拥有33年服务器研发历史的企业,联想一直在坚持不懈地引领着服务器的技术创新,为客户业务应用不断重新定义新的算力。

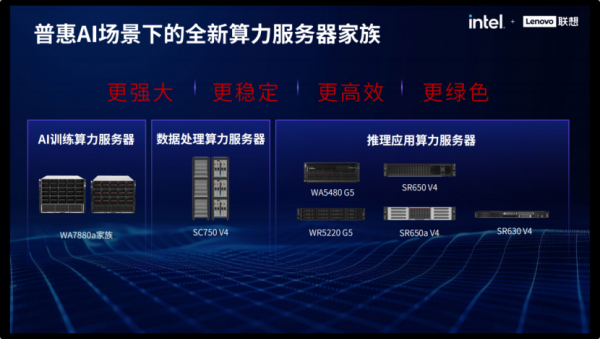

早在几年前,联想就提出了高性能、高可靠、高可扩展、低能耗(“三高一低”)的服务器设计理念。如今,随着AI应用进入百花齐放的后训练时代,联想对“三高一低”的设计理念进一步演进,提出打造“更强大、更稳定、更高效、更绿色”的算力基础设施,并针对业务数据到智能业务全过程的三个关键应用场景——数据处理、模型训练和推理应用分别进行优化,形成数据处理算力服务器、AI训练算力服务器、推理应用算力服务器三大家族。

在日前举行的联想创新科技大会上,联想对三大服务器产品家族全线升级,并推出了一系列服务器新品,以帮助企业构建更强大、更高效、更稳定、更绿色的混合式基础设施,助力人工智能的快速落地。这些产品包括:

- 数据处理算力服务器联想ThinkSystem SC750 V4

- AI训练算力服务器联想问天 WA7880a家族

- 推理应用算力服务器联想问天 WA5480 G5、WR5220 G5、联想ThinkSystem SR650 V4、SR650a V4、SR630 V4

这些服务器新品都采用了英特尔最新一代处理器——英特尔®至强®6,与上一代处理器相比,配备更多内核和更快内存,每个内核均内置 Al加速功能,性能更上一层楼。同时,它们分别面向不同的AI应用场景进行了针对性优化,以充分释放这些服务器的算力潜能。

- 联想数据处理算力服务器家族:高密度架构提升数据处理效率

数据预处理是人工智能应用的第一步。在此阶段需要利用服务器对业务数据和公共数据进行加工和处理,这不仅要求服务器具有强大的性能,还要保证算力稳定可靠,同时服务器还要有较高的数据带宽,以保障数据高速传输。

联想数据处理算力服务器系列在单一机柜中能够实现高达48个计算节点,可配置12288个英特尔®至强®6性能核心,再结合8800MHz的MRDIMM,可以极大地提升生成式人工智能的性能。

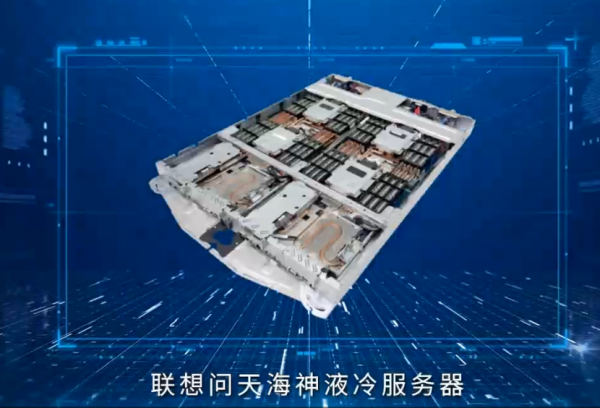

随着机柜内节点数量的增加和处理器核心数量的不断攀升,散热问题开始凸显,从风冷转向液冷成为必然。联想采用专利的无滴漏不锈钢盲配机制,使用航空级防滴连接器与计算托盘紧密相连。13U16节点的高密度全液冷设计,整机无需风扇,既减少高频振动的潜在影响,又有效整合空间效率,而且持续运行在Turbo模式可大幅提升算力效率,节约40%的数据中心能耗。

- 联想AI训练算力服务器家族:异构计算与智能调度驱动千亿模型

模型训练通常需要借助多GPU卡来完成以支持千亿级参数规模模型训练,因此AI训练服务器必须支持GPU+CPU的异构计算组合,以及解决多GPU卡部署带来的制冷挑战。

联想AI训练算力服务器配置2颗英特尔®至强®6处理器,8块GPU通过OAM互联,可为模型训练应用输出澎湃算力。而在散热方面,服务器支持联想冷板式CPU/GPU液冷方案和600W以上处理器浸没式液冷技术,为AI训练服务器家族绿色节能提供保障。

AI训练服务器不仅仅是硬件组合,为了将服务器的性能发挥到极致,还要有一个强大的算力调度平台。

联想AI训练服务器还有联想万全异构智算平台 3.0的加持,借助它不仅可以实现异构的算力调度,而且还通过异步读写访存优化、算子优化和计算路径优化等,降低训练开销15%以上。实测结果显示,联想单台8卡 GPU服务器部署DeepSeek,吞吐量达到12000tokens/s,整个记录目前还在不断地刷新中。

联想推理应用算力服务器:全域覆盖加速智能决策落地

推理和决策是人工智能应用价值的最终落地。为了满足推理应用的需求,服务器需要具有通用性,要同时支持CPU和GPU,还要支持各种内存和网卡等。

联想推理应用算力服务器系列支持英特尔®至强®6和主流PCIe GPU,每个CPU内核都集成了英特尔AMX BF16和FP16加速器,在推理应用中与GPU配合性能天衣无缝,甚至直接调用CPU算力就能支持小规模推理业务。

在散热方面,联想推理应用算力服务器也支持CPU/GPU/MEM/VR的全液冷方案,结合英特尔®至强®6能效核优异的能耗性能比,能为客户提供2倍性能、4倍性能功耗比。

作为AI时代下的弄潮儿,2024年联想服务器在不断的追求超越,具有与时俱进的产品理念和前瞻性布局。根据IDC最新季度服务器跟踪报告,2024年实现了全年180%的最快市场增长。2025年是全球人工智能基础设施持续演进的关键之年。联想服务器将始终坚持通过技术创新与生态共建双轮驱动,助力行业客户突破人工智能规模化部署的各种技术瓶颈,矢志不渝地扮演技术创新与场景落地的核心推动力量。

来源:业界供稿

好文章,需要你的鼓励

据说算力高达1000 TOPS,华硕Ascent GX10深度评测——开箱

当超级计算机被压缩进一个比书本还小的盒子里,这画面有多炸裂?想象一下,你桌面上摆着的不是什么花瓶摆件,而是一台能跑200B参数AI推理的"超算怪兽"——这就是我们今天要聊的主角:华硕Ascent GX10。

Adobe与UCLA联手突破AI模型速度瓶颈:让图像生成快一倍的“稀疏化魔法“

Adobe研究院与UCLA合作开发的Sparse-LaViDa技术通过创新的"稀疏表示"方法,成功将AI图像生成速度提升一倍。该技术巧妙地让AI只处理必要的图像区域,使用特殊"寄存器令牌"管理其余部分,在文本到图像生成、图像编辑和数学推理等任务中实现显著加速,同时完全保持了输出质量。

不用再训练AI模型,香港科技大学团队发明“智能管家“,让AI一眼就知道该抓哪里用哪里

香港科技大学团队开发出A4-Agent智能系统,无需训练即可让AI理解物品的可操作性。该系统通过"想象-思考-定位"三步法模仿人类认知过程,在多个测试中超越了需要专门训练的传统方法。这项技术为智能机器人发展提供了新思路,使其能够像人类一样举一反三地处理未见过的新物品和任务。

据说算力高达1000 TOPS,华硕Ascent GX10深度评测——开箱

苹果发现:只需一个注意力层,就能让AI图像生成既快又好

YouTube推出基于Gemini 3的创作者游戏制作工具

英伟达是唯一能负担免费提供AI模型的厂商

OpenAI发布新旗舰图像生成AI模型GPT Image 1.5

脑启发算法可大幅降低AI能耗

Mac办公桌升级必备配件指南:提升工作效率的最佳选择

PTC Windchill+ 助力 HOLON研发全球首批符合汽车行业标准的 L4 级电动汽车

航旅行业的AI“乘法效应”:迈向指数级进化

OpenAI推出GPT Image 1.5模型加速图像生成竞争

Zoom推出AI Companion 3.0智能体工作流程

ChatGPT成为互联网最受阻止的爬虫机器人