思科将大规模AI基础设施塞入小型服务器套件

思科计算高级副总裁兼总经理Jeremy Foster在最近的IT供应商客户顾问委员会会议上,就发现几乎所有企业都正在不同程度地开展AI项目。

Foster在采访中指出,“其中一些项目可能是从云端起步,有些项目可能是从本地项目开始,但总体上这种变化趋势要比过去六个月乃至更久之前明显加快。我们也相信这股势头还将持续下去。其中一些企业已经提交了初始订单,正在等待交付。在预约到交付之间的这段时间,他们正积极设计用例并思考如何开发应用程序以创造价值。尽管仍处于早期规划阶段,但对生成式AI项目的应用占比已经从原先的十之一二快速增长至如今的十之八九。相信在收到设施资源之后,他们会立即行动起来。”

而企业必须面对的一大现实挑战,就是确保掌握运行AI工作负载所需要的正常基础设施。根据思科的AI就绪指数,89%的受访IT专业人士表示他们计划在未来两年之内部署AI工作负载,但只有14%的受访者确认其基础设施已经为这类新型工作负载做好了准备。而对基础设施的全面改造,往往是一项昂贵且复杂的任务。

思科希望通过本周在洛杉矶合作伙伴峰值上公布的全新硬件产品,让这场转型来得更轻松、更便宜。相关产品基于其UCS产品组合以及经过验证的设计方案,努力将更多所需技术整合进这些高度集成的系统当中。这些产品对于正权衡到底是在云端、抑或是本地执行AI任务的企业来说,不啻于一份厚礼。

思科计算产品管理副总裁Daniel McGinniss在采访中表示,“我们看到很多客户更倾向于选择本地部署,而具体基础设施模式则视工作负载需求而定。比如说以企业身份在云端运行模型训练,而后再转向本地。业务数据一般都集中在本地设施之内,这一点非常重要。因此对于最重要、对业务影响最大的应用程序,企业肯定更希望能在本地基础设施上运行。这也符合我们观察到的普遍情况,即将全部业务用例都汇总起来,尽可能排除干扰和外泄因素。总之,不同需求对应的基础设施模式也是各不相同的。企业可能会在CPU上运行推理,但不会在CPU上运行训练。我们的不少大型企业客户则更加灵活,可能在云端进行模型训练,也有可能在本地基础设施上完成训练。”

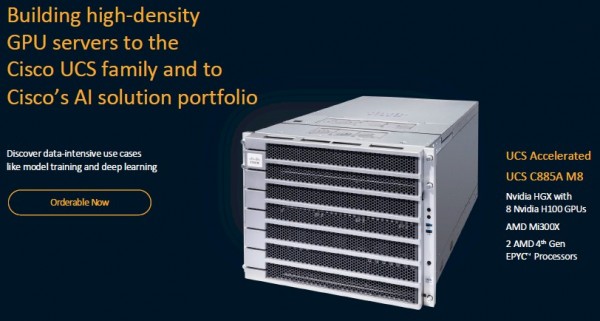

在本次会议上,思科发布了UCS C885A M8服务器,专门用于处理大规模GPU密集型AI训练与推理任务。这是UCS产品家族中的最新成员,思科于2009年首次公布了这条产品线,当时希望在网络之外进一步拓展数据中心业务,借此与戴尔、惠普等厂商在计算领域展开竞争。

UCS C885A M8以英伟达的HGX超级计算平台作为构建基础,包含8张英伟达H100或H200 Tensor Core GPU或者8张AMD MI300X OAM GPU加速器(后续预计还将支持英特尔芯片),且每张GPU都配备一块英伟达ConnectX-7网络接口卡(NIC)或BlueField-3 SuperNIC,允许客户在服务器集群之上运行AI模型的训练工作负载。另有英伟达BlueField-3数据处理单元(DPU),同时配备两块AMD第四代或第五代EPYC芯片。

这些系统通过思科的Intersight云平台进行管理。

与此同时,思科还公布了AI POD。此POD扩展了思科另一套经过长期验证(这套设计方案发布已有20多年)的方案成果,用于为AI推理工作负载提供预配置的基础设施堆栈,能够从边缘部署扩展至大规模集群以实现检索增强生成(RAG)。

AI POD同样在很大程度上依托于英伟达技术,包括其GPU及AI Enterprise软件平台与HPC-X工具包,此外辅以思科自家的UCS X系列模块化设计、机箱、M7计算节点、带有英伟达GPU的PCI-Express节点、思科UCS结构互连以及Intersight管理软件。

其中还囊括了红帽OpenShift应用平台,并允许用户根据需求在Nutanix、NetAPp的FlexPod或者Pure Storage的FlashStack等方案间灵活做出选择。

思科的McGinnis表示,这样的技术堆栈对于仍在努力理解AI所需复杂基础设施环境的组织来说,无疑是大有裨益。

他解释道,“几十年来,人们一直在努力构建虚拟化环境。刚开始大家对此也不熟悉。而现在的生成式AI浪潮又带来了类似的问题,可以说是历史的重演。整体堆栈的概念确实能让客户感到安心,缓解他们对于未知的焦虑和恐惧。比如他们并不清楚要如何确定环境规模,也不了解该如何搭配CPU、内存、驱动器和GPU组合。这是个需要认真考虑的全新方向。而我们则为他们确定了设施规模,在必要时整个堆栈都将随时听候调遣。而随着他们更好地了解自己的需求和环境,客户可以进一步做出定制和调整。但作为启动的第一步,整体解决方案这个概念往往非常重要。”

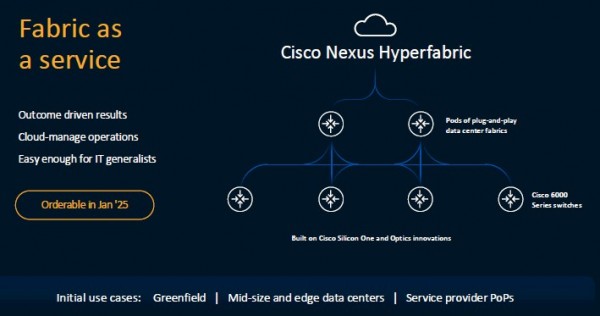

UCS C885A M8服务器(现已开放订购,并将于今年年底发货)和AI POD(11月内开放订购)正是思科不断增长的AI基础设施产品家族中的最新成员,其他成员还包括运行在思科Silicon One G200芯片上的800G Nexus交换平台,以及与英伟达合作开发并于今年6月推出的Nexus HyperFabric AI集群——其将思科AI网络同英伟达的加速计算和AI Enterprise软件,连同VAST数据存储全面融合了起来。

思科的Foster表示,Nexus HyperFabric AI集群将于明年开始开放订购,希望能帮助更多企业快速建立起业务需要的AI网络。

Foster总结道,“如果大家打算训练两套网络,那就得区分前端网络和后端网络。现在我们将其合并成统一的以太网网络,允许客户将管理能力从网络一直延伸到服务器上的网络接口卡,而后配合Intersight保持服务器环境的正常运行,再根据客户的用例需求进行整体环境优化。”

好文章,需要你的鼓励

OpenAI推出GPT Image 1.5模型加速图像生成竞争

OpenAI推出ChatGPT Images新版本GPT Image 1.5,承诺更好的指令遵循、更精确的编辑功能和高达4倍的图像生成速度。该模型面向所有ChatGPT用户和API开放。这是OpenAI在CEO奥特曼宣布"红色警报"后与谷歌Gemini竞争的最新升级。新模型提供后期制作功能,支持更精细的编辑控制,能在编辑过程中保持面部相似度、光照、构图和色调的视觉一致性,解决了传统AI图像工具迭代编辑时缺乏一致性的问题。

AI Institute杀手锏:用单元测试训练出超强文档识别神器,准确率飙升至82.4%

艾伦人工智能研究所开发的olmOCR 2通过创新的单元测试训练方法,将文档识别准确率提升至82.4%,在处理复杂数学公式、表格和多栏布局方面表现卓越。该系统采用强化学习和合成数据生成技术,实现了完全开源,为全球研究者提供了先进的OCR解决方案,推动了AI技术民主化发展。

Zoom推出AI Companion 3.0智能体工作流程

Zoom推出AI Companion 3.0,采用联邦AI架构结合自研模型与OpenAI、Anthropic等第三方大语言模型。新版本具备智能工作流、对话式工作界面等功能,可将会议对话转化为洞察、进度跟踪和文档内容。系统支持加密传输,不使用客户内容训练模型。用户可通过ai.zoom.us访问,或以每月10美元独立购买。

苹果公司发布Pico-Banana-400K:40万图片训练数据让AI修图像人类一样聪明

苹果公司发布了包含40万张图片修改案例的AI训练数据集Pico-Banana-400K,涵盖35种修图操作类型。该数据集采用严格质量控制,包含成功失败案例对比和多轮修图场景。研究显示AI在全局修改方面表现优秀,但精细操作仍有挑战。这为AI修图技术发展奠定基础,未来将让修图软件更智能易用。

Zoom推出AI Companion 3.0智能体工作流程

ChatGPT成为互联网最受阻止的爬虫机器人

英伟达推出开源权重模型填补美国AI市场空白

Meta推出SAM Audio模型:AI音频分离新突破

英伟达推动数据中心增长,以太网交换机销售创纪录

Quobyte推出GPU融合存储技术优化AI集群数据处理

泰恩港采用私有5G网络实现运营效率显著提升

艾伦人工智能研究所推出Molmo 2,为AI系统带来开放视频理解能力

Adobe Firefly新增基于提示词的视频编辑功能

对话AppsFlyer王玮:预算回升、格局收紧,“素材”成为新的竞争战场

NVIDIA Nemotron 3 系列开放模型: 击穿AI“工程墙”开启“Agentic AI”的“Linux时刻”

W.AWARDS金网奖2026未来商业计划领航秀峰会收官