全球AI服务器总投入达2万亿美元,人工智能正在吞噬整个世界

根据观察可以发现,尽管AMD和英伟达GPU的市占率增速确在加快,但AI数据中心加速器的预期增长率却有所放缓。

根据苏姿丰的预测,在生成式AI热潮的首个六年周期(2023年至2028年)之内,全球在数据中心AI加速器上投入的资金将在7000亿美元到9000亿美元之间,具体数字大家可以根据主观判断在区间内任意选择。也就是说,全球市场在AI系统上的支出总值将达到2万亿美元级别(我们将在后文中具体解释计算过程),人工智能正在吞噬整个世界。

希望不是字面意义上的“吞噬”才好。

我们首先得明确一点,相关性并不是因素性,因此AMD最新预测中AI加速器收入增幅放缓,并不单纯是因为AMD和英伟达正不断向市场中投放越来越多的GPU供应。但话又说回来,荣格曾经严格论证过同步性理论,这是一种只存在于高级生物头脑当中的非因果性关联原则,提醒我们在分析问题时别把逻辑挖得太深、时间推得太远。

不管具体原因如何吧,总之我们确实在为AI复合体支付成本,苏姿丰也在用实际行动不断推进这个依托于AI的总体目标市场(TAM)。就在上周,Advancing AI大会在旧金山召开,认为全世界在未来六年内将继续对AI进行巨额投入。

不断扩张的总体目标市场承载起各种加速器方案

早在2023年6月,在Datacenter and AI Technology Premiere大会的AMD CPU与GPU计算引擎增强功能预览环节,苏姿丰就曾经对计划于今年晚些时候推出的第三代“Antares”数据中心GPU做出过基准预测:

如果放大上图,就会发现其中标出了“数据中心AI加速器总体目标市场:GPU、FPGA和其他”,那接下来我们就围绕这几个重点展开讨论。

可以这么讲,FPGA目前对整体市场的影响甚至连噪声都称不上,这主要是因为GPU加速器在AI工作负载市场中的占比太过于庞大。至于其他部分,则大多数由后起之秀构成,其中可能包括/未包括谷歌、亚马逊云科技、微软、Meta Platforms等科技巨头自研加速器所创造的价值。

短短六个月之后,随着“Antares”MI300A和MI300X加速器的推出,生成式AI热潮迎来了首轮爆发,苏姿丰也再次大幅上调整了对于数据中心AI市值的预测。

不仅是2023年的基准收入水平将高于预期,从2023年至2027年之间的年均复合增长率(CAGR)也得到大幅上调,来到70%。最终结果就是,到2027年AMD预计加速器销售额将超过4000亿美元。

而随着上周Advancing AI大会上MI325X和MI355X的正式亮相,苏姿丰又做出了另一项预测,只是这次预测的终点从2027年延伸到了2028年:

数据中心AI加速器销售额的450亿美元保持不变,但现在预计终端收入为5000亿美元,年均复合增长率则以2028年(而非之前的2027年)计算。另外,随着预测周期的延长,原本的乐观期待也开始逐渐消退,导致年均复合增长率随之降低。最新版本认为这项增长率将只高于60%,而非70%。换句话说,苏姿丰和她的AMD在下调预期的同时又在周期上额外增加了一年,希望分散人们对于增长数字下滑的注意力。

重要提示:哪怕是给定了两个时间端点和年均复合增长率时,我们也无法真正判断这两端之间的具体数字走势。这有点像个黑匣子,唯一确定的就是开头的数字和末尾的数字。期间可能会出现大幅震荡,但与之对应的处均复合增长率并不会改变。这虽然限制了这项指标的重要性,但已经是我们能够用于预测的最佳工具,帮助我们在两个端点之间进行线性思考,而且任何差异都将在足够长的时间内被平均化分摊。

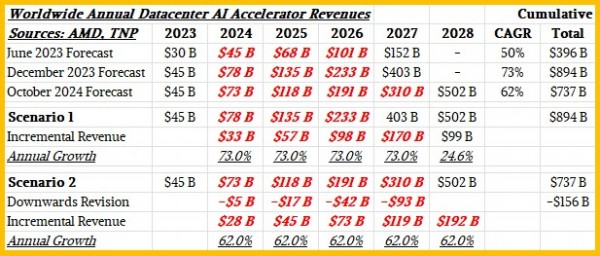

因此,如果我们假设AMD对于数据中心AI加速器支出的这三条预测在两个时间端点间呈线性增长,那么在均匀补充上中间的空白之后,最终结果将如下表所示:

中间几年的估算值以红色粗斜体标记,这是我们根据年均复合增长率计算得出的每一年销售总额。

根据AMD最新做出的预期调整,我们可以用两种潜在方式填充这份图表。

第一种就是继续保留之前 2023年12月公布的2023年至2027年AI加速器销售额预测,只额外添加2028年的新终点。我们认为AMD想要表达的肯定不是这个意思,因为如果是这样,那就意味着如上表所示,2028年AI加速器支出增长将会大幅放缓。

第二种情况则是对整个预测模型做出修订,这应该也是AMD想要达到的效果(否则也无法解释为什么此次公布了更低的年均复合增长率数字)。如大家所见,2024年至2027年(含)之间有1560亿美元AI加速器销售额被从结果中移除。与2023年12月的此前预测相比,2024年10月最新预测的累计销售额将减少这1560亿美元。

AI加速器成本约占其相关系统总体成本的一半,而网络则在其上再额外增加20%左右的投入。这种估算方法假设要部署大量闪存、主内存容量以及强大的主机CPU来驱动AI工作负载中的串行部分,由此建立起合理的AI服务器。在这个基础上再增加20%左右,就能计算出由AI服务器构建AI集群的网络成本。

那么如果将2023年至2028年AI加速器支出的7370亿美元乘以2,就能得到AI服务器支出约在1.5万亿美元左右,加上网络就是1.8万亿美元。最后加上系统软件,则基本可以认为期间AI系统总投入将达到2万亿美元量级。

如果接下来企业买家真的按照这个路子执行下去,那么除了AI服务器支出之外,其余服务器和存储市场遭遇衰退也就完全在情理之中了。

但现在,这已经是最后才需要考虑的因素了。如果全世界真的将在2023年至2028年这六年间在AI系统身上砸下2万亿美元,那么投资回报方面的压力肯定就相当大了。换句话说,我们希望在抵消经济成本的同时,再至少增加2万亿美元的经济收入。实际上,最好能把收益再提高一整个数量级。希望这种收益不是来自裁员,而是做出以往无法实现的探索。但哪怕是最乐观的猜测,裁员的贡献可能也要在其中占比一半。而且考虑到巨大的投入回报压力,再加上AI系统对于人类员工的替代效果,没准所有收益都是通过裁员方式来实现……至少我们要对此做好心理预期。

但千万不要忘记,如果人丢掉了工作,税收来源也将随之消失,自然谈不上什么全民基本收入。当然,时至今日也没有哪个人类经济实体能够真正贯彻全民基本收入,所以这事不提也罢。更加讽刺的是,那些整天喊着支持全民基本收入的家伙,脑袋里想的永远是不能影响到他们自己的收入。所以从这个角度讲,全民努力工作到老迈不堪才是最可能出现的结局。但无论是哪种情况,我希望这至少出自全人类的自主选择、出自全人类的共同福祉。

好文章,需要你的鼓励

西班牙病毒如何将谷歌带到马拉加

33年后,贝尔纳多·金特罗决定寻找改变他人生的那个人——创造马拉加病毒的匿名程序员。这个相对无害的病毒激发了金特罗对网络安全的热情,促使他创立了VirusTotal公司,该公司于2012年被谷歌收购。这次收购将谷歌的欧洲网络安全中心带到了马拉加,使这座西班牙城市转变为科技中心。通过深入研究病毒代码和媒体寻人,金特罗最终发现病毒创造者是已故的安东尼奥·恩里克·阿斯托尔加。

多伦多大学发现:聊天机器人的“嘴巴“影响它们的智商

这项由多伦多大学领导的研究首次系统性地揭示了分词器选择对语言模型性能的重大影响。通过训练14个仅在分词器上有差异的相同模型,并使用包含5000个现实场景测试样本的基准测试,研究发现分词器的算法设计比词汇表大小更重要,字符级处理虽然效率较低但稳定性更强,而Unicode格式化是所有分词器的普遍弱点。这一发现将推动AI系统基础组件的优化发展。

LangChain核心库曝出严重漏洞,AI智能体机密信息面临泄露风险

人工智能安全公司Cyata发现LangChain核心库存在严重漏洞"LangGrinch",CVE编号为2025-68664,CVSS评分达9.3分。该漏洞可导致攻击者窃取敏感机密信息,甚至可能升级为远程代码执行。LangChain核心库下载量约8.47亿次,是AI智能体生态系统的基础组件。漏洞源于序列化和反序列化注入问题,可通过提示注入触发。目前补丁已发布,建议立即更新至1.2.5或0.3.81版本。

北大研究团队颠覆视频AI训练新方法:让机器像人类一样“预测下一帧“学习世界

北京大学研究团队提出NExT-Vid方法,首次将自回归下一帧预测引入视频AI预训练。通过创新的上下文隔离设计和流匹配解码器,让机器像人类一样预测视频下一帧来学习理解视频内容。该方法在四个标准数据集上全面超越现有生成式预训练方法,为视频推荐、智能监控、医疗诊断等应用提供了新的技术基础。

LangChain核心库曝出严重漏洞,AI智能体机密信息面临泄露风险

Mill如何与亚马逊和全食超市达成合作协议

TechCrunch创业大赛中的9家顶尖生物技术初创公司

2025年印度科技领域十大重要发展

中科大发布Live Avatar:AI数字人无限聊天不翻车

从软件定义汽车到AI驱动质控:Testin云测助力车机测试数智化价值落地

无需Linux即可运行自由开源软件

超越 SEO:AI 引擎优化如何改变在线可见性格局

新Mac必装应用:五款提升工作效率的神器推荐

DXC蒲公英计划:为神经多样性IT专业人士赋能

AMD Strix Halo与Nvidia DGX Spark:哪款AI工作站更胜一筹?

类人机器人投资热潮涌现但商业化仍需数十年

性能狂飙70%!宝德 x 京东云AI存储一体机新品上市,重塑行业标杆

思科与英伟达扩大合作,助力企业加速应用AI技术

AMD 发布新一代 AMD RDNA(TM) 4 架构,推出 AMD Radeon(TM) RX 9000 系列显卡

两位前谷歌软件工程师,用AI改写黑夜成像规则

德勤2025技术趋势报告,AI与企业未来的交汇

英特尔推出搭载至强6处理器的卓越AI和网络解决方案

思科在Cisco Live阿姆斯特丹大会上展示简洁、安全和AI就绪的创新技术

区分“模型”和“应用”是对AI最大的误解

终端侧AI,如何从DeepSeek的连锁反应中受益?

Gartner发布2025年及未来中国企业实现AI价值的重要预测