NVIDIA最新“王炸” 最强“芯”开启30倍AI算力 征服AI生态版图疆域 原创

2024 年 3 月 18 日,2024 GTC大会上,NVIDIA 以高昂的姿态推出Blackwell 平台瞬间引爆全世界。这或许,是人类又一次向智能新时代宣誓——万亿参数规模的大语言模型(LLM)不再是遥不可及的梦想。

来源:NVIDIA

“1+1>2” 性能提升30倍

一直以来,NVIDIA 推出的GPU一般是两种架构,其中面向游戏的GeForce RTX系列GPU是Ada Lovelace架构,面向AI、大数据等应用的专业级显卡是Hopper架构。风靡世界的H100就是基于Hopper架构。

而这一次,老黄却说:“Hopper很棒,但我们需要更大的GPU,更需要将 GPU堆叠在一起。”

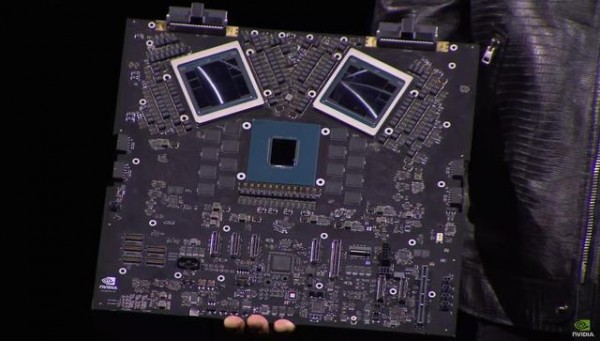

于是,同时用以上两种架构类型的产品Blackwell诞生了,NVIDIA采用D2D将两颗die互联封装,可以提供10TB/s的带宽。Blackwell 在单芯片训练方面的 FP8 性能是其上一代架构的 2.5 倍,在推理方面的 FP4 性能是其上一代架构的 5 倍。它具有第五代 NVLink 互连,速度是 Hopper 的两倍,并且可扩展至 576 个 GPU。

所以,Blackwell不是一个芯片,而是一个平台。

NVIDIA GB200 Grace Blackwell 超级芯片则是通过 900GB/s 超低功耗的片间互联,将两个 NVIDIA B200 Tensor Core GPU 与 NVIDIA Grace CPU 相连。其巨大的性能升级,能为人工智能公司提供20 petaflops或每秒2万亿次计算的AI性能,相较于H100,大语言模型性能提升30倍,同时能耗只有25分之一。

不难看出,Blackwell平台如此卓越的性能提升,是为了下一代生成式AI作准备。而从OpenAI最近发布的Sora和已经开始研发更强大、更复杂的GPT-5模型也能看出,生成式AI的下一步是多模态和视频,也就意味着更大规模的训练。Blackwell 带来了更多可能性。

面对新一代人工智能,英伟达已经准备好了!

正如老黄所言: “三十年来,我们一直深耕加速计算领域,力求实现像深度学习和 AI 这样的变革性突破。生成式 AI 是我们这个时代的决定性技术,Blackwell GPU 是推动新一轮工业革命的引擎。通过与全球最具活力的企业合作,我们将实现 AI 赋能各行各业的承诺。”

从谷歌的无边搜索引擎,到亚马逊的云顶天堂,再到特斯拉的智能驾驶......目前,各大科技巨头正纷纷加入 NVIDIA 的 Blackwell 阵营,开启了一场令人兴奋的 AI 加速计算盛宴!亚马逊、谷歌、戴尔、Meta、微软、OpenAI、Oracle、特斯拉和 xAI 等行业翘楚都在争先恐后地布局,准备在 AI 新时代大展身手。

这些公司都看到了 Blackwell 在加速计算和生成式 AI 领域的无限可能,并强调将利用 Blackwell的超能力重塑产品与未来。

“当下的 AI 领域,NVIDIA硬件无可比拟。”特斯拉及 xAI 首席执行官 Elon Musk这样说。

六大颠覆性新技术 加速AI未来

Blackwell GPU 架构具有六项变革性的加速计算技术,这些技术将助推数据处理、工程模拟、电子设计自动化、计算机辅助药物设计、量子计算和生成式 AI 等领域实现突破,这些都是 NVIDIA 眼中的新兴行业机遇:

来源:NVIDIA

史上最强“芯”

Blackwell 架构的 GPU 表现出了行业领先的技术创新和极限性能。拥有2080亿个晶体管的B200芯片就基于Blackwell架构,在目前的技术背景下,无疑将其定位为市场上最强大的GPU之一。这一巨大数量的晶体管意味着极高的计算能力和复杂度,使其能够处理最为复杂和要求苛刻的计算任务。

采用专门定制的“双倍光刻极限尺寸 4NP TSMC工艺”进一步印证了该GPU在制程技术上的领先地位。4NP代表了当前半导体制造中的尖端水平,而“双倍光刻极限尺寸”可能意味着它采用了更高精度的制造工艺,以实现更小的晶体管尺寸和更高的集成度。

此外,通过10 TB/s的片间互联技术,将GPU裸片连接成一块统一的GPU,这种设计思路在提高数据传输速度和降低延迟方面展现了显著优势。这种高速的片间互联使得多个GPU裸片能够高效协同工作,进一步放大了系统的总体计算能力。这样的设计对于高性能计算、大规模并行处理任务以及AI和机器学习应用尤其关键,能够提供前所未有的处理速度和数据吞吐量。

第二代 Transformer 引擎

第二代Transformer引擎在提高效率和处理能力方面进步显著。得益于微张量缩放技术和NVIDIA的先进算法,这种新技术能够在保持低位宽(如4位浮点数)的同时,显著提升AI模型的推理性能和准确度。集成于NVIDIA TensorRT™-LLM和NeMo Megatron框架中,这些创新不仅增加了算力,还使得模型尺寸在不牺牲性能的前提下得以缩小,进一步推进了AI技术的边界。这对于需要在有限硬件资源下运行大型AI模型的应用来说,尤其重要。未来,在移动设备和边缘计算场景,或许能够大规模使用。

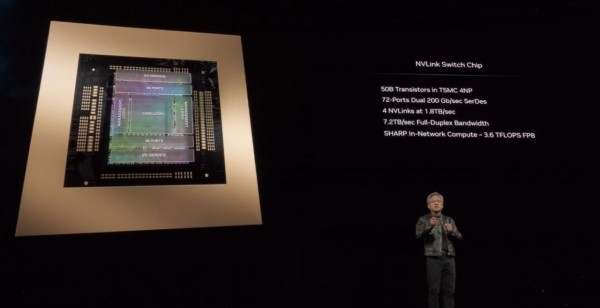

第五代 NVLink

新一代的NVLink®技术显著提高了大规模AI模型的运行效率,尤其是对于万亿级参数模型和混合专家AI模型。

通过为每块GPU提供高达1.8TB/s的双向吞吐量,确保了在多达576块GPU之间的高速且无缝的通信。这种突破性的通信带宽对于处理当前最复杂的大型语言模型(LLM)至关重要,这缘于它允许数据和模型参数以前所未有的速度在GPU之间传输。这不仅显著加快了模型训练和推理的速度,而且还提高了模型处理复杂任务时的能力,满足了当今对高性能计算需求日益增长的挑战。

RAS 引擎

RAS(可靠性、可用性和可维护性)引擎是Blackwell架构GPU的关键创新,为大规模AI部署提供了显著的价值。通过整合专用引擎和芯片级功能,该架构不仅能够运行诊断和预测维护任务,还利用AI技术进行预防性维护,从而显著提升系统的稳定性和连续运行时间。这种先进的自我诊断和问题预测能力,能够大幅减少意外停机时间,确保AI应用的连续性和高效性。对于那些要求极高可靠性和长时间运行的场景,如云计算中心和大型数据分析,RAS引擎提供了一个强大的解决方案。它不仅延长了系统的正常运行时间,还有助于降低运营成本,为企业和研究机构提供了极大的经济效益和操作弹性。

更安全的AI

通过引入先进的机密计算功能和本地接口加密协议,显著提高了数据和AI模型的保护水平,而这一切又不会牺牲性能。这种技术的应用,对于需要处理高度敏感数据的行业(如医疗和金融服务行业)来说,具有极大的价值。它确保了数据在整个处理过程中的安全性和隐私性,即使是在数据使用阶段也能防止未授权访问,满足了对数据保护要求极为严格的领域的需求。此外,支持全新本地接口加密协议进一步加强了数据传输过程中的安全性,为客户提供了更为安全的数据环境。

解压缩引擎

专用解压缩引擎,将显著提升了数据处理能力,特别是在数据分析和数据科学领域。通过支持最新的压缩格式并加速数据库查询,它允许更快的数据访问和处理,这对于处理大规模数据集尤其重要。随着数据量的爆炸性增长,企业对于高效处理和分析数据的需求也随之增加。GPU加速已成为满足这一需求的关键技术。未来,随着更多企业投资于数据处理技术,借助GPU加速的成本效益和性能优势将变得尤为显著。专用解压缩引擎的应用,不仅能够提高企业的数据处理速度,还能在保证效率的同时降低运营成本,这将极大推动数据密集型应用,如机器学习和大数据分析的发展。

颠覆硬件,颠覆软件,更颠覆行业

本次GTC上,NVIDIA除了带来硬件上的突破,更有软件的创新。

NVIDIA 的 NIM 软件包,构建在其强大的加速计算库和前沿的生成式 AI模型之上。

老黄充满自信地表示,客户可以轻松地采用 NIM 的即用型微服务,或者 NVIDIA 也乐于为客户量身打造专属的AI和 AI 助手,以满足特定的业务需求,并培养出独一无二的模型技能,从而开拓宝贵的新服务。

行业层面上,面向IT企业,老黄用“坐在金矿上”的比喻形容企业 IT 领域的现状,强调利用这些年来累积的工具和数据,通过 AI 助手为用户创造更多可能性的巨大潜力。

在电信领域,NVIDIA 6G 研究云的推出,结合了 AI 和 Omniverse 力量的创新平台,旨在推动通信技术的下一代进化。该平台基于 NVIDIA 的 Sionna 神经无线电框架、Aerial CUDA 加速无线电接入网络和 Omniverse Digital Twin for 6G,为未来的通信提供强大的支持。

NVIDIA 在半导体设计和制造领域也有了新动作。与TSMC 和 Synopsys 的合作,将旗下的计算光刻平台 cuLitho 投入生产,预计将使半导体制造中的计算工作负载加速 40-60 倍。

NVIDIA 地球气候数字孪生的推出,能够进行交互式高分辨率模拟的云平台,旨在加速气候和天气预测的进展。

老黄还强调了AI 在医疗领域的巨大潜力。目前,NVIDIA 已经涉足了成像系统、基因测序设备,并与手术机器人的领先公司合作。随着一系列新的生物学软件微服务的发布,将使全球的医疗企业能够利用生成式 AI 的最新成就,提供先进的成像、自然语言和语音识别,以及数字生物学的生成、预测和模拟能力。

在工业领域,NVIDIA 正在通过 API 形式提供 Omniverse Cloud,将这个领先的工业数字孪生和工作流创建平台的能力扩展到整个软件生产生态系统。通过五个全新的 Omniverse Cloud API,开发者现在可以轻松地将 Omniverse 的核心技术集成进自己的数字孪生设计和自动化软件应用中,或者用于测试和验证机器人或自动驾驶汽车等自主机器的仿真工作流。

智能汽车行业是NVIDIA一项重要布局。目前,世界上最大的自动驾驶汽车公司比亚迪选择 NVIDIA 的下一代计算平台为其自动驾驶汽车提供支持。

机器人更是本次GTC的“大招”,英伟达发布了人形机器人通用基础模型Project GROOT,以及基于 NVIDIA Thor 系统级芯片(SoC)的新型人形机器人计算机Jetson Thor。并且,还对NVIDIA Isaac机器人平台进行了重大升级,包括生成式AI基础模型和仿真工具,以及 AI 工作流基础设施。

如此多的行业,如此繁复的创新,英伟达构建起越来越强大的AI生态,正在引领生成式AI的新纪元。

用老黄的话说,当计算机图形学、物理学、人工智能交汇,便衍生出NVIDIA的灵魂。

好文章,需要你的鼓励

CES上杨元庆首谈AGI,碾压人类的叙事不会让AI更聪明

很多人担心被AI取代,陷入无意义感。按照杨元庆的思路,其实无论是模型的打造者,还是模型的使用者,都不该把AI放在人的对立面。

MIT递归语言模型:突破AI上下文限制的新方法

MIT研究团队提出递归语言模型(RLM),通过将长文本存储在外部编程环境中,让AI能够编写代码来探索和分解文本,并递归调用自身处理子任务。该方法成功处理了比传统模型大两个数量级的文本长度,在多项长文本任务上显著优于现有方法,同时保持了相当的成本效率,为AI处理超长文本提供了全新解决方案。

Gmail新增Gemini驱动AI功能,智能优先级和摘要来袭

谷歌宣布对Gmail进行重大升级,全面集成Gemini AI功能,将其转变为"个人主动式收件箱助手"。新功能包括AI收件箱视图,可按优先级自动分组邮件;"帮我快速了解"功能提供邮件活动摘要;扩展"帮我写邮件"工具至所有用户;支持复杂问题查询如"我的航班何时降落"。部分功能免费提供,高级功能需付费订阅。谷歌强调用户数据安全,邮件内容不会用于训练公共AI模型。

华为研究团队突破代码修复瓶颈,8B模型击败32B巨型对手!

华为研究团队推出SWE-Lego框架,通过混合数据集、改进监督学习和测试时扩展三大创新,让8B参数AI模型在代码自动修复任务上击败32B对手。该系统在SWE-bench Verified测试中达到42.2%成功率,加上扩展技术后提升至49.6%,证明了精巧方法设计胜过简单规模扩展的技术理念。

联想集团混合式AI实践获权威肯定,CES期间获评“全球科技引领企业”

CES上杨元庆首谈AGI,碾压人类的叙事不会让AI更聪明

CES 2026 | 重大更新:NVIDIA DGX Spark开启“云边端”模式

Gmail新增Gemini驱动AI功能,智能优先级和摘要来袭

研究发现商业AI模型可完整还原《哈利·波特》原著内容

Razer在2026年CES展会推出全息AI伴侣项目

CES 2026:英伟达新架构亮相,AMD发布新芯片,Razer推出AI奇异产品

通过舞蹈认识LimX Dynamics的人形机器人Oli

谷歌为Gmail搜索引入AI概览功能并推出实验性AI智能收件箱

DuRoBo Krono:搭载AI助手的智能手机尺寸电子阅读器

OpenAI推出ChatGPT Health医疗问答功能

Anthropic寻求3500亿美元估值融资100亿美元