Arm v9芯片新架构及实践应用

ARM 公司是全球重要的芯片 IP 授权厂商,由于 ARM 生态涵盖面广泛,其经营情况也是全球芯片设计业的重要风向标之一。从当季收入体量看,8.24 亿美元的收入是创出历史新高的,且高于此前给出的预期区间(7.2 亿-8 亿美元)。

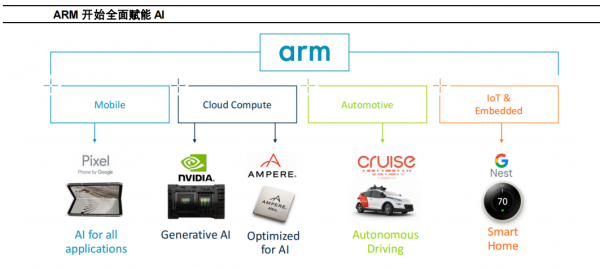

虽然 ARM 早期投入的重点在通用 CPU 赛道,与 AI 算力需求还存在较大差异。但是,随着公司新的 V9 架构的推出,该架构的机器学习能力在数据中心的训练和推理端、边缘端 AI 等领域都有用武之地。数据中心方面,公司与 NVIDIA 的 GraceHopper、微软的 Cobalt、AWS 的 Graviton 系列等芯片,都有着紧密的合作关系。在智能手机、PC 等端侧产品方面,公司推出的 Arm Cortex-X4正在赋能智能手机芯片,使其具备图片生成、实时翻译等功能,在三星Galaxy S24、Vivo iQoo 12 和小米的 14 pro 等产品中都在得到应用。在AI PC 领域,ARM 也开始取得进展,2023 年 10 月 24 日,高通公司基于ARM 架构打造了一款面向 PC 的骁龙 X Elite 处理器芯片,可以运行 130亿参数的大模型,预计搭载该芯片的 PC 产品将在 2024 年年中上线。

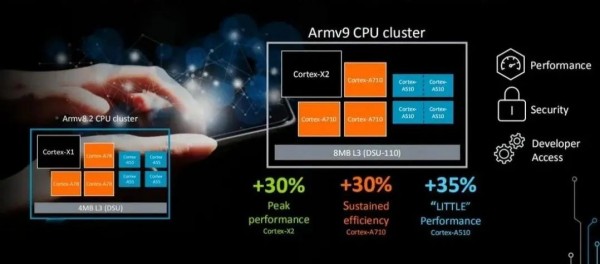

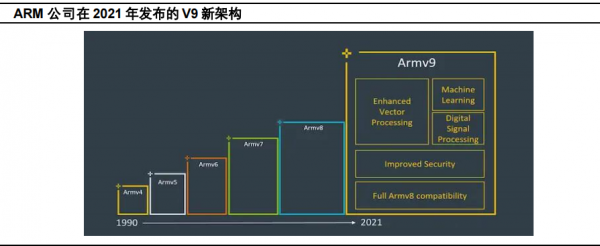

2021年,公司公布了其最新的 ARM V9 架构,除了向前兼容 V8 架构之外,V9架构更加强调 AI、矢量和 DSP 性能改进、安全性等能力。ARM V9 架构主要应用于 A 系列应用处理器、R 系列即时处理器,以及 M 系列微控制处理器。公司最新公告显示,目前市场上主要高端手机,都使用了 V9 架构,尤其是随着人工智能在智能手机端应用的提速,V9 相比于 V8 的优势更为明显,后续应用将提速,此部分的版税收入占比有望提升;数据中心芯片方面,NVIDIA Grace Hopper、AWS Graviton、Microsoft Cobalt 等都应用了 ARM V9 架构。

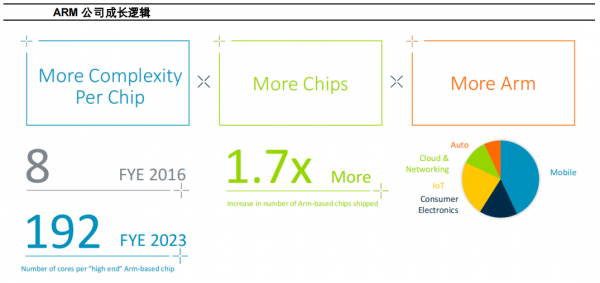

从中长期来看,随着单芯片 ARM 核数增加、基于 ARM 架构芯片数量的上升以及ARM 应用场景的增加,公司仍将保持增长。据公司公告数据显示,2023 财年,高端芯片采用 ARM 的核数已经从 2016 财年的 8 核,上升到了 192 核;同时,公司的芯片应用范围也从早期的移动领域,拓展到云计算及数据网络、汽车等多个领域。

虽然 ARM 早期投入的重点在通用 CPU 领域,与 AI 算力需求存在较大差异。但是伴随着新的 V9 架构的推出,公司在数据中心的训练和推理端、智能手机等边缘设备端,其授权技术满足 AI 需求的机器学习的能力显著增强。

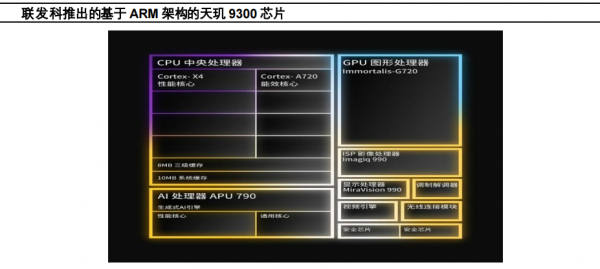

ARM 在智能手机、PC 等领域开始为 AI 赋能。公司推出的Arm Cortex-X4 正在赋能智能手机芯片,可以具备图片生成、实时翻译等功能,在三星 Galaxy S24、Vivo iQoo 12 和小米 14 pro 等产品中都在得到应用。联发科在 2023 年 11 月发布的天玑9300,就是基于ARM 架构打造。天玑9300采用“全大核”CPU 架构,包含4个Cortex-X4超大核,最高频率可达3.25GHz,以及 4 个主频为 2.0GHz 的 Cortex-A720 大核,其峰值性能相较上一代提升 40%,功耗节省 33%。联发科表示,该芯片可以支持终端运行 10 亿、70 亿、130 亿、最高可达 330 亿参数的 AI 大语言模型。

在 AI PC 领域,ARM 也开始取得进展。2023 年 10 月 24 日,高通公司基于ARM 架构打造了一款面向PC 的骁龙 X Elite处理器芯片,可以运行 130 亿参数的大模型。公司预计搭载该芯片的PC 产品将在 2024 年年中上线。高通的加入,将使得ARM 在 PC 生态链的地位更为稳固。

2021 年,公司公布了其最新的 ARM V9 架构,除了向前兼容V8 架构之外,V9 架构更加强调 AI、矢量和 DSP 性能改进、安全性等能力。ARM V9 架构主要应用于 A 系列应用处理器、R 系列即时处理器,以及 M 系列微控制处理器。此前的 V8架构的成功,公司主要依赖智能手机市场对 ARM 芯片的广泛应用。而新的 V9 架构,预计除了在智能手机市场上继续保持强势地位之外,未来在数据中心、智能汽车等领域,都有望培育新的增长点。

公司最新公告显示,目前市场上的几乎所有的高端手机,都使用了 V9架构,尤其是随着人工智能在智能手机端应用的提速,V9相比于V8的优势更为明显,后续应用将提速,此部分的版税收入占比有望提升;数据中心芯片方面,NVIDIA Grace Hopper、AWS Graviton、Microsoft Cobalt 等都应用了 ARM V9 架构。

好文章,需要你的鼓励

CES上杨元庆首谈AGI,碾压人类的叙事不会让AI更聪明

很多人担心被AI取代,陷入无意义感。按照杨元庆的思路,其实无论是模型的打造者,还是模型的使用者,都不该把AI放在人的对立面。

MIT递归语言模型:突破AI上下文限制的新方法

MIT研究团队提出递归语言模型(RLM),通过将长文本存储在外部编程环境中,让AI能够编写代码来探索和分解文本,并递归调用自身处理子任务。该方法成功处理了比传统模型大两个数量级的文本长度,在多项长文本任务上显著优于现有方法,同时保持了相当的成本效率,为AI处理超长文本提供了全新解决方案。

Gmail新增Gemini驱动AI功能,智能优先级和摘要来袭

谷歌宣布对Gmail进行重大升级,全面集成Gemini AI功能,将其转变为"个人主动式收件箱助手"。新功能包括AI收件箱视图,可按优先级自动分组邮件;"帮我快速了解"功能提供邮件活动摘要;扩展"帮我写邮件"工具至所有用户;支持复杂问题查询如"我的航班何时降落"。部分功能免费提供,高级功能需付费订阅。谷歌强调用户数据安全,邮件内容不会用于训练公共AI模型。

华为研究团队突破代码修复瓶颈,8B模型击败32B巨型对手!

华为研究团队推出SWE-Lego框架,通过混合数据集、改进监督学习和测试时扩展三大创新,让8B参数AI模型在代码自动修复任务上击败32B对手。该系统在SWE-bench Verified测试中达到42.2%成功率,加上扩展技术后提升至49.6%,证明了精巧方法设计胜过简单规模扩展的技术理念。