英特尔欲在CPU上运行AI,并表示其第五代至强完全能够胜任

下一代至强将拥有更多核心、更大的缓存和更简单的小芯片架构。

本周四,英特尔在纽约召开的AI Everywhere大会期间,公布了拥有更多核心、更大缓存以及机器学习功能的第五代至强Scalable处理器。

这家x86巨头希望新一代至强芯片能够吸引那些专用AI加速器的客户,并宣称该处理器“毫无疑问将是最佳AI用CPU”。的确,英特尔是少数几家将AI加速设计(即高级矩阵扩展,即AMX指令)纳入数据中心芯片的厂商之一,所以此番宣传似乎所言不虚。

与Sapphire Rapids相比(这里多提一句,Sapphire Rapids经历了一年多的跳票、直到今年1月才正式上市),英特尔表示第五代至强的AI推理速度提升至1.4倍,并可为各类应用提供可接受的延迟表现——当然,仅限于体量较小的机器学习应用。

在深入研究英特尔的CPU加速AI策略之前,我们不妨先来看看这款芯片本身。尽管今年是至强产品家族的正常更新年,但与上一代相比,英特尔确实在幕后做了相当程度的改变,努力提高芯片的性能与效率水平。

更多核心、更大缓存

相较于前代方案,Emerald Rapids确实迎来了一系列显著改进,而其中的典型表现就是更高的核心数量和更大的L3缓存。

这款新芯片将带来最多64核心。对于一款2024年初才推出的芯片来说,这样的数字倒也称不上惊艳。毕竟AMD在2019年推出的Epyc 2就达到了这个水平,而且大多数芯片制造商、包括几家云服务商,目前都在部署72核、96核甚至是128核及以上的芯片。

好消息是,与今年1月上市的Sapphire Rapids不同,这次核心数量最多的型号并非单纯面向大型四路或八路平台。也就是说,英特尔主流至强处理器的核心数量上限终于从之前的56个全面提升至96个。但坏消息是,如果大家需要一台大型多插槽服务器,那暂时仍然只能选择Sapphire Rapids。因为至少在明年之内,英特尔的第五代至强最多只能支持双插槽平台。

肯定有朋友觉得英特尔会使用更多小芯片来增加核心数量,类似于去年AMD将其Epyc 4提升至96核的方式。但事实并非如此。

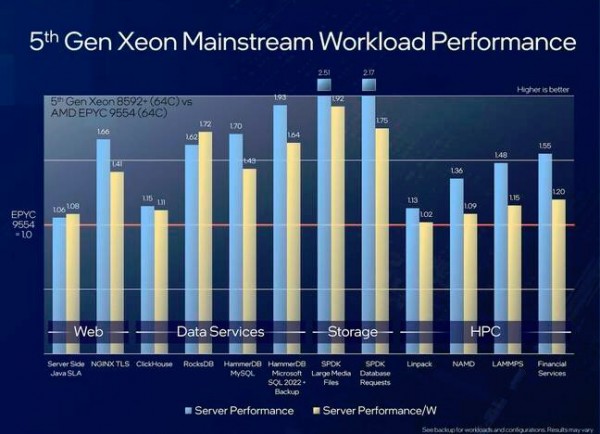

虽然仍须持保留态度,但至少在单一核心的比较中,英特尔宣称其Emerald Rapids至强的性能最高可达AMD Epyc处理器的2.5倍。

总而言之,英特尔宣称其64核心版本的第五代至强在各种基准测试中,均比同核心数量的AMD Epyc 4 9554处理器更具竞争优势。当然,与往常一样,请对这些说法持保留态度。虽然基准测试确实指出英特尔的单一核心较AMD更加强大,但这里没有考虑到AMD Epyc 4平台拥有50%到100%的核心数量优势。因此,虽然英特尔的单核性能也许更强,但AMD仍可将更多核心塞进相同的双插槽服务器。

CPU对AI推理有意义吗?英特尔认为答案是肯定的

由于市场对于AI加速器的需求远超供应能力,所以英特尔正推动其Emerald Rapids至强作为理想的推理平台,并对芯片进行了多项显著改进,旨在增强其AMX加速功能。

具体来讲,英特尔调整了AVX-512与AMX模块的睿频频率,旨在有关法律由激活这些指令带来的性能损失。该公司声称,除了架构改进之外,某些工作负载的推理性能也比前代至强提高了42%。

然而,随着GPT-4、Meta Llama 2和Stable Diffusion等大语言模型风靡一时,英特尔也开始讨论在其CPU上运行小体量模型的能力。对于此类工作负载,决定性能的主要因素落在了内存带宽和延迟之上。于是,新一代至强的4500 MT/秒DDR5无疑将有所帮助,但仍无法完全取代HBM。尽管英特尔实际上也开发过带有HBM的CPU,但在Aurora和Crossroads超级计算机中使用的至强Max系列处理器在这一代并没有新品问世。

根据英特尔的介绍,参数规模不超过200亿参数的大语言模型完全可以在第五代至强上良好运行。

即使如此,英特尔表示在使用双插槽至强平台的GPT-J模型当中,下一token的响应延迟(即响应提示词而生成单词或短语的速度)已经可以控制在约25毫秒左右。

但从图表中可以看到,随着参数规模的增加,延迟也将同步提升。不过英特尔表示,在运行Llama 2 13B模型时,第五代至强已经能够将延迟控制在最低62毫秒,完全满足芯片厂商们普遍设定的100毫秒标准。

据我们了解的情况,英特尔已经能在最高200亿参数的模型上实现可接受的延迟。除此之外,芯片巨头还通过分布式模型展示了可接受的下一token响应延迟,例如跨四个双路节点的Meta 700亿参数Llama 2模型。

尽管仍有局限,但英特尔坚称其客户已经在尝试通过CPU运行大模型推理。当然,对此我们并不怀疑。以可接受的性能水平运行大语言模型或者其他机器学习工作负载,确实有望显著降低成本,回避当前已经极为夸张的GPU设备售价。

然而,对于那些希望运行更大模型(例如拥有1750亿参数的GPT-3)的用户来说,像英特尔自家Habana Gaud2这样的专用AI加速器似乎短时间内仍不会到来。

说起这个,英特尔提到Gaudi 3将于2024年发布,并与英伟达的H100和AMD的MI300X正面竞争。不过,芯片巨头并没有具体透露该芯片的细节信息。

好戏还在后头

虽然英特尔的Emerald Rapids至强确实改进不小,但这款芯片的风头却仍被英特尔的下一代数据中心处理器抢走了大半。

过去几个月间,英特尔一直在宣传其性能与能效核至强处理器,代号分别为Granite Rapids和Sierra Forest。这些芯片有望带来更夸张的核心数量,支持更大、更快的内存,并将成为首批采用英特尔推迟已久的真7纳米(即Intel 3)制程工艺的产品。

其中Sierra Forest将于明年上半年推出,号称能在单插槽系统中提供最多288个能效核心——即每计算块144个核心。

另一方面,Granite Rapids则计划在2024年晚些时候推出。根据我们从今年夏季英特尔Innovation大会上得到的消息,该处理器将采用新的模块化小芯片设计,最多可包含三个计算块、且两面各设有一个I/O芯片。

英特尔尚未透露Granite Rapids将提供多少核心,但在今年夏季的Hot Chips大会上,芯片巨头称将提供136条PCIe通道和12条内存通道,并支持8800 MT/秒MCR DIMM。如此一来,芯片的内存带宽将提升至约845 GB/秒,这无疑对大语言模型推理性能增益巨大。

当然,其他厂商也绝不可能坐视英特尔的新一代产品横扫市场。AMD公司预计将在明年年内推出代号为Turin的第五代Epyc处理器。与此同时,各大主要云服务商也先后公布了自家基于Arm架构的新款CPU。

好文章,需要你的鼓励

Cyera获得4亿美元融资专攻AI数据安全,估值达90亿美元

人工智能和数据安全公司Cyera宣布完成4亿美元后期融资,估值达90亿美元。此轮F轮融资由贝莱德领投,距离上次融资仅6个月。随着95%的美国企业使用生成式AI,AI应用快速普及带来新的安全挑战。Cyera将数据安全态势管理、数据丢失防护和身份管理整合为单一平台,今年推出AI Guardian扩展AI安全功能。

上海AI实验室研究者想出妙招:让AI像优秀学生一样高效思考,告别“想太多“毛病

上海AI实验室开发RePro训练方法,通过将AI推理过程类比为优化问题,教会AI避免过度思考。该方法通过评估推理步骤的进步幅度和稳定性,显著提升了模型在数学、科学和编程任务上的表现,准确率提升5-6个百分点,同时大幅减少无效推理,为高效AI系统发展提供新思路。

SAP推出全新AI功能助力零售业数字化转型

SAP在2026年全国零售联盟大展上发布了一系列新的人工智能功能,将规划、运营、履约和商务更紧密地集成到其零售软件组合中。这些更新旨在帮助零售商管理日益复杂的运营,应对客户参与向AI驱动发现和自动化决策的转变。新功能涵盖数据分析、商品销售、促销、客户参与和订单管理等领域,大部分功能计划在2026年上半年推出。

MIT团队让机器人终于不再“卡顿“:一种让机器人像人一样流畅反应的突破性技术

MIT团队开发的VLASH技术首次解决了机器人动作断续、反应迟缓的根本问题。通过"未来状态感知"让机器人边执行边思考,实现了最高2.03倍的速度提升和17.4倍的反应延迟改善,成功展示了机器人打乒乓球等高难度任务,为机器人在动态环境中的应用开辟了新可能性。

SAP推出全新AI功能助力零售业数字化转型

Gmail推出个性化AI收件箱与智能搜索等多项新功能

CISA警告HPE OneView和微软Office漏洞正被活跃利用

谷歌削减Android开源代码发布频率至每年两次

高通CES 2026:扩展IE-IoT产品组合推进边缘AI发展

恩智浦发布S32N7处理器系列,加速AI驱动汽车发展

n8n自动化平台严重漏洞可让攻击者完全控制服务器

微软将在Copilot中直接集成购买按钮功能

Snowflake收购Observe拓展AI驱动监控能力

丰田升级SUV产品线,RAV4新增信息娱乐系统

可信开源软件现状报告:AI重塑技术栈基线

思科修复ISE安全漏洞,公开概念验证代码已发布