突破传统算力困局,Ampere换种方式迎接AI算力挑战 原创

伴随着AI技术的飞速发展,尤其大模型的出现,数据中心对AI算力需求急剧提高。而AI算力需求的激增的同时,带来的是服务器供电需求的飞速增长,以及为其提供制冷的冷却系统能耗激增。

如何以高效节能的方式,满足AI算力高速增长的AI算力需求?在ODCC举办的2023开放数据中心大会上,经过与Ampere的一番沟通交流,让我们了解到一种突破传统AI算力困局的全新解决方案。

Ampere Computing产品技术总监孙开本在开放数据中心大会发表演讲

传统数据中心的困局

传统数据中心正面临着一个常见的问题:受到供电的限制,每个机柜中只能上架有限的几台AI服务器,无法实现满柜。目前标准的数据中心,每台机柜内通常部署8-9台2U的服务器。然而,这些服务器的电力预算已经不足,导致剩下的空间无法再放置更多的服务器。这就意味着,数据中心服务器的部署密度只有50%到60%。因此,许多云服务提供商面临了部署密度不高、空间浪费等问题。

AI服务器的部署密度则更低。例如,目前市面上常见的某款GPU卡的功耗为75瓦,一台服务器加四张卡就是300瓦,而一台标准的通用服务器的功耗至少也要700~900瓦。因此,对于一个电力容量为8,000瓦的机柜,原本可以放10台通用服务器,换成AI服务器可能就只能放5~6台了;如果是高算力的AI服务器,甚至只能放1~2台。针对上述挑战,Ampere云原生处理器正是理想的选择。

Ampere公司推出的云原生处理器具备先天的低功耗优势,可以帮助实现机柜电力与空间的更优配比,提高部署密度。对于AI服务器,Ampere平台的功耗降低了,同时提供与其它平台相同的性能。这意味着在同样的电力预算下,使用Ampere平台可以放置更多的AI服务器,从而提高数据中心的部署密度。

Ampere的AI算力破局

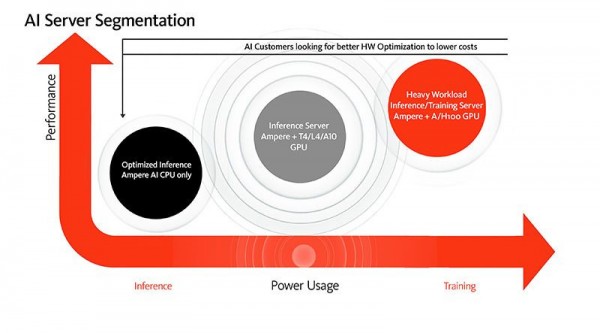

目前,AI领域,服务器通常采用x86架构CPU并配备GPU来满足高计算需求。然而,随着AI应用的不断发展,行业也开始寻找更高效的解决方案来降低能耗和成本。

AI有两大方面,分别是AI训练和AI推理。目前,GPU被广泛认为是AI训练最合适的方案。

而在AI推理方面,目前也出现了为 AI 推理超额配置计算的情况,这可能导致高昂的成本支出(无论是硬件的单位成本,还是硬件运行的电力成本)。因此,目前行业也会考虑一些能够大幅降低能耗的其他方案。

Ampere表示,在AI训练的场景下,Ampere的云原生处理器与x86架构的作用没有区别。这意味着,在搭载最常用的GPU进行训练时,Ampere的CPU与其他GPU一样表现出良好的兼容性和性能。此外,Ampere表示已经确保了其平台与大多数GPU的兼容性, 目前大多数常用的GPU在Ampere平台上都得到了支持。在大会的参观交流中,Ampere说道:“在训练层面,我们和x86 提供的性能是一样的,唯一的区别就是能耗,用我们英文的口号就是Less Power Is the New Power (中文:低能耗,“芯”未来)。因为大家用的都是同样的GPU,提供的性能一样,区别主要来自CPU。 Ampere云原生处理器比传统x86更节能”

更加适用于AI推理的Ampere

随着AI的快速发展,大模型的应用越来越普遍。由于巨大的参数量和大量的数据处理量,大模型需要的计算资源更多,对硬件的性能要求更高,同时还需要考虑如何降低能耗、提高计算效率等问题。另外,大模型的训练和推理也需要更加复杂和高效的网络架构和算法,这也对硬件提出了更高的要求。

对于Ampere来说,AI推理是机遇所在。在AI推理上有个“batch size”的概念,就是批量的大小。把小的工作积赞到一起,一次性给GPU处理,这是“大批量”的AI推理,通常GPU更合适。而在“小批量”的场景下,需对任务进行及时响应,通常延时要求比较高,但对吞吐量要求不高,CPU则更合适这种场景。

随着AI热潮来袭,Ampere的云原生处理器解决方案也受到许多关注。从 2020 年开始,Ampere早就已经在AI领域开始布局,收购了一家专注于AI推理优化的公司OnSpecta,在模型算子、底层的指令方面进行优化。Ampere表示:“基于这种软硬件协同优化,我们现在的AI推理基本上翻了5倍。早在两年多前,Ampere就组建了专门的AI团队,开展针对AI的一系列创新。”

目前,Ampere已经有许多客户都在基于Ampere Altra系列处理器进行AI推理。针对AI的常用主流框架,比如TensorFlow、PyTorch和ONNX,Ampere进行了优化,性能得到了显著提升。

此外,Ampere的产品不只适用于当前常见的大型语言模型,也适用于过去几年相对旧的模型。通过Ampere云原生处理器进行AI推理,可获得卓越的可扩展性和性能,也打破了效率的瓶颈,而这正是令云服务提供商(CSPs)困扰的问题,因为使用GPU会带来极高的能耗,而且容量扩展会受到制约,可部署的服务器数量也会受到限制。而Ampere的云原生处理器通过提供卓越的性能和能效,恰好能够解决这些行业痛点,尤其是对于AI推理。

更适于私域大模型的Ampere

随着ChatGPT等大模型的普及,企业出于对安全、隐私信息的重视,对于私域大模型的私有化部署将越来越多。然而,在部署过程中,企业必须在算力基础设施方面进行合理的选择。

在并发性方面,企业内部使用的大模型需要同时处理的人数可能不如公开服务,没有大量的并发处理;在延迟方面,企业内部使用的大模型对延迟要求没有公开服务那么高,带宽也没有那么挤兑,但对电力、数据中心资源节省很敏感。

用CPU做AI推理可以获得诸多独特的优势。第一,CPU适用于批量比较小的现代应用类;第二,CPU软件的灵活度更高,在软件设计上更容易,因为不需要硬件,不需要第三方提供的库,也很少有依赖性,独立性更强;第三,使用CPU摆脱了OS驱动,因为不涉及GPU的一系列配套,复杂性也相应降低。因此,Ampere认为:“企业不必拘泥于常规惯性思维,一上来就是用GPU,应该量体裁衣,配备适度的算力,以达到更好的性能和成本效益。”

相比传统 x86 处理器成本高、能耗大,最新的 Ampere 云原生处理器能够助力打造高能效、高性能的 AI 推理应用,是替代x86的理想方案,同时也是用于 AI 训练和大语言模型(LLM)推理 GPU 的高性价比之选。相比传统的 x86 处理器,Ampere Altra 系列云原生处理器在 AI 推理方面拥有显著的性能优势:针对计算机视觉工作负载,性能最高可提升 4 倍;针对常见的 NLP 工作负载,每瓦性能最高可提升 3 倍。

注重效率,更关注可持续发展

在数据中心,可持续发展是大家长期关注的焦点之一。在今年的开放数据中心大会上,许多厂商也围绕低碳、可持续、节能、土地资源、运营成本等问题进行了热烈的探讨。

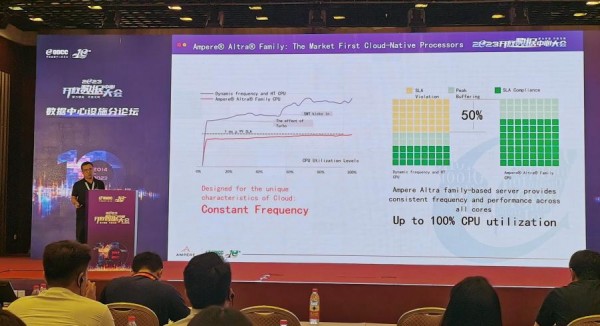

在数据中心有一个“安全水位”的概念,它通常在30%的水平,再有大约20%的预留。简单来说,这意味着如果有一个100个核的数据中心,为了保证数据中心的稳定性和性能,一般只有50个核会真正投入运行。但是,这也意味着有50%的CPU资源被闲置,闲置的背后也涉及到土地空间、运营效率等问题。

Ampere的云原生处理器却可以在保证性能的同时,将这个“安全水位”提高至70%,同时留下30%的缓存,从而提高利用率。Ampere举了个例子:“比如一台机架部署了100个核,如果是普通的x86 CPU,只能用50个。而如果部署的是Ampere云原生处理器,可以用100核。因此,机架部署就可以更满,这就是我提到的资源利用率,这里的‘资源’包括机架和CPU既有的算力资源。” 也就是说,在同体积空间里,基于Ampere处理器的机架不但密度更高,算力也更强。

在助力构建可持续云计算方面,Ampere云原生处理器基于不同的架构,兼具高性能与低能耗的综合优势,打破了传统架构的限制,能够助力数据中心实现效率提升三倍、整体占地面积减少 3 倍、单机架性能提升 2.5 倍、能耗降低 2.8 倍的优化效果。

Ampere通过其云原生处理器技术不断兑现其对性能和可持续性的承诺,向用户提供环境友好的高性能系列微处理器,以可持续的方式突破能耗的限制。面对新的计算趋势和可持续发展趋势,让我们且看Ampere如何引领创新,突破性能与能耗的束缚,推动行业迎接变革,迈向计算的新象限。

好文章,需要你的鼓励

Adobe与UCLA联手突破AI模型速度瓶颈:让图像生成快一倍的“稀疏化魔法“

Adobe研究院与UCLA合作开发的Sparse-LaViDa技术通过创新的"稀疏表示"方法,成功将AI图像生成速度提升一倍。该技术巧妙地让AI只处理必要的图像区域,使用特殊"寄存器令牌"管理其余部分,在文本到图像生成、图像编辑和数学推理等任务中实现显著加速,同时完全保持了输出质量。

Google发布Gemini 3 Flash并将其设为默认模型

谷歌发布基于Gemini 3的快速低成本模型Flash,并将其设为Gemini应用和AI搜索的默认模型。新模型在多项基准测试中表现优异,在MMMU-Pro多模态推理测试中得分81.2%超越所有竞品。该模型已向全球用户开放,并通过Vertex AI和API向企业及开发者提供服务。定价为每百万输入token 0.5美元,输出token 3美元,速度比2.5 Pro快三倍且更节省token用量。

不用再训练AI模型,香港科技大学团队发明“智能管家“,让AI一眼就知道该抓哪里用哪里

香港科技大学团队开发出A4-Agent智能系统,无需训练即可让AI理解物品的可操作性。该系统通过"想象-思考-定位"三步法模仿人类认知过程,在多个测试中超越了需要专门训练的传统方法。这项技术为智能机器人发展提供了新思路,使其能够像人类一样举一反三地处理未见过的新物品和任务。

英特尔酷睿Ultra第三代,如何推动AI PC规模化落地?

Google发布Gemini 3 Flash并将其设为默认模型

# 思科自研AI模型正式应用于产品,首先赋能身份安全服务

超大规模云厂商在2025年是解决了电力问题还是重新思考了问题?

# 英伟达成为唯一能免费提供AI模型的厂商

Retell AI推出自动化质检系统,解决语音智能体人工审核瓶颈

# 法国生物科技公司发布全球首个生物学通用AI模型

# JEDEC开发减少引脚数的HBM4标准以提升容量

# Ewigbyte光学归档存储技术及战略解析

2025年:可穿戴设备全面转向AI技术

# Oracle领衔科技巨头5000亿美元AI数据中心租赁狂潮

新农人:西云数据如何绘制智慧农牧“全景图”