全球领先系统制造商推出 NVIDIA AI 就绪型服务器,为企业大幅提升生成式 AI 性能

2023 年 8 月 22 日 — NVIDIA 今日宣布,全球领先的系统制造商将推出 AI 就绪型服务器,其支持同于今日发布的 VMware Private AI Foundation with NVIDIA,帮助企业使用自有业务数据来定制和部署生成式 AI 应用。

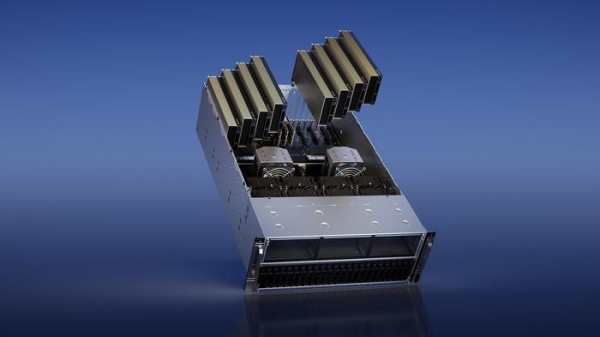

NVIDIA AI 就绪型服务器将采用 NVIDIA® L40S GPU、NVIDIA BlueField®-3 DPU 和 NVIDIA AI Enterprise 软件使企业能够微调生成式 AI 基础模型并部署生成式 AI 应用,比如智能聊天机器人、搜索和摘要工具等。这些服务器还提供由 NVIDIA 加速的基础设施和软件,以支持 VMware Private AI Foundation with NVIDIA。

作为全球领先的系统制造商的戴尔科技、慧与和联想,将于年底前推出搭载 NVIDIA L40S 的服务器,以加速推进企业级 AI 的发展。

NVIDIA 创始人兼首席执行官黄仁勋表示:“全新的计算时代已经来临,各行各业的企业都在竞相采用生成式 AI。我们正在通过涵盖全球顶尖软件和系统合作伙伴的生态系统,将生成式 AI 带给全球企业。”

对于将部署 VMware Private AI Foundation with NVIDIA 的企业来说,NVIDIA AI 就绪型服务器是一个理想的平台。

VMware 首席执行官 Raghu Raghuram 表示:"生成式 AI 正在大力推动数字化转型进程,企业需要一种全面集成的解决方案,以更加安全地构建应用,从而推动业务发展。通过 VMware、NVIDIA、以及我们服务器制造商合作伙伴的专业知识相结合,企业将能够在确保数据隐私、安全和可控性的前提下开发和部署 AI。

助推企业生成式 AI 转型

各行各业正在竞相将生成式 AI 用于药物研发、零售产品描述、智能虚拟助手、制造模拟、欺诈检测等各种用途,NVIDIA AI 就绪型服务器将为这些行业提供全栈加速基础设施和软件。

这些服务器采用 NVIDIA AI Enterprise,即 NVIDIA AI 平台的操作系统。该软件为 100 多个框架、预训练模型、工具套件和软件提供生产就绪型企业级支持和安全性,包括用于 LLM 的 NVIDIA NeMo™、用于模拟的 NVIDIA Modulus、用于数据科学的 NVIDIA RAPIDS™ 和用于生产型 AI 的 NVIDIA Triton™ 推理服务器。

专为处理包含数十亿参数的复杂 AI 工作负载而打造的 L40S GPU 搭载第四代 Tensor Core 和 FP8 Transformer 引擎,可提供超 1.45 PFLOPS 的张量处理能力,其训练性能是 NVIDIA A100 Tensor Core GPU 的 1.7 倍。

相较于 NVIDIA A100 GPU,NVIDIA L40S 可将智能聊天机器人、助手、搜索和摘要等生成式 AI 应用中的生成式 AI 推理性能提高 1.2 倍。

通过集成 NVIDIA BlueField DPU,可加速、卸载和隔离巨大计算工作负载,其中包含虚拟化、网络、存储、安全,以及其他云原生 AI 服务,以进一步提高速度。

NVIDIA ConnectX®-7 智能网卡提供先进的硬件卸载和超低延迟,可为数据密集型生成式 AI 工作负载提供同类领先的可扩展性能。

推动企业生成式 AI 部署的庞大生态系统

全球领先的计算机制造商正在构建 NVIDIA AI 就绪型服务器,包括戴尔 PowerEdge R760xa、适用于 VMware Private AI Foundation with NVIDIA 的慧与 ProLiant Gen11 服务器以及联想 ThinkSystem SR675 V3。

戴尔科技主席兼首席执行官 Michael Dell 表示:“生成式 AI 是创新的‘催化剂’,将助力解决一些全球性的重大挑战。而采用 NVIDIA AI 就绪型服务器的戴尔生成式 AI 解决方案将扮演至关重要的角色,即通过推动生产力水平实现前所未有的提升,并变革工业运营的方式,以加速人类的进程。”

慧与总裁兼首席执行官 Antonio Neri 表示:“生成式 AI 将推动企业生产力规模的全新扩展 —— 从赋能聊天机器人和数字助理,到帮助设计和开发新的解决方案。我们很高兴能继续与 NVIDIA 密切合作,在一系列企业级调优和推理工作负载解决方案中采用 NVIDIA 的 GPU 和软件,这将加速生成式 AI 的部署。”

联想集团主席兼首席执行官杨元庆表示:“企业迫切希望采用生成式 AI 来推动智能化转型。通过与 NVIDIA 和 VMware 合作,联想正在进一步扩大自身在生成式 AI 领域的领先地位,并巩固自身的独特定位,即在客户采用 AI 的旅程中为其提供帮助。”

供应情况

搭载 L40S GPU 和 BlueField DPU 的 NVIDIA AI 就绪型服务器将于年底前上市,云服务提供商预计将在未来几个月提供实例。

来源:至顶网计算频道

好文章,需要你的鼓励

奥运级别的努力:首席信息官为2026年AI颠覆做准备

AI颠覆预计将在2026年持续,推动企业适应不断演进的技术并扩大规模。国际奥委会、Moderna和Sportradar的领导者在纽约路透社峰会上分享了他们的AI策略。讨论焦点包括自建AI与购买第三方资源的选择,AI在内部流程优化和外部产品开发中的应用,以及小型模型在日常应用中的潜力。专家建议,企业应将AI建设融入企业文化,以创新而非成本节约为驱动力。

字节跳动发布GAR:让AI能像人类一样精准理解图像任何区域的突破性技术

字节跳动等机构联合发布GAR技术,让AI能同时理解图像的全局和局部信息,实现对多个区域间复杂关系的准确分析。该技术通过RoI对齐特征重放方法,在保持全局视野的同时提取精确细节,在多项测试中表现出色,甚至在某些指标上超越了体积更大的模型,为AI视觉理解能力带来重要突破。

Spotify推出AI播放列表功能让用户掌控推荐算法

Spotify在新西兰测试推出AI提示播放列表功能,用户可通过文字描述需求让AI根据指令和听歌历史生成个性化播放列表。该功能允许用户设置定期刷新,相当于创建可控制算法的每周发现播放列表。这是Spotify赋予用户更多控制权努力的一部分,此前其AI DJ功能也增加了语音提示选项,反映了各平台让用户更好控制算法推荐的趋势。

Inclusion AI推出万亿参数思维模型Ring-1T:首个开源的超大规模推理引擎如何重塑AI思考边界

Inclusion AI团队推出首个开源万亿参数思维模型Ring-1T,通过IcePop、C3PO++和ASystem三项核心技术突破,解决了超大规模强化学习训练的稳定性和效率难题。该模型在AIME-2025获得93.4分,IMO-2025达到银牌水平,CodeForces获得2088分,展现出卓越的数学推理和编程能力,为AI推理能力发展树立了新的里程碑。

为全天候绿电而生,海辰储能发布全球首个原生8小时长时储能解决方案

为AI+而生,海辰储能发布全球首款锂钠协同AIDC全时长储能解决方案

长时储能开启智慧未来:海辰储能生态日全球首发三大新品

Arm 借助融合型 AI 数据中心,重塑计算格局

奥运级别的努力:首席信息官为2026年AI颠覆做准备

Spotify推出AI播放列表功能让用户掌控推荐算法

Adobe押注生成式AI获得回报,年度营收创历史新高

OpenAI与迪士尼达成十亿美元合作协议,米老鼠和漫威角色进入Sora

甲骨文150亿美元数据中心投资导致股价下跌

Spoor鸟类监测AI软件需求飞速增长

制药行业AI数据质量危机:垃圾进垃圾出的隐患

Harness获得2.4亿美元融资,估值达55亿美元,专注自动化AI编码后的开发流程