英伟达升级GRACE-HOPPER GPU内存,着力为大语言模型提供加持

如果情况真如英伟达及其他众多科技企业预料的那样,即大语言模型会成为新的编程模型基础,那么混合CPU-GPU计算引擎就将是新的通用计算平台。

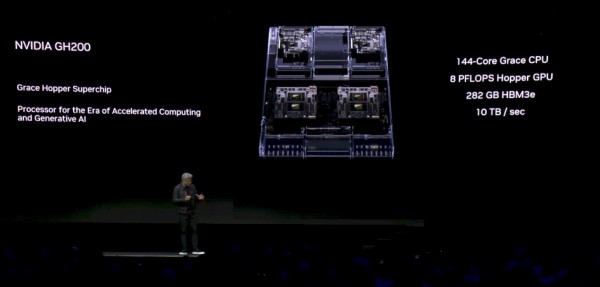

多年以来,英伟达一直为其他厂商提供高端SXM流多处理器模块或PCI-Express卡,用以构建此类混合设备。而如今凭借着最新的GH200超级芯片,也就是把基于Arm架构的“Grace”CPU同基于第六代GPU计算引擎的“Hopper”GPU相结合,英伟达正在AI基础设施领域迎头赶上,努力打造出适合运行超大规模AI推理与训练工作负载的整体系统。

尽管英伟达从今年5月起就一直在批量销售其Grace-Hopper超级芯片,同时完成了对仅可接入Hopper GPU板的HGX形制服务器和可混合接入Grace及/或Hopper芯片的MGX形制服务器的标准化。但目前最炙手可热的行业新贵,则是英伟达最近在Siggraph 2023会议上刚刚宣布的第二代GH200超级芯片。

在第二代GH200超级芯片上,所使用的Grace CPU及Hopper GPU与上一代完全相同。其中Grace芯片基于Arm公司的“Demeter”Neroverse Arm V2核心。三年前英伟达曾试图以400亿美元收购Arm,如今后者刚刚再次申请上市。初代Hopper SXM5 GPU计算引擎配备80 GB HBM3内存和3.35 TB/秒的内存带宽。去年Hopper GPU刚刚推出时,这款SXM5设备共搭载6个HBM3内存栈,但基点只有5个处于活动状态(我们怀疑是出于良品率的考虑),所以实际容量仅为80 GB——而非大家预期的96 GB。PCI-Express版本的Hopper拥有8个HBM3内存栈,其中同样只有5个能够工作,且内存带宽也仅为2 TB/秒(可能是为了降低耗电和发热量而在刻意控制时钟速率)。

而在Grace-Hopper SXM5超级芯片(正式名称为GH200)刚发布时,英伟达终于成功启用了全部6个内存栈,让Hopper GPU获得了96 GB内存和4 TB/秒的内存带宽。到了第二代GH200超级芯片这边,英伟达开始将这款计算复合体中的Hopper部分升级为HBM3e内存,此举令容量提高至141 GB,带宽则提高至5 TB/秒。与去年发布的初代Hooper SXM5设备相比,新版本的内存容量增加了76.3%,内存带宽也上升了49.3%。

英伟达超大规模与高性能计算(HPC)总经理Ian Buck在采访中表示,此番内存升级就是把HBM3换成了HBM3e。Hopper GPU在设计之初就考虑到对速度更快、容量密度更高的HBM3e内存的支持需求,因此可以交叉兼容并对接这些内存技术。我们初步判断此番容量和带宽提升并非源自HBM技术栈中内存芯片数量的增加,毕竟除非对Hopper SXM5封装进行重新设计,否则内存栈数量应该无法超过6个。

Buck并未提及第二代GH200超级芯片中的HBM3e内存来自哪家供应商,但三星、SK海力士和美光科技都在开发HBM3e内存。所以理论上讲,其中任何一家都可以为改进后的超级芯片负责内存供应,毕竟二代GH200今年年底才开始提供样品、明年第二季度正式出货,准备时间还算充裕。而且Buck证实英伟达拥有多家HBM内存供应商。考虑到这种材料的制造成本和制造难度都比常规DRAM要高,所以英伟达的“狡兔三窟”策略非常明智。据我们了解,为了提高制造供应,所有三家供应商都在为英伟达的GPU引擎提供HBM3e内存。

当我们问到常规Hopper SXM5和Hopper PCI-Expres卡何时迎来HBM3e升级时,Buck对这个问题保持沉默。此外,当我们提到 Grace CPU中的LPDDR5内存在升级后也能增加内存容量和传输带宽时,Buck同样表现出职业精神、不对尚未发布产品说得太多。

英伟达尚未公布任何关于Hopper或Grace-Hopper计算引擎的定价,也未提到是否会按原本定价交付这波内存容量和内存性能都有提升的二代产品(我们严重怀疑这不太可能)。但Buck明确表示,英伟达预计之前在采购Grace-Hopper超级芯片的系统制造商将“很快”转向第二代产品。

对于长期受到内存容量和内存带宽限制的HPC和AI应用程序,HBM3e内存的加入将极大提升这类用例的性能水平。

Buck在谈到下一代GH200时称,“我预计以往受到带宽限制的应用将实现近1.5倍的性能提升。当然,也不是在所有场景下都能达到这样的增幅,但大致也是在这个区间。另外内存容量也有增加,意味着大家可以在单一GPU上运行体量更大的模型。而且现在通过CPU-GPU的组合,大家实际拥有近700 GB的组合内存,就是说单一GPU能处理的负载更多了。对于那些用不着两个GPU共同运行的模型,其性能肯定会节节攀升。”

这是Siggraph会议带来的第一份公告。第二条新闻,则是英伟达推出了一款双插槽Grace-Hopper超级芯片,该芯片搭载900 GB/秒的直连NVlink端口,可相互对接以形成内存共享复合体,共包含2个Grace CPU和2个Hopper GPU。这实际上就形成了机器间的四路链接,跟传统上的四路CPU系统基本相同,其中每台设备都能与复合体中任意其他设备的内存进行通信。如果愿意,大家也可以称其为“非对称NUMA”。

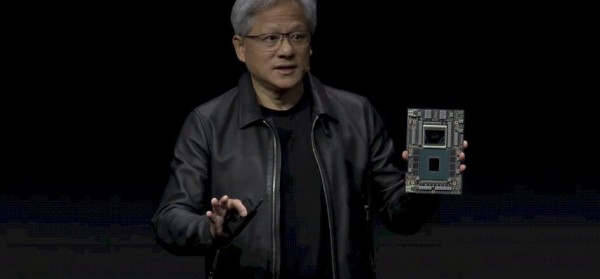

英伟达公司联合创始人兼CEO黄仁勋在Siggraph大会的主题演讲中解释道,“它基本上是把一块巨大的GPU和一块巨大的CPU,转化成一块巨大的超级芯片。其中的CPU现在拥有144个核心,GPU拥有10 TB/秒的帧缓冲带宽和282 GB的HBM3e内存。很明显,大家几乎能把自己选择的任何大语言模型直接塞进去,而它则疯狂执行推理运算。大语言模型的推理成本将因此显著降低,要知道这可是台非常小巧的计算设备。您可以将其扩展至世界各地的数据中心,可以将其接入以太网,也可以将其与InfiniBand相对接。”

降低推理成本这一点非常关键,因为当我们必须在执行训练的相同机器上进行推理时,那么除非能把训练成本也降低到跟推理持平的状态,否则开销将太过高昂。当然,与采用Hopper SXM5单元、各单元通过NVSwitch结构互连的八路GPU复合体DGX H100服务器相比,英伟达这套Grace-Hopper方案具体能省多少钱仍有待观察。

成本节约效果,实际上取决于Grace CPU能比英特尔或AMD的x86处理器便宜多少。我们觉得后者虽然价格更高,但也能支撑起更大的CPU内存空间和闪存存储容量,类似于DGX H100服务器及其HGX版本。再联想到可以用NVSwitch互连结构将最多256个GPU构建成MGX Grace-Hopper集群,并采用InfiniBand将多个Pod交叉耦合成一个超级Pod。这样一个拥有256 GPU的Grace-Hopper超级Pod,应该就有能力跟采用英特尔“Sapphire Rapids”至强SP CPU、配备同样256个Hopper GPU并依靠NVSwitch实现节点间互连的Hopper DGX H100超级Pod正面抗衡了,最终究竟谁更胜一筹着实令人期待。不过考虑到第二代Grace-Hopper GH200拥有高于GH100 SXM5的内存容量和内存带宽,结果大概率会是“一代新人胜旧人”。

但如果GH100 SXM5也升级为141 GB容量加5 TB/秒的HBM3e技术栈,那胜负恐怕还未可知,具体要取决于AI训练/推理工作负载的性能、及其对内存/网络层次结构的适配效果。

好文章,需要你的鼓励

至顶AI实验室硬核评测:联想推理加速引擎让AI PC解题快如闪电

联想此次推出的推理加速引擎(Inference Acceleration Engine),是联想携手清华大学无问芯穹团队联合打造的本地AI加速解决方案。这款引擎将预装在联想年底发布的新一代AI PC产品线中,目标是让端侧推理性能直接看齐云端大模型水平。

香港中大联合牛津等名校:AI视频已能完美骗过人工智能检测,连顶级模型都认不出真假

香港中文大学等顶尖院校联合研究发现,当前最先进的AI视频生成技术已能制作出连顶级检测系统都无法识别的假视频。研究团队开发了Video Reality Test平台,测试结果显示最强生成模型Veo3.1-Fast的假视频仅有12.54%被识别,而最强检测系统Gemini 2.5-Pro准确率仅56%,远低于人类专家的81.25%。研究还发现检测系统过度依赖水印等表面特征,音频信息能提升检测准确性,但技术发展已对信息真实性判断带来严峻挑战。

如何让一张照片重建完整3D世界?

Meta超级智能实验室推出的SAM 3D模型,通过创新的"模型在环"数据标注流程和多阶段训练策略,成功实现从单张图像重建完整3D物体的能力。该研究打破了3D领域的数据壁垒,在真实世界场景中展现出远超现有方法的性能,为机器人、AR/VR、游戏制作等应用开启新可能。

Google DeepMind让AI画图快了一半,“预览模式“让创作者告别漫长等待

Google DeepMind团队提出了革命性的"扩散预览"模式,通过ConsistencySolver技术实现AI图像生成的"预览+精修"工作流程。该技术能在5-10步内生成高质量预览图像,与传统40步完整生成保持高度一致性,用户体验测试显示总体时间节省近50%,大大提高了创作效率和创意探索的自由度。

Turing 获得 1.11 亿美元融资,估值达到 22 亿美元,为 OpenAI 等大语言模型公司提供关键代码支持

ChatGPT 在新功能发布后半年内周活用户翻倍增长

Google 在其搜索引擎中推出 Gemini 2.0 和 AI 模式

A-MEM 框架如何支持强大的长上下文记忆,使大语言模型能够处理更复杂的任务

OpenAI 的 GPT-4.5 AI 模型向更多 ChatGPT 用户开放

ChatGPT 4.5 震撼发布:更大、更智能,但也更贵

ChatGPT 对手 Anthropic 估值 615 亿美元融资 35 亿美元加速 AI 研发

思科与英伟达扩大合作,助力企业加速应用AI技术

OpenAI 发布 GPT-4.5,但表示这并非前沿 AI 模型

OpenAI 发布迄今最大规模的 AI 模型 GPT-4.5 "Orion"