Nvidia发布AI Workbench和Hugging Face合作关系 走在生成式AI最前沿

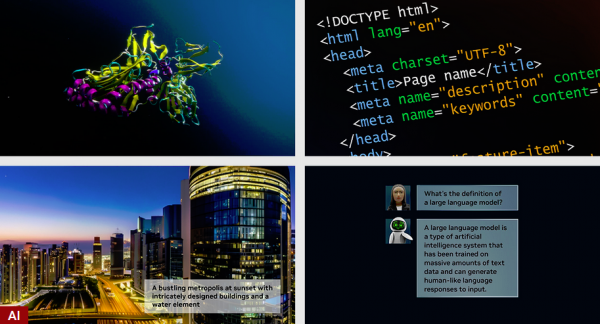

GPU制造商和AI提供商Nvidia近日宣布推出一系列新的生成式AI产品,旨在加速大型语言模型和其他先进AI应用的开发。

Nvidia此次在SIGGRAPH 2023大会上宣布与机器学习和AI工具开发公司Hugging Face建立新的合作伙伴关系,让开发人员可以在Nvidia DGX Cloud超级计算基础设施上部署和使用他们的生成式AI模型,以扩展工作负载。开发人员还将能够访问新的Nvidia AI Workbench,从而可以打包工作并在PC、工作站、云端以及Nvidia AI Enterprise 4.0等任何地方使用它。

Hugging Face和DGX Cloud的结合将让开发人员能够快速训练大型语言模型,这些模型是使用自己的业务数据定制的,用于特定行业的知识和应用,例如智能聊天机器人、搜索和摘要等用途。大型语言模型利用这样的超级计算能力就可以在强大的基础设施上进行培训和微调。

Nvidia公司创始人、首席执行官黄仁勋表示:“研究人员和开发人员是生成式AI核心,这正在改变每个行业。Hugging Face和Nvidia正在将全球最大的人工智能社区与全球领先的云端Nvidia AI计算平台连接起来。”

Hugging Face的平台支持超过15000个组织,构成的社区共享其用户构建、微调和部署的超过25万个AI模型和超过5万个数据集。

在此次合作中,Hugging Face将提供一项名为“Training Cluster as a Service”的全新服务,该服务将使用自己的平台和Nvidia DGX Cloud基础设施为企业客户简化全新自定义生成式AI模型的创建和定制,只需单击一下即可。

Nvidia DGX Cloud则由配备了8个H100或者A100 80 GB Tensor Core GPU的实例提供支持,每个节点总共有640GB GPU内存,从而提供了极高的性能,可用于训练和微调大量AI工作负载。

Nvidia AI Workbench:开发人员的工作空间

Nvidia AI Workbench是为开发人员提供的统一工作空间,让他们能够在需要使用的地方快速创建、测试和自定义他们预训练的生成式AI模型,这意味着他们可以使用他们自己的个人计算机、工作站、数据中心、公有云或者Nvidia DGX云端的虚拟机。

开发人员使用AI Workbench可以加载和自定义来自任何主流存储库(例如Hugging Face、GitHub和Nvidia NGC)的模型。

Nvidia企业计算副总裁Manuvir Das表示:“世界各地的企业都在寻找合适的基础设施并构建生成式AI模型和应用。Nvidia AI Workbench为跨组织团队提供了一条简化的路径来创建基于AI的应用,这些应用在现代商业中正变得越来越至关重要。”

相同的界面让开发人员可以打包他们的项目并将其跨不同的实例进行移动,他们可以在自己的PC上处理项目,在有必要的情况下将其移动到云端,而Workbench让打包过程变得更简单了,只需将其打包、移动并解压到云端即可继续开发。

Workbench AI还为开发人员提供了一整套生成式AI工具,包括企业级模型、软件开发套件、来自开源存储的库以及Nvidia AI平台,所有这一切都在统一的开发人员体验中。

Nvidia表示,许多AI基础设施提供商已经开始采用AI Workbench,包括戴尔、HPE、Lambda、联想以及Supermicro。

全新Nvidia AI Enterprise 4.0将先进AI引入生产

现在,企业借助Nvidia AI Enterprise 4.0可以获得采用生成式AI所需的工具,并构建将其连接到大规模生产应用所需的安全性和API。

新发布的AI Enterprise版本包括了云原生框架Nvidia NeMo,用于在完全托管的企业系统中构建、培训和部署大型语言模型,以创建生成式AI应用。那些希望扩展和优化AI部署的企业客户,则可以使用Triton管理服务实现自动化,该服务将自动在Kubernetes中部署多个推理服务器,并进行大规模模型编排。

Nvidia还通过Base Command Manager Essentials软件提供了集群管理功能,最大限度上提高不同数据中心的AI服务器性能,还可以管理跨不同云系统(包括多云和混合云)的AI模型使用情况。

Nvidia AI Enterprise 4.0发布之后,客户可以在合作伙伴的应用市场(包括Google Cloud)中找到。

好文章,需要你的鼓励

英伟达护城河难撼动,Gemini无法击败OpenAI

近期市场存在两种主流观点:英伟达的护城河因TPU等替代方案而受到侵蚀;谷歌及其Gemini模型将在AI搜索领域占据主导并击败OpenAI。研究显示这两种观点都被高估。英伟达的GB300和后续Vera Rubin将重塑AI经济学,凭借量产优势成为低成本生产商。谷歌面临创新者困境,将搜索转向聊天机器人体验会使查询服务成本增加100倍。OpenAI通过强调可信信息而非广告推送,正在颠覆现有在线体验模式,在企业市场获得更强地位。

让AI记住房间每个角落:悉尼大学团队如何让视频生成拥有“空间记忆“

悉尼大学和微软研究院联合团队开发出名为Spatia的创新视频生成系统,通过维护3D点云"空间记忆"解决了AI视频生成中的长期一致性难题。该系统采用动静分离机制,将静态场景保存为持久记忆,同时生成动态内容,支持精确相机控制和交互式3D编辑,在多项基准测试中表现优异。

马里兰大学突破性发现:AI推理过程终于有了“身体检查“——ThinkARM框架揭开大型语言模型思维奥秘

马里兰大学研究团队开发ThinkARM框架,首次系统分析AI推理过程。通过将思维分解为八种模式,发现AI存在三阶段推理节律,推理型与传统AI思维模式差异显著。研究揭示探索模式与正确性关联,不同效率优化方法对思维结构影响各异。这为AI系统诊断、改进提供新工具。

IBM推出SAP迁移管理工具应对2027年系统升级截止期

博通AI硬件收入激增65%,VMware业务稳健增长

英伟达发布Nemotron 3开源模型助力可扩展多智能体系统

从AI到模拟对抗,网络安全桌面演练今年有了新变化

Equity 2026年预测:AI智能体崛起、重磅IPO与风投行业变革

英伟达护城河难撼动,Gemini无法击败OpenAI

山河为证,荣誉加冕,华为乾崑助传祺向往S9首次智行中国顺利收官

全国首批10城菁彩Vivid影厅启幕,《山河故人》重映见证影像新纪元

工业和信息化部人形机器人与具身智能标准化技术委员会成立大会暨第一次全体委员会议召开

生命科学计算测试专委会正式成立,BioProfile框架引领行业标准建设

超智算完成北京核心智算中心资产收购,加速构筑“3+X”全国算力网络新格局

走出“参数崇拜”:联想用“一体多端”重塑“人的尺度”