将AIGC进行到底 NVIDIA SIGGRAPH带来生成式AI多项创新

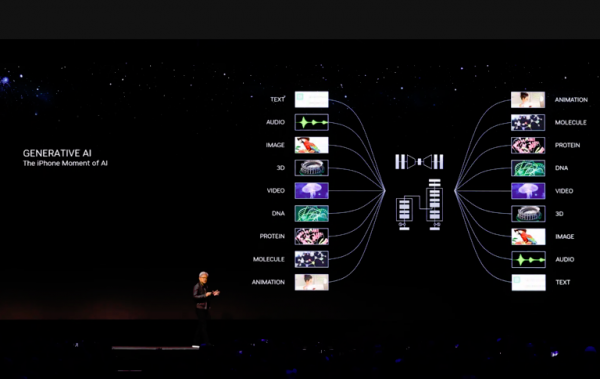

“生成式AI时代和AI的iPhone时刻已经到来”,NVIDIA创始人兼首席执行官黄仁勋在计算机图形大会SIGGRAPH上如是说。

毋庸置疑,当下属于AIGC,其实也属于NVIDIA,正是以ChatGPT为代表的AIGC浪潮将NVIDIA推上了万亿市值的宝座。

而在SIGGRAPH上,NVIDIA带来生成式AI多项创新,比如GH200 Grace Hopper超级芯片平台和NVIDIA AI Workbench全新统一工作空间、NVIDIA AI Enterprise 4.0,将AIGC进行到底。

缺货挡不住新品发布

加速AIGC,GPU必不可少,虽然黄仁勋一直说“买得越多,省得越多。”但是缺货却是不争的事实,不过缺货并不妨碍新品的发布。

NVIDIA除了GPU,还在拓展CPU、DPU,打造“3U一体”的产品矩阵。而Grace Hopper超级芯片从名字可以看出NVIDIA将自家的Grace CPU与GPU进行了融合。

第一代的Grace Hopper超级芯片是NVIDIA开发的基于Arm架构的CPU+GPU集成方案,它将72核的Grace CPU、Hopper GPU、96GB的HBM3和512 GB的LPDDR5X集成在同一个封装中,共有2000亿个晶体管。Grace Hopper超级芯片通过 NVIDIA NVLink-C2C技术将Grace和Hopper架构相结合,为加速AI和HPC应用提供CPU+GPU相结合的一致内存模型。提供了CPU和GPU之间惊人的数据带宽,高达1TB/s。

如今,新一代NVIDIA GH200 Grace Hopper平台也横空出世,其拥有144个Arm Neoverse内核、8petaflops的AI性能和282GB最新HBM3e内存技术。

新平台采用了Grace Hopper超级芯片,可以通过 NVIDIA NVLink与其他超级芯片连接,使它们能够协同工作,从而部署当下大型生成式AI模型。这种高速、一致性技术使GPU可以完全访问CPU内存,在双配置中可提供总计1.2TB的快速内存。

HBM3e内存比当前HBM3快50%,可提供总计10TB/s的带宽。这使得新平台能够运行比上一版本大3.5倍的模型,同时凭借快3倍的内存带宽提升性能。

采用HBM3e的新一代Grace Hopper超级芯片平台与NVIDIA MGX服务器规格完全兼容,可以轻松将Grace Hopper添加到100多款服务器机型中。

新一代Grace Hopper超级芯片平台让NVIDIA在AI性能表现更上一层楼,对于摩尔定律,大家耳熟能详。而透过NVIDIA的产品迭代,黄氏定律在迅猛发展,将单芯片AI推理能力每12个月翻一倍。

开启AI开发的新时代

大语言模型不光带来了AI的狂飙,还给开发者的开发能力带了全新的动能。

不过虽然市面上出现了很多开源的预训练模型,但是要是进行定制开发还是存在很多挑战,你需要在在多个在线资源库中搜索适当的框架、工具和容器,并运用合适的技能为特定用例定制模型。

为了统一AI开发空间,NVIDIA带来了NVIDIA AI Workbench。开发者通过在本地系统上运行的简单界面,从开源资源库和NVIDIA AI平台中获取所有必要的企业级模型、框架、软件开发工具包和库,使用自定义数据对来自Hugging Face、GitHub和NVIDIA NGC等常见资源库的模型进行微调,然后将这些模型扩展到几乎所有数据中心、公有云或NVIDIA DGX Cloud。

Hugging Face社区共享了超过25万个模型和5万个数据集,是AI开发者必去的地方。NVIDIA与Hugging Face一起为数百万开发者提供生成式AI超级计算,帮助他们构建大型语言模型等高级AI应用。开发者将能够使用Hugging Face平台内的NVIDIA DGX Cloud AI超级计算训练和调整高级AI模型。

除了面向开发者,NVIDIA宣布推出最新版本的企业软件平台——NVIDIA AI Enterprise 4.0,为企业提供采用生成式AI所需的工具,同时提供了可靠的生产部署所需的安全性和API稳定性。

NVIDIA AI Enterprise提供了NVIDIA NeMo、NVIDIA Triton管理服务、NVIDIA Base Command Manager Essentials集群管理软件使用户能够在云端、数据中心和边缘构建并运行NVIDIA AI解决方案。这套软件已被证实可在主流NVIDIA认证系统、NVIDIA DGX系统、所有主流云平台以及最新发布的NVIDIA RTX工作站上运行。

NVIDIA AI Enterprise 4.0将在AWS Marketplace、 Google Cloud、Microsoft Azure等合作伙伴的应用市场上架,并通过NVIDIA的云合作伙伴Oracle Cloud Infrastructure提供。

此外,NVIDIA还与ServiceNow、Snowflake、戴尔以及众多的MLOps提供商提供生成式AI解决方案和服务,简化生产级生成式AI模型的开发。

生成式AI来到元宇宙

曾经火热的元宇宙被AIGC抢了风头。NVIDIA Omniverse是面向元宇宙的平台,现在NVIDIA也将生成式AI带到了元宇宙。

NVIDIA Omniverse带来重要更新,包括ChatUSD、RunUSD、DeepSearch、USD-GDN Publisher,方便开发者能够更加流畅地实施和部署OpenUSD流程和应用,以利用OpenUSD框架和生成式AI优化和增强3D流程和虚拟世界。

此外,NVIDIA和Adobe宣布计划将在Omniverse为用户提供Adobe Firefly(Adobe的创作生成式AI模型系列)的API接口,以扩大双方在Adobe Substance 3D、生成式AI和OpenUSD项目方面的合作。

Omniverse用户现在可以构建与其他基于OpenUSD的空间计算平台(例如ARKit和RealityKit)兼容的内容、体验和应用程序。

为了赋能元宇宙的开发与内容创作,NVIDIA推出搭载全新NVIDIA L40S GPU的NVIDIA OVX服务器,通过NVIDIA Omniverse平台,加速计算密集型的复杂应用,包括AI训练与推理、3D设计与可视化、视频处理以及工业数字化等。

NVIDIA还发布了三款全新的桌面工作站基于Ada架构的GPU——NVIDIA RTX 5000、RTX 4500和RTX 4000,为全球专业人员提供最新的AI、图形和实时渲染技术。来自BOXX、戴尔科技、惠普和联想等厂商的全新RTX工作站配备NVIDIA RTX 6000 Ada GPU以及 NVIDIA AI Enterprise和NVIDIA Omniverse Enterprise软件,为生成式AI和数字化时代的开发和内容创建提供更强大的算力。

结语

正像iPhone预示着移动互联网的到来,ChatGPT也拉开了AGI的大幕。NVIDIA在硬件和软件层面持续创新迭代,为生成式AI带来蓬勃发展的动力。

时光不负有心人,星光不负赶路人。虽然我们已经掀开AGI的一角,但是未来需要走的路还很长,这有赖于整个产业链的紧密协同。

好文章,需要你的鼓励

英伟达护城河难撼动,Gemini无法击败OpenAI

近期市场存在两种主流观点:英伟达的护城河因TPU等替代方案而受到侵蚀;谷歌及其Gemini模型将在AI搜索领域占据主导并击败OpenAI。研究显示这两种观点都被高估。英伟达的GB300和后续Vera Rubin将重塑AI经济学,凭借量产优势成为低成本生产商。谷歌面临创新者困境,将搜索转向聊天机器人体验会使查询服务成本增加100倍。OpenAI通过强调可信信息而非广告推送,正在颠覆现有在线体验模式,在企业市场获得更强地位。

让AI记住房间每个角落:悉尼大学团队如何让视频生成拥有“空间记忆“

悉尼大学和微软研究院联合团队开发出名为Spatia的创新视频生成系统,通过维护3D点云"空间记忆"解决了AI视频生成中的长期一致性难题。该系统采用动静分离机制,将静态场景保存为持久记忆,同时生成动态内容,支持精确相机控制和交互式3D编辑,在多项基准测试中表现优异。

马里兰大学突破性发现:AI推理过程终于有了“身体检查“——ThinkARM框架揭开大型语言模型思维奥秘

马里兰大学研究团队开发ThinkARM框架,首次系统分析AI推理过程。通过将思维分解为八种模式,发现AI存在三阶段推理节律,推理型与传统AI思维模式差异显著。研究揭示探索模式与正确性关联,不同效率优化方法对思维结构影响各异。这为AI系统诊断、改进提供新工具。

IBM推出SAP迁移管理工具应对2027年系统升级截止期

博通AI硬件收入激增65%,VMware业务稳健增长

英伟达发布Nemotron 3开源模型助力可扩展多智能体系统

从AI到模拟对抗,网络安全桌面演练今年有了新变化

Equity 2026年预测:AI智能体崛起、重磅IPO与风投行业变革

英伟达护城河难撼动,Gemini无法击败OpenAI

山河为证,荣誉加冕,华为乾崑助传祺向往S9首次智行中国顺利收官

全国首批10城菁彩Vivid影厅启幕,《山河故人》重映见证影像新纪元

工业和信息化部人形机器人与具身智能标准化技术委员会成立大会暨第一次全体委员会议召开

生命科学计算测试专委会正式成立,BioProfile框架引领行业标准建设

超智算完成北京核心智算中心资产收购,加速构筑“3+X”全国算力网络新格局

走出“参数崇拜”:联想用“一体多端”重塑“人的尺度”