这个“五一”,用AI来创作你的绘画大作吧

AI绘画是近年来热门的话题之一,不仅仅局限于艺术家群体,已经有越来越多的人和机构,通过AI绘画来实现自己的创作需求。譬如游戏公司,通过AI绘画来获得初级的场景和人物形象素材;电商公司,通过AI绘画更快地实现产品描述配图等。

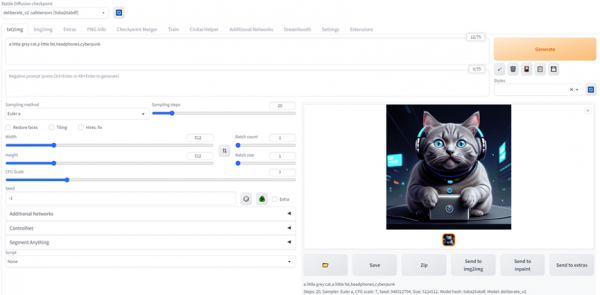

去年11月,UCloud上线了AI绘画stable diffusion平台,在GPU云主机内置stable diffusion模型,提供jupyter可编程页面,根据用户的创意描述来生成图片。今年,UCloud将AI绘画平台全新升级,内置可视化操作界面,提供图像精准控制(Controlnet)、图像分割(Segment Anything)、图像微调等插件,为艺术创作者和设计师提供更多便利。

在UCloud使用AI绘画服务,创建仅需三步:

1) 创建GPU云主机,镜像市场选择“AI绘图 Web UI”镜像,防火墙策略开放7860端口接口

2) 登录GPU云主机,执行镜像首页提示的命令,就可快速启动AI绘画服务

3) 登录http://eip:7860即可访问stable diffusion Web UI页面(EIP为创建的GPU云主机的外网ip)

*参考文档:

https://docs.ucloud.cn/gpu/practice/stable_diffusion_webui

产品新特性:

可视化操作界面,预装多种风格模型

目前已预装stable-diffusionV1.5,stable-diffusionV2.1,anythingV3(动漫风格),dreamlike-photoreal(写实风格),deliberate_v2(写实风格)等模型。

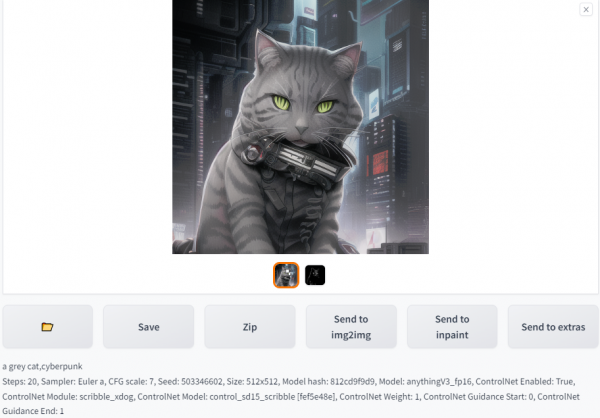

以Prompt:

“a grey cat, headphone, cyberpunk”为例,不同模型出图效果示例如下:

Anything V3

Deliberate

Stable diffusionV2.1

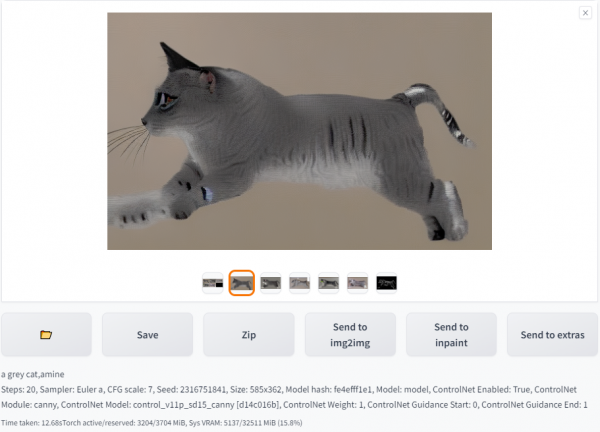

图像精准控制

在AI绘画平台镜像中,已配置Controlnet插件,预装了canny、openpose、scribble等图像精准控制模型,支持边缘检测、pose指定、涂鸦等图像条件输入。

以canny模型为例,输入及输出结果如下:

Input

Output

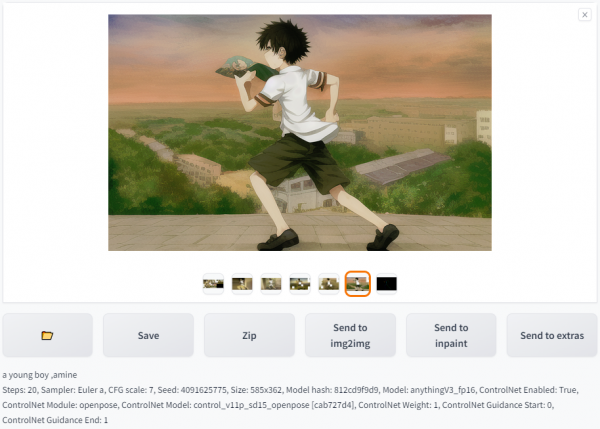

以openpose模型为例,输入及输出结果如下:

Input

Output

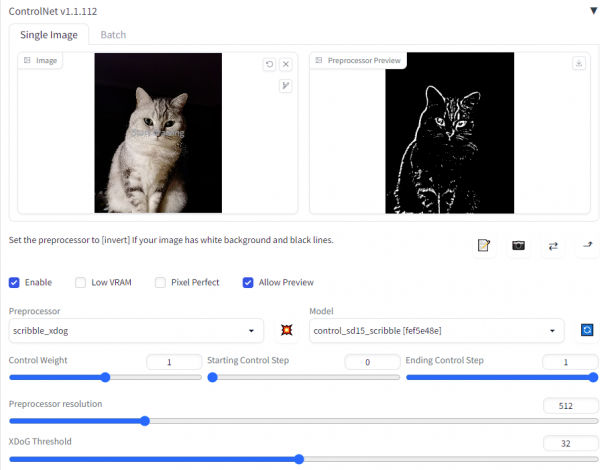

以scribble模型为例,输入及输出结果如下:

Input

Output

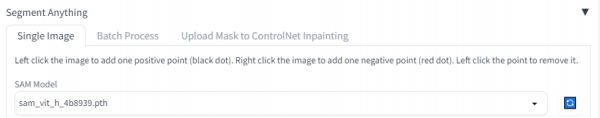

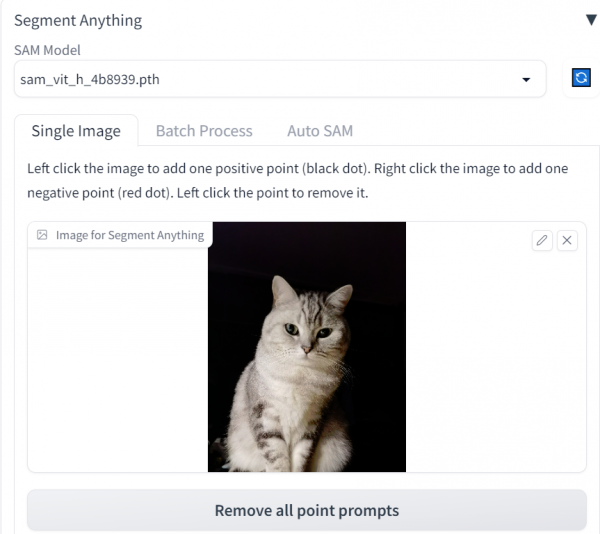

图像分割

预装segment anything插件,支持图像分层,切割,单次可处理单张或多张图片。页面预览如下:

例如输入一只猫的图片,基于预装的sam模型,可以快速实现图像的分层、蒙版、分割。如下图所示:

Input

Output

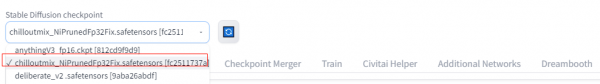

图像微调

AI绘画平台镜像预装Additional-Networks插件,支持基于LoRA模型微调图片风格。

在webui页面操作步骤如下:

1) Checkpoint选择

“chilloutmix_NiPrunedFp32Fix.safetensors”

2) 选择“Additional Network”

3) module选择“LoRA”

4) 选择需要叠加的风格模型

模型选择页面

以Prompt:

“a grey cat, headphone, cyberpunk”为例,如图所示模型输出结果如下:

Input

Output

写在最后

AI绘画的应用场景非常广泛,可以用来创作美术作品、设计图形、制作动画和游戏等。它能够快速地生成高质量的图像和图形,同时还能够自动化一些重复性的工作,节省了大量的时间和精力。所以,不论您是专业的绘画爱好者,还是对AI技术感兴趣的普通人,都欢迎通过我们的AI绘画服务来体验一次AI与艺术的融合。

更多产品咨询,请扫码了解

来源:业界供稿

好文章,需要你的鼓励

不用再训练AI模型,香港科技大学团队发明“智能管家“,让AI一眼就知道该抓哪里用哪里

香港科技大学团队开发出A4-Agent智能系统,无需训练即可让AI理解物品的可操作性。该系统通过"想象-思考-定位"三步法模仿人类认知过程,在多个测试中超越了需要专门训练的传统方法。这项技术为智能机器人发展提供了新思路,使其能够像人类一样举一反三地处理未见过的新物品和任务。

YouTube推出基于Gemini 3的创作者游戏制作工具

YouTube Gaming宣布推出Playables Builder开放测试版,允许特定创作者使用基于Gemini 3的原型网页应用制作小型游戏,无需编程知识。该工具类似于Google Labs的Disco和GenTabs项目,通过自然语言输入生成交互式内容。尽管AI助手能帮助用户无需技术知识即可创作,但优秀游戏需要技巧、迭代和专业知识才能打造真正有趣的体验。

韩国KAIST让SVG动画脱胎换骨:AI如何破解矢量图形的“语义迷宫“让静态图标活起来

韩国KAIST开发的Vector Prism系统通过多视角观察和统计推理,解决了AI无法理解SVG图形语义结构的难题。该系统能将用户的自然语言描述自动转换为精美的矢量动画,生成的动画文件比传统视频小54倍,在多项评估中超越顶级竞争对手,为数字创意产业带来重大突破。

苹果发现:只需一个注意力层,就能让AI图像生成既快又好

YouTube推出基于Gemini 3的创作者游戏制作工具

英伟达是唯一能负担免费提供AI模型的厂商

OpenAI发布新旗舰图像生成AI模型GPT Image 1.5

脑启发算法可大幅降低AI能耗

Mac办公桌升级必备配件指南:提升工作效率的最佳选择

PTC Windchill+ 助力 HOLON研发全球首批符合汽车行业标准的 L4 级电动汽车

航旅行业的AI“乘法效应”:迈向指数级进化

OpenAI推出GPT Image 1.5模型加速图像生成竞争

Zoom推出AI Companion 3.0智能体工作流程

ChatGPT成为互联网最受阻止的爬虫机器人

英伟达推出开源权重模型填补美国AI市场空白