AI芯片设计:模块布局之梦正照进现实

类似于室内设计师将椅子、桌子和其他家具布置在家居环境之内,芯片设计师也需要搞清楚处理器的各部分组件要如何放置在平面图上,同时充分考虑到各组件间的往来延迟。

室内设计师需要考虑房间内空间和起居使用的便利性,而芯片设计师则关注功率、性能和面积与宏单元位置的影响。内存等晶体管、PCI-Express控制器或内存控制器等模拟设备,甚至是核心本身,都需要在半导体设备上找到属于自己的安放点位。

长久以来,这两个步骤一直依靠手动方式完成——首先放置宏单元,之后放置无数较小的标准单元。近期,设计人员开始采用更为混合的方法,同时放置宏单元和标准单元,于是挑战性也达到新的高度。

英伟达研究科学家Anthony Agnesina和Mark Ren在最近讨论AI辅助宏单元布局的博文中写道,“这些宏单元往往比标准单元大得多,而标准单元则是数字设计的基本构建块。宏布局对于芯片布局有着巨大影响,直接决定着许多设计指标,例如面积和功耗。因此,改进这些宏单元的布局,对于优化每块芯片的性能和效率至关重要。考虑到宏布局、标准单元而已以及由此产生的功能、性能与面积(PPA)之间的复杂关系,必须想办法改进这一设计流程。”

近年来出现的新方法,包括借助强化学习(算法和神经网络通过对大量宏单元放置示例进行采样学习)实现对并发单元和宏单元的布置。英伟达建议使用DREAMPlace,也就是该公司于2019年首次推出的GPU加速开源深度学习工具包,尝试在芯片上放置超大规模集成(VLSI)电路,彻底颠覆以往以手动方式设计宏单元和标准单元布局的老办法。

英伟达还建议调整当前并发单元和宏单元的布局设计方式,例如使用多目标优化框架来扩展搜索空间以缩小“最优性差距”,也就是拉近已知最佳解决方案与设计方案下限值之间的差距。

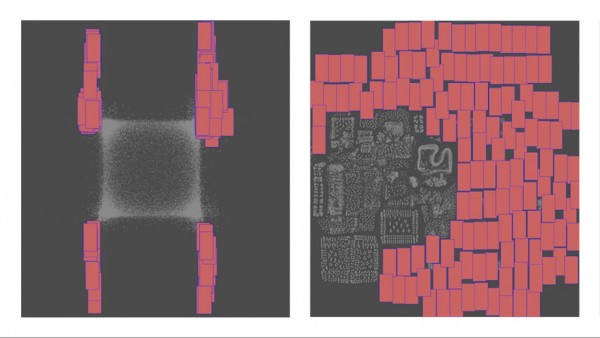

DREAMPlace是一款使用PyTorch深度学习框架和工具包创建的分析放置器,可使用放置问题来训练神经网络。英伟达科学家们在日前的国际物理设计研讨会上发表了AutoDMP(基于自动DREAMPlace的宏布局)研究论文,这也标志着这家GPU巨头乃至整个半导体行业都在探索如何利用AI设计出更强大、更高效的新型芯片。

AutoDMP整合了上周英伟达在GTC 2023大会上展示的所有前沿和核心组件,能够覆盖从GPU加速到机器学习技术、再到提高效率与降低功耗等各类需求。

作为八位参与研究的英伟达团队成员,Agnesina和Ren写道,“这项工作表明,使用基于机器学习的多目标优化和GPU加速数值布局工具,可以有效探索广阔的设计空间,找到更好的宏布局解决方案。DREAMPlace将布局问题表述为布局密度约束下的线长优化问题,并对其进行数值求解。”

据研究人员介绍,这里提出的方法要求使用多目标树结构Parzen估计器(MOTPE)贝叶斯优化算法,通过调整布局器的参数来探索设计空间,最终全力追求三大基本目标——线长、单元密度和降低通信拥塞。其中还包含一个双层功率、性能和面积(PPA)评估方案,用以管理搜索空间的复杂度。论文提到,英伟达还鼓励对DREAMPlace布局引擎做进一步优化,“以减少合法化问题并显著扩展其设计空间,从而改善潜在的可实现PPA指标。”

Agnesina和Ren写道,“我们建议在参数空间中使用多目标优化,而非单目标优化。需要相互权衡的目标分别为线长、密度和通信拥塞度。线长近似于直线施泰纳最小树(RSMT)长度。密度是指DREAMPlace中使用的目标单元密度。最后,使用RUDY算法估计拥塞情况。”

研究人员在DREAMPlace中选择了16个参数来定义设计空间。Agnesina和Ren解释道,这些参数“是根据对布局质量有显著影响的观察结果而一一确定的。”“其中包括与优化相关的参数(例如基于梯度的数值优化器及其学习率)和物理参数(例如用于密度评估的bin数和密度目标)。多目标优化力图找到帕累托边界,这是一组非支配的目标空间点,代表着若不降低至少一个其他目标,则任何目标均无法继续改进。”

他们还在DREAMPlace之外添加了新的参数,包括最初将单元和宏布置在底板中心,这样会影响最终布局的质量。此外,为了简化宏单元的合法保证(所谓宏单元的合法性,就是确保宏单元间互不重叠,且符合各种设计约束),他们还添加了两个参数以确保宏单元间的最小垂直和水平间距。

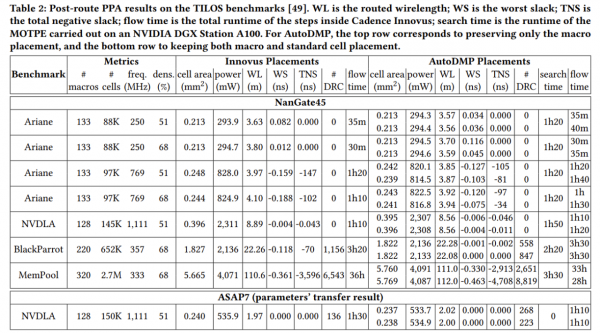

AutoDMP还接受了TILOS AI研究所的宏布局基准测试的评估,其中包含带有大量宏单元的CPU与AI加速器设计。在评估当中,研究人员将AutoDMP与商业EDA工具相集成,并在英伟达DGX AI系统上运行了多目标优化。这套系统包含四个“Ampere”A100 GPU加速器,各加速器均具有80 GB的高带宽内存。测试会启动16个并行进程来采样参数并运行DREAMPlace,选定的布局则被纳入由CPU驱动的TILOS EDA流程接受检验。

通过调整DREAMPlace中的增强参数并引入多目标优化机制,研究人员发现,他们能够在几个小时之内在DGX系统上生成宏布局选项——包括为每份设计做1000个设计点采样。实际效果不仅超越了开源学术工具、比肩商业产品,“这样的进步更有助于缩短早期架构探索周期,更准确、更高效地评估布局修改决策。”

Agnesina和Ren最后总结道,“这项工作证明,将GPU加速布局器与AI/机器学习多目标码数优化相结合将带来切实优势。此外,考虑到可扩展性在现代芯片设计流程中的重要意义,我们希望这种方法能够为新的前瞻性设计空间探索翻开历史性的又一篇章。”

好文章,需要你的鼓励

西班牙病毒如何将谷歌带到马拉加

33年后,贝尔纳多·金特罗决定寻找改变他人生的那个人——创造马拉加病毒的匿名程序员。这个相对无害的病毒激发了金特罗对网络安全的热情,促使他创立了VirusTotal公司,该公司于2012年被谷歌收购。这次收购将谷歌的欧洲网络安全中心带到了马拉加,使这座西班牙城市转变为科技中心。通过深入研究病毒代码和媒体寻人,金特罗最终发现病毒创造者是已故的安东尼奥·恩里克·阿斯托尔加。

让AI记住房间每个角落:悉尼大学团队如何让视频生成拥有“空间记忆“

悉尼大学和微软研究院联合团队开发出名为Spatia的创新视频生成系统,通过维护3D点云"空间记忆"解决了AI视频生成中的长期一致性难题。该系统采用动静分离机制,将静态场景保存为持久记忆,同时生成动态内容,支持精确相机控制和交互式3D编辑,在多项基准测试中表现优异。

LangChain核心库曝出严重漏洞,AI智能体机密信息面临泄露风险

人工智能安全公司Cyata发现LangChain核心库存在严重漏洞"LangGrinch",CVE编号为2025-68664,CVSS评分达9.3分。该漏洞可导致攻击者窃取敏感机密信息,甚至可能升级为远程代码执行。LangChain核心库下载量约8.47亿次,是AI智能体生态系统的基础组件。漏洞源于序列化和反序列化注入问题,可通过提示注入触发。目前补丁已发布,建议立即更新至1.2.5或0.3.81版本。

马里兰大学突破性发现:AI推理过程终于有了“身体检查“——ThinkARM框架揭开大型语言模型思维奥秘

马里兰大学研究团队开发ThinkARM框架,首次系统分析AI推理过程。通过将思维分解为八种模式,发现AI存在三阶段推理节律,推理型与传统AI思维模式差异显著。研究揭示探索模式与正确性关联,不同效率优化方法对思维结构影响各异。这为AI系统诊断、改进提供新工具。

LangChain核心库曝出严重漏洞,AI智能体机密信息面临泄露风险

Mill如何与亚马逊和全食超市达成合作协议

TechCrunch创业大赛中的9家顶尖生物技术初创公司

2025年印度科技领域十大重要发展

中科大发布Live Avatar:AI数字人无限聊天不翻车

从软件定义汽车到AI驱动质控:Testin云测助力车机测试数智化价值落地

无需Linux即可运行自由开源软件

超越 SEO:AI 引擎优化如何改变在线可见性格局

新Mac必装应用:五款提升工作效率的神器推荐

DXC蒲公英计划:为神经多样性IT专业人士赋能

AMD Strix Halo与Nvidia DGX Spark:哪款AI工作站更胜一筹?

类人机器人投资热潮涌现但商业化仍需数十年