NVIDIA GTC 2023让AI芯片市场卷起来 原创

一大早被NVIDIA GTC的新闻刷屏了,印象深刻的是黄教主说“我们正处于AI的iPhone时刻”。就像二战时候的诺曼底登陆,iPhone成为传统手机与智能手机的分水岭。

近期ChatGPT的持续火爆无疑为点燃了人们对于AI的乐观清晰,而作为为AI提供“燃料”的NVIDIA也成为关注的焦点。

不妨我们盘点一下这次GTC大会上的重点发布:

1、NVIDIA DGX Cloud人工智能云服务,它可以让企业快速访问为生成式人工智能和其他开创性应用训练高级模型所需的基础设施和软件。

2、NVIDIA cuLitho,这是一套可以集成在NVIDIA Hopper架构中的光刻库。使用NVIDIA cuLitho软件库加上NVIDIA Hopper GPU替代目前光刻机上使用的CPU,整体的效率可以提升40倍左右,减少目前每年消耗数百亿CPU小时的大量计算工作负载。

3、用于普及生成式AI的推理平台。NVIDIA推出了用于AI推理的DGX H100计算平台,以及H100 NVL、L4 GPU。

4、BlueField-3 DPU,通过从CPU卸载数据中心基础设施任务来大幅提升性能和效率。因此它可以将工作负载的运行速度提高8倍。

5、二合一超级芯片,去年在GTC 2022上,英伟达发布了首款用于数据中心的CPU架构“Grace”,以及已经上市的高性能计算GPU架构“Hopper”。而基于这两种架构,打造了超级芯片——Grace CPU+Hopper GPU。

6、NVIDIA联合Quantum Machines推出量子级运算系统“DGX Quantum”,这是首个结合GPU与量子运算的系統。该加速运算的系统将NVIDIA的Grace Hopper超级芯片与CUDA Quantum开源平台,以及Quantum Machines的量子处理器OPX+结合,使其兼具量子运算与经典运算。

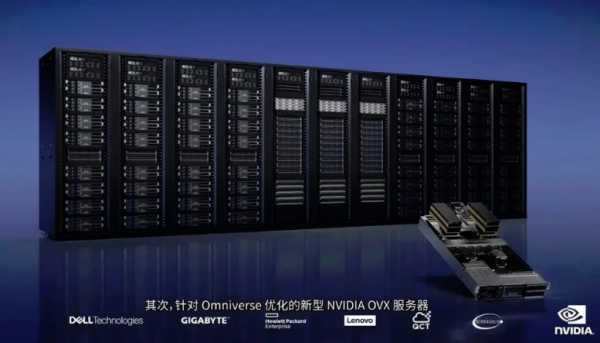

7、面向元宇宙领域,NVIDIA推出了第三代OVX计算系统和新一代工作站,为基于NVIDIA Omniverse Enterprise的大规模数字孪生提供动力。

……

其实GTC的发布还有很多,我这里只是列举出了事关半导体芯片,从这一列的发布,我们不难看出虽然半导体市场从去年开始已经呈现了趋缓状态,但是AI算力芯片更卷了。

算力云化趋势不改

云计算实现了计算的服务化,而AI对算力的需求更大,巨量的云端算力势在必行。

NVIDIA DGX Cloud提供NVIDIA DGX AI超级计算专用集群,每个DGX Cloud中都集成了8个NVIDIA H100或A100 80GB Tensor Core的GPU,每个节点合计有640GB的GPU,这个巨大的GPU可以满足高级AI训练的性能要求。

AI训练方面,英伟达H100 GPU基于Hopper架构及其内置Transformer Engine,针对生成式AI、大型语言模型和推荐系统的开发、训练和部署进行了优化,利用FP8精度在大型语言模型上比上一代A100提供了快9倍的AI训练和快30倍的AI推理。

除了算力供给,NVIDIA宣布了一个全新的NVIDIA AI Foundations模型,涵盖NVIDIA NeMo语言和NVIDIA Picasso图像、视频和3D等服务。

面向AI推理

众所周知,GPU更多是面向AI训练,而是AI还需要推理。NVIDIA宣布推出3款全新推理GPU,分别擅长AI视频、图像生成、ChatGPT等大型语言模型的推理加速。

H100 NVL的推出,是为了服务于大型语言模型的服务提供商,配备双GPU NVLink,将两张拥有94GB HBM3显存的PCIe H100 GPU拼接在一起,可处理拥有1750亿参数的GPT-3大模型,同时支持商用PCIe服务器轻松扩展。

L4 GPU专门用于为AI生成视频提供硬件支持。NVIDIA表示,它处理AI生成视频的能力是CPU的120倍,能效提高了99%。一台8-GPU L4服务器将取代100多台用于处理AI视频的双插槽CPU服务器。

半导体即AI

芯片生产离不开光刻,光刻是芯片制造过程中最复杂、最昂贵、最关键的环节,其成本约占整个硅片加工成本的1/3甚至更多。NVIDIA cuLitho将AI带到了芯片生产的源头。

目前半导体不断提升nm极限,但是挑战也越来越大。光刻计算库cuLitho将计算光刻加速40倍以上,使得2nm及更先进芯片的生产成为可能。

NVIDIA目前已经和AMSL、台积电(TSMC)以及新思科技(Synopsys)建立了合作关系,ASML计划将搭载了NVIDIA cuLitho软件库的NVIDIA Hopper GPU集成在他们所生产的光刻机设备中去。

在芯片的光刻过程中,500个NVIDIA DGX H100组成的系统能够全面覆盖当下40000个CPU服务器相当的工作量。在集成了cuLitho软件库之后,晶圆厂每天生产掩模的速度相比当下提升了3-5倍,使用的功率比当前减少了9倍。

DPU与量子计算

目前芯片异构是趋势,而NVIDIA 3U一体战略就是瞄准CPU、GPU、DPU。

数据处理单元(DPU)方面,黄仁勋宣布英伟达BlueField-3 DPU已投入生产,并被百度、CoreWeave、京东、微软Azure、Oracle OCI、腾讯游戏等领先的云服务提供商所采用,以加速其云计算平台。

传统经典计算虽然还在发挥重要作用,但是量子计算也已经在路上。面向量子计算,要从量子噪声和退相干中恢复数据,需要对大量量子比特进行纠错。对此,英伟达与Quantum Machines合作推出了一个量子控制链路,它可将英伟达GPU连接到量子计算机,以极快的速度进行纠错。

双方合作研发的全球首个GPU加速量子计算系统NVIDIA DGX Quantum,将强大的加速计算平台(由NVIDIA Grace Hopper超级芯片和CUDA量子开源编程模型支持)与全球最先进的量子控制平台OPX结合在一起,使研究人员能够构建强大的应用,将量子计算与最先进的经典计算结合起来,实现校准、控制、量子纠错和混合算法。

NVIDIA DGX Quantum的核心是NVIDIA Grace Hopper系统,通过PCIe连接到通用量子控制系统Quantum Machines OPX+,实现QPU和量子之间的亚微秒延迟处理单元(QPU)。

DGX Quantum还为开发人员配备了一款强大的混合GPU-Quantum编程模型NVIDIA CUDA Quantum,可以在一个系统中集成QPU、GPU、CPU并进行编程。多家量子硬件公司将CUDA Quantum集成到他们的平台中。

元宇宙时代的算力

虽然元宇宙的风头被ChatGPT抢了很多,但是元宇宙的前景还是非常吸引人的。

针对元宇宙的算力需求,第三代OVX服务器通过组合双CPU平台、BlueField-3 DPU、L40 GPU、两个ConnectX-7 SmartNIC和NVIDIA Spectrum以太网平台,提供了突破性的图形和AI性能,可加速大规模数字孪生模拟等应用,进而提高运营效率和预测性规划功能。

企业可以利用OVX性能在可视化、虚拟工作站和数据中心处理工作流程等方面进行协作。

此外,新一代NVIDIA RTX工作站RTX 4000 SFF Ada Generation采用英伟达Ada Lovelace GPU、ConnectX-6 Dx SmartNIC和英特尔至强处理器。最新发布的RTX 5000 Ada一代笔记本电脑GPU使专业人士能随时随地访问Omniverse和工业元宇宙工作负载。

结语

21世纪什么最贵?人才,我觉得算力才对。

特别是ChatGPT掀起的大模型浪潮,其对算力的需求是巨大的,简直是惊人的。随之而来的就是Money。

目前整个算力产业链都在积极努力,不管是NVIDIA这样的芯片厂商,还是云厂商,他们无一例外尝试解决算力供给问题。

本届GTC大会应该是一场算力盛宴,也拉开了AI芯片的激烈竞争大幕。只要AI的浪潮此起彼伏,算力市场也就不会沉默,一场场好戏也将轮番登场。

好文章,需要你的鼓励

让AI看图功能瘦身90%:希腊塞萨洛尼基大学发现图像修复“中奖彩票“神经网络

希腊塞萨洛尼基大学研究团队开发出MIR-L算法,通过"彩票假说"发现大型图像修复网络中的关键子网络。该算法采用迭代剪枝策略,将网络参数减少90%的同时保持甚至提升修复性能。MIR-L能同时处理去雨、去雾、降噪等多种图片问题,为资源受限设备的实时图像处理提供了高效解决方案,具有重要的实用价值和环保意义。

人工智能使用大揭秘:OpenRouter公司百万亿规模数据分析报告

这项由OpenRouter公司团队和Andreessen Horowitz(a16z)投资机构联合开展的研究,于2025年12月发表。

卡内基梅隆大学提出DistCA:让AI训练告别“木桶效应“的神奇技术

卡内基梅隆大学团队提出DistCA技术,通过分离AI模型中的注意力计算解决长文本训练负载不平衡问题。该技术将计算密集的注意力任务独立调度到专门服务器,配合乒乓执行机制隐藏通信开销,在512个GPU的大规模实验中实现35%的训练加速,为高效长文本AI模型训练提供了新方案。

NVIDIA Nemotron 3 系列开放模型: 击穿AI“工程墙”开启“Agentic AI”的“Linux时刻”

W.AWARDS金网奖2026未来商业计划领航秀峰会收官

人工智能使用大揭秘:OpenRouter公司百万亿规模数据分析报告

智能化与全球化并进,IBM中国下一个40年思考

通用汽车推出原生Apple Music应用并支持空间音频

GMV推进卫星导航技术助力自动驾驶运输与物流发展

英伟达考虑增产H200芯片满足中国市场激增需求

IBM推出开源智能体CUGA 任务完成率超五成

OpenAI支持的生物技术公司Chai Discovery获1.3亿美元B轮融资

八问智能时代:西云数据的八个答案

塑造2026年的八大智能手机趋势

AI架构师荣获《时代》杂志年度人物称号