IBM运用基础模型加生成式AI,展示开创性AI研究成果

AI已经凭借卓越的现实表现,证明了自己颠覆行业、加速科学研究的力量。而目前最具开拓性的AI研究领域,当数基础模型与生成式AI——在其支持下,计算机能够根据输入数据生成大量原创内容。这项技术已被用于创作音乐、绘画乃至虚假新闻等各种素材。

近期,OpenAI免费发布了最先进的生成式transformer模型ChatGPT。此子一经亮相便引发媒体的广泛关注与用户的真诚赞赏,再次凸显出人工智能的可观潜力。

面对OpenAI旗下GPT-3系列模型带来的巨大冲击,谷歌和微软也纷纷拿出各自的搜索引擎AI集成计划。OpenAI的破圈效应无疑会提升公众对未来更先进AI产品的预期和需求,ChatGPT掀起的这股风潮也成为技术行业史上最快、最重大的颠覆性变革。

但一切科技皆当以人为本。在本文中,我们观察了AI在创造新型抗生素及其他科学AI工具方面的实际应用,证明了AI拯救生命的潜力。基础模型与生成式AI的创新,也将让增加收入、优化流程和简化知识创造/积累成为可能,同时挽救全球数以百万计的生命。希望本文能带大家了解AI中蕴藏的巨大潜力,同时感受到进一步扩大AI开发与部署的重要意义。

从简单算法到突破性进展

人工智能(AI)这个诞生于1950年代的概念其实背景并不复杂,当时代表的就是为了解决特定任务所设计出的简单算法和数学模型。经过几十年的发展演变,AI于1990年代迎来了向着机器学习算法的重大转变。机器学习算法使得计算机能够分析数据模式,并将这些知识转移到新的应用场景以提高性能表现。这种转变旋即引发了领域内众多突破,包括深度学习算法的开发——这类算法彻底改变了计算机视觉与自然语言处理(NLP)的实际产出。由此带来的新成就,又反过来坚定了人们探索AI潜力的信心。

如今,AI研究人员已经开发出能够处理更多复杂任务的新算法和模型,不断探索着智能科学的新边界。AI与模型正以前所未有的速度发展,产生更像人类的反应,并不断拓展可行的任务执行范围。在自然语言处理、计算机视觉和机器人技术等领域,一个个前所未见的目标被达成。尽管仍存在局限和挑战,但AI已经证明自己有资格成为跨各个行业和领域的变革性力量,全面涵盖医疗保健、金融、交通和教育等。

IBM Master Inventor推动的前沿AI研究

IBM掌握着全球规模最大、资金最为充足的AI研究项目之一。最近,我们有幸与IBM研究院的主要研究员、IBM Master Inventor(发明大师)兼主管Payel Das博士讨论了他主导的项目。

Das博士曾任哥伦比亚大学应用物理与应用数学系(APAM)兼职副教授,目前是石溪大学应用数学(AMS)的顾问委员会成员。Das博士本科就读于印度加尔各答总统学院,硕士毕业于印度钦奈的印度理工学院。她随后在得克萨斯州休斯顿的莱斯大学获得理论生物物理学博士学位。Das博士曾参与合著40多篇同行评审论文,获得哈佛贝尔弗中心TAPP 2021与IEEE开源2022奖项。在IBM之内,她先后拿下IBM杰出技术成就奖(IBM最高技术奖项)、两项IBM Research Division奖、一项IBM Eminence and Excellence奖以及两项IBM发明成果奖。

作为可信AI部门成员与IBM研究院生成式AI负责人,Das博士目前专注于开发新的算法、方法和工具,助力打造更多由基础模型建立的生成式AI系统。

她的团队还致力于通过合成数据提高AI模型的可信度,确保下游AI应用获得更好的公平性和稳健性。

合成数据——推动AI发展的重要力量

在如今这个数据驱动的时代,合成数据已经成为AI模型测试与训练中的重要工具。这类由计算机生成的信息拥有更高的成本效益、具备自动标记,而且避免了用真实数据训练深度学习模型所引发的道德、保障和隐私等争议。

合成数据在业务应用中也发挥着至关重要的作用,能够在真实数据匮乏甚至缺失时提供解决方案。合成数据的一大优势在于能够批量生成,这使其成为AI模型训练的理想选择。此外,还可以通过设计让合成数据包含各种变体和示例,从而提高模型的泛化度和可用性。在这种种特性的加持下,合成数据成为推动AI发展和实际落地的关键工具。

更重要的是,纯生成的合成数据能保证遵守用户定义的控制要求,从而达成预期目标并将潜在风险降至最低。具体的控制要求取决于预期应用和预期的结果。只要确保合成数据与控制要求保持一致,模型在后续的实际应用中将获得更好的有效性和安全性。

通用表示模型正在塑造未来

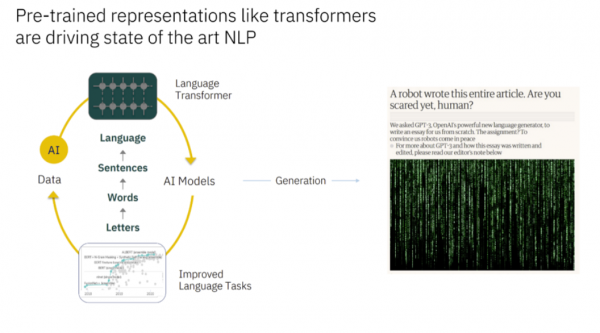

Transformer模型已被广泛用于各种应用场景,并被证明对处理自然语言等复杂数据具有奇效。

最初的AI模型使用的是前馈神经网络,虽然在非序列数据建模方面表现不错,但却不具备处理顺序数据的能力。为了克服这个限制,卷积神经网络(RNN)在1990年代被发明了出来,但直到2010年左右才得到广泛实施。

这一技术突破扩展了AI处理顺序数据的能力,也为该领域的进一步发展铺平了道路。之后亮相的是transformer——这一AI模型家族从根本上提高了AI的执行能力。

Transformer模型首次出现在2017年谷歌发表的一篇研究论文当中,其中提出一种新的神经网络架构类型。Transformer还结合了自注意机制,让模型能够专注于输入中的特定部分,借此做出更准确的预测。

正是所谓自注意机制,将transformer与其他编码器-解码器架构模型区分开来。事实证明,这种机制在自然语言处理中特别有用,能让模型掌握句子中各单词之间的关系,并识别出相距较远的上下文关联。Transformer能根据与任务之间的相关性,为序列中的各个元素分配权重。如此一来,模型就能优先考虑其中最重要的部分,从而产生更多的上下文认知和明智的预测/决策。自注意机制的集成,极大改善了AI模型在自然语言处理领域的表现。

根据Das博士的介绍,近年来RNN已经不再是自然语言处理领域的首选架构。这是因为RNN往往难以训练,而且可能出现梯度消失问题,这就让对语言数据中相距较远的上下文间的关联学习变得极具挑战。相比之下,transformer已被证明能更有效地在各类自然语言处理任务上,带来远超同侪的先进性能。

释放基础模型的力量

凭借大规模数据加自监督技术训练出的模型,能够产生不特定于任何既有任务的通用表示。这些表示能够在其他应用场景下直接使用,无需再做进一步微调。

这些模型被称为“基础模型”,此术语最早由斯坦福大学在2021年的一篇研究论文中提出。当今众多基础模型都采用了transformer架构,并被证明在广泛的自然语言处理(NLP)任务中具备通用性。这是因为它们利用海量数据集完成了预训练,从而生成了强大的可部署机器学习模型。基础模型的出现,极大影响并改进了自然语言处理技术的整体面貌。

Das博士和IBM研究团队,也参与了大量涉及基础模型和生成式AI的研究工作。

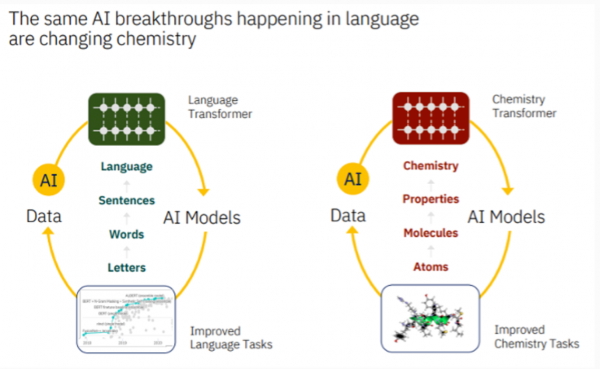

上图所示为以文本作为输入数据,使用基础模型面向不同领域构建模型。其可能使用,也可能不使用transformer架构。图左所示为大语言模型,它能逐步将字母映射至单词、句子乃至最终的语言。

图右所示为化学transformer模型,它将原子与分子和化学结构联系起来。只要将生物或化学分子表示为文本,即可使用相同的概念来构建生物学或其他相关领域的基础模型。

需要注意的是,transformer架构能够适应多种领域,唯一的要求就是输入数据必须能够以文本形式表达。这种良好的功能泛用性,使得transformer架构成为多个领域创建机器学习模型的宝贵工具。

借助生成式AI突破创造力的边界

生成式模型能够在各种应用场景下创造出新的、独一无二的图像/音频/文本。这些模型还让AI系统得以高效处理复杂数据,在广泛的应用场景中为AI技术的落地开辟出新的可能性。

基础模型同样可以创建出生成式模型,因为后者的基本原理同样是处理大量数据并从中学习。通过调整模型参数以专注于特定任务,例如生成图像或文本,面向不同领域的全新生成式AI模型即可顺利诞出。

例如,如果我们的目标是开发一套绘画创作型生成式AI模型,则首先可以通过大量艺术图像预训练一套基础模型。在训练成功之后,它就能用于生成新的原创艺术作品。上图所示,为用户给出“人脸肖像”提示之后,由Dall.E2 AI程序生成的画作示例。

克服生成式AI中的小数据挑战

Das博士提到,“当我们第一次开始研究生成式AI时,突然想到如何从小规模数据中,学习任何特定领域或行业的应用知识。”

生成式AI模型往往需要大量数据才能准确学习和生成新的相似数据。在处理小数据集时,这类模型的性能和实用性往往会受到影响。Das博士很快意识到了这个挑战,并发现迁移学习和数据增强等技术有助于提高模型在这类情况下的性能。

尽管小数据集确实困扰着生成式AI模型的应用,但对于上图中的各个领域,企业其实已经掌握着大量未经标注的数据。这些数据完全可以训练出自定义基础模型,解决以往被认为无法解决的问题。这也跟IBM研究院专注于通过生成式AI探索AI新功能、突破AI科学边界的思路高度一致。

更广泛的生成式AI研究

IBM在图中所示的各个领域都做出了重大贡献。下面我们就简单选取其中几个方向。

使用生成式AI合成抑菌剂

AI有望彻底颠覆各个领域,并加速科学进步。例如,Das博士和她的研究团队利用AI开发创新型抑菌药物,借此对抗致命性耐药细菌。

抗击超级细菌

抗生素从1940年代起,被首次用于治疗严重感染。之后的几十年间,抗生素挽救了数百万人的生命并改变了现代医学的面貌。然而,根据疾控中心的估计,每年全球的非必要抗生素治疗多达4700万例。

抗生素的过度使用已经引发严重问题,导致大肠杆菌、葡萄球菌等常见细菌以及金黄色葡萄球菌(MRSA)等更罕见的危险细菌出现了广泛的耐药性。由耐药细菌引发的感染更难以治疗,而且可能导致败血症、器官功能障碍甚至是死亡等严重后果。

当传统抗生素无法有效杀死细菌时,对感染的治疗和控制将愈发艰难、甚至失去可能性。这些抗药细菌被称为“超级细菌”,可能迅速传播并引发严重感染,令医院等医疗机构成为交叉感染的重灾区。超级细菌也可能存在于环境、食物和其他物体表面,或是在人与人间直接传播。

面对这个威胁全球生命安全的重大问题,面对这个每年在世界范围内造成70万死亡的严峻挑战,我们必须有所行动。到2050年,由超级细菌引发的死亡数字预计将增加到1000万。

细菌如何战胜抗生素

细菌和病毒能够激活自己的先天防御策略,通过使抗生素无效化完成向超级细菌的蜕变。这些防御机制往往能令细菌逃脱或抵消原本对其致命的物理、化学或生物过程,包括产生使抗生素失活的酶、改变细菌细胞膜、使生物体对药物的反应降低,或者从其他天然能够抵抗抗生素的细菌处获取遗传信息。

使用AI简化药物研发

用传统方法开发出新的抗菌药物是个漫长且昂贵的过程,往往需要耗时多年、投入大量资金。然而,AI的最新发展正在彻底改变药物的研究和发现过程。

通过利用AI对众多可能的候选药物进行生成与评估,研究人员能够快速查明最有希望的选择,将宝贵精力集中在高价值目标身上。这将简化药物开发过程,降低相应的时间和成本,以远超以往的速度推出更有效的抗菌药物。

研究团队提出的AI驱动方法能够加速抗菌药物设计,将整个周期控制在48天之内:IBM研究院,《使用可控深度生成模型与分子动力学加速抗菌药发现》。《自然生物医学》,2021年3月。

在Das博士及其团队的协同努力下,有望解决细菌耐药问题的创新解决方案正逐步成型。这项研究利用AI合成并评估了20种独特的抗菌肽设计,最终入选的这些“种子选手”来自9万个序列库。

其中使用的AI模型是专为抗药细菌这类用例所设计,结合了广谱功效和低毒控制等要求,同时强调减缓耐药性。这种方法带来的解决方案不仅有助于对抗耐药细菌,同时也将最大限度降低有害副作用,并防止目标产生更进一步的耐药性。

该团队针对各种革兰氏阴性与阳性细菌进行了设计测试,最终确定了6种成功的候选药物,并通过小鼠模型和试管完成了毒性筛查。

AI驱动下的全新可能性

Das博士对目前的成果深感欣慰,并表示其中体现了研究人员对下一代候选药物提出的种种特性期待。随附插图所示,为AI加速抗菌设计过程的规划和预期持续时长。整个过程只需一个半月即可完成,远快于传统上长达数年的漫长周期。

事实证明,利用AI加速抗菌药物研发足以改变游戏规则,大大降低研发周期和经费投入。另外,AI模型也能帮助研究人员释放精力,专注于研究最有希望的线索。最后,生成式AI还能帮助科学家设计出继承现有药物优势,同时功能更独特、功效更出色的创新化合物。

IBM的研究人员正利用生成式AI简化新型抗菌药物的开发,并在AI的帮助下创建出MolFormer和MolGPT等高价值工具。这些工具可用于预测化学分子的特性,为药物发现、材料设计等各类应用领域提供助力。

总结

如今,生成式AI已经在音乐、绘画、医疗保健和制药等各个领域引发关注,成为AI技术近期最激动人心的进步之一。尽管仍存在局限和挑战,但AI确实展现出颠覆各个领域的巨大潜力。

它能够迅速创造并测试出针对耐药细菌和其他病原体的宝贵药物,挽救更多病患于水火。

随着近期OpenAI GPT-3测试的执以及谷歌和微软的相继跟进,新一年内不仅AI产品将全面爆发,又一轮突破也可能就此出现。融入市场的有意义AI成果,整个人类的前途就越是焕发光彩。

尾注:

- 有人可能会质疑,本文并未提到AI在人脸识别方面的应用。请注意,人脸识别技术跟GPT模型属于功能和实现方法都全然有别的独立AI技术。IBM曾是人脸识别领域的领导者,但考虑到由此引发的政治和隐私等问题,因此决定不再继续探索这方面课题。但是,IBM仍然各级参与其他AI模式,例如语言处理、图像识别、图形分析、语音识别以及多模AI应用的各种组合。

- 这里要具体介绍一下GPT-3发布后的市场反应。就目前的情况看,微软的准备明确更为充分,而谷歌似乎被打了个措手不及。微软已经规划出如何将相关成果集成到运营体系当中,所以有望在市场上反超。之前两家公司的搜索收入差距巨大,微软2022年搜索收入总计220亿美元,而谷歌去年单第四季度的收入就高达590亿美元。考虑到GPT模型强大的搜索功能,令谷歌的总收入直降三分之一也并非没有可能。

- DALL.E2是一种前沿深度学习模型,能够根据自然语言输入生成数字图像,以OpenAI GPT-3的一个版本为基础。

好文章,需要你的鼓励

CES上杨元庆首谈AGI,碾压人类的叙事不会让AI更聪明

很多人担心被AI取代,陷入无意义感。按照杨元庆的思路,其实无论是模型的打造者,还是模型的使用者,都不该把AI放在人的对立面。

MIT递归语言模型:突破AI上下文限制的新方法

MIT研究团队提出递归语言模型(RLM),通过将长文本存储在外部编程环境中,让AI能够编写代码来探索和分解文本,并递归调用自身处理子任务。该方法成功处理了比传统模型大两个数量级的文本长度,在多项长文本任务上显著优于现有方法,同时保持了相当的成本效率,为AI处理超长文本提供了全新解决方案。

Gmail新增Gemini驱动AI功能,智能优先级和摘要来袭

谷歌宣布对Gmail进行重大升级,全面集成Gemini AI功能,将其转变为"个人主动式收件箱助手"。新功能包括AI收件箱视图,可按优先级自动分组邮件;"帮我快速了解"功能提供邮件活动摘要;扩展"帮我写邮件"工具至所有用户;支持复杂问题查询如"我的航班何时降落"。部分功能免费提供,高级功能需付费订阅。谷歌强调用户数据安全,邮件内容不会用于训练公共AI模型。

华为研究团队突破代码修复瓶颈,8B模型击败32B巨型对手!

华为研究团队推出SWE-Lego框架,通过混合数据集、改进监督学习和测试时扩展三大创新,让8B参数AI模型在代码自动修复任务上击败32B对手。该系统在SWE-bench Verified测试中达到42.2%成功率,加上扩展技术后提升至49.6%,证明了精巧方法设计胜过简单规模扩展的技术理念。

联想集团混合式AI实践获权威肯定,CES期间获评“全球科技引领企业”

CES上杨元庆首谈AGI,碾压人类的叙事不会让AI更聪明

CES 2026 | 重大更新:NVIDIA DGX Spark开启“云边端”模式

Gmail新增Gemini驱动AI功能,智能优先级和摘要来袭

研究发现商业AI模型可完整还原《哈利·波特》原著内容

Razer在2026年CES展会推出全息AI伴侣项目

CES 2026:英伟达新架构亮相,AMD发布新芯片,Razer推出AI奇异产品

通过舞蹈认识LimX Dynamics的人形机器人Oli

谷歌为Gmail搜索引入AI概览功能并推出实验性AI智能收件箱

DuRoBo Krono:搭载AI助手的智能手机尺寸电子阅读器

OpenAI推出ChatGPT Health医疗问答功能

Anthropic寻求3500亿美元估值融资100亿美元