弗劳恩霍夫研究院引领机器人技术的未来发展

该德国研究小组的O3dyn平台使用NVIDIA的模拟技术来创造用于制造业的自主移动机器人。

Joseph Fraunhofer是19世纪的光学研究领域先驱者,他将科学研究与工业应用结合在一起。今天,欧洲最大的研发机构——德国的弗劳恩霍夫协会——正将目光投向从 AI 到网络安全再到医学等关键技术的应用研究。

该学会旗下的弗劳恩霍夫物流研究院(Fraunhofer IML)希望推动物流和机器人技术的发展。这支德国研究团队正在使用NVIDIA Isaac Sim,通过模拟来推动机器人设计方面的进展。

与宝马、亚马逊和西门子等众多公司一样,弗劳恩霍夫物流研究院同样依赖于NVIDIA Omniverse。该机构正在利用该软件推动物流实践和制造方面的应用研究。

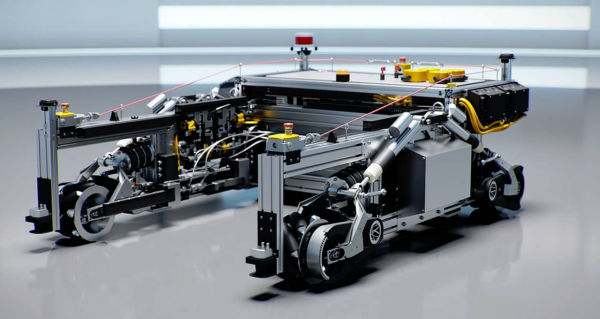

弗劳恩霍夫的最新创新成果O3dyn,正使用NVIDIA的模拟和机器人技术来创造一个室内-室外自主移动机器人(AMR)。

其目标是实现从自动导引车转向快速自主移动机器人的飞跃,而后者尚未在市场上出现。

这一自动化水平的进步有望大幅提升物流速度。

弗劳恩霍夫物流研究院的机器人和AI研究员Julian Eber表示:“我们正在研究,如何在物流场景中尽可能地保证机器人的移动既快速又安全。”

从MP3文件格式到自主移动机器人

弗劳恩霍夫物流研究院的母机构位于靠近德国版图中央的多特蒙德,拥有超过3万名员工并且参与了数百个研究项目。该机构在1990年代负责开发MP3文件格式,并引发了数字音乐革命。

为了让自动导引车同当时的光盘一样发展,Fraunhofer在2013年推出了一款开创性的机器人。现在这款机器人已被宝马公司在其装配厂和其他地方广泛使用。

这款名为STR的机器人已成为工业制造的“主力军”。它被用于移动生产线上的货物搬运。弗劳恩霍夫物流研究院的AI研究工作推动了STR和该机器人平台其他层面的更新,比如O3dyn。

弗劳恩霍夫物流研究院的目标是创造出最先进的自主移动机器人。O3dyn依靠NVIDIA Jetson边缘AI和机器人平台上众多的摄像头和传感器输入来帮助导航。

这台机器人具有更高的速度和敏捷性,它能够以每小时30英里的速度前进并配有AI辅助车轮,可以朝任何方向移动,即便在狭小的空间也能游刃有余。

弗劳恩霍夫物流研究院的AI和自主系统负责人Sören Kerner表示:“全向移动是这款机器人所独有的能力,据我们所知,目前市场上没有这样的机器人。”

弗劳恩霍夫物流研究院在NVIDIA GTC大会上介绍了这款托盘移动机器人的最新开发情况。

从模拟到现实

弗劳恩霍夫物流研究院在其最新研究中使用了Isaac Sim,致力于通过缩小模拟与现实之间的差距,在模拟中开发和验证这些自主移动机器人。研究人员依靠Isaac Sim对这款高度自主化的移动机器人进行虚拟开发,在逼真且物理精确的3D世界中锻炼机器人。

这使该研究院能够将机器人的5400多个部件从计算机辅助设计软件中导入虚拟环境,然后使用Omniverse PhysX为它们提供物理上准确的规格。

其结果是,该虚拟机器人版本在模拟中可以像现实世界的物理机器人一样迅速移动。弗劳恩霍夫物流研究院充分利用虚拟环境来加快开发速度、安全地提高其在现实世界部署的准确性并更快地扩大规模。

弗劳恩霍夫物流研究院所提出的“基于模拟的AI”的概念指的是尽量缩小模拟与现实之间的差距,使模拟成为机器人的数字现实。

为了更快取得成果,该研究院正在以开源形式发布这个自主移动机器人模拟模型,以便开发者进行改进。

Kerner表示:“这对物流行业的未来发展十分重要。我们希望能够有尽可能多的人在模拟环境中研究此类移动机器人的定位、导航和AI。”

来源:业界供稿

好文章,需要你的鼓励

CES上杨元庆首谈AGI,碾压人类的叙事不会让AI更聪明

很多人担心被AI取代,陷入无意义感。按照杨元庆的思路,其实无论是模型的打造者,还是模型的使用者,都不该把AI放在人的对立面。

MIT递归语言模型:突破AI上下文限制的新方法

MIT研究团队提出递归语言模型(RLM),通过将长文本存储在外部编程环境中,让AI能够编写代码来探索和分解文本,并递归调用自身处理子任务。该方法成功处理了比传统模型大两个数量级的文本长度,在多项长文本任务上显著优于现有方法,同时保持了相当的成本效率,为AI处理超长文本提供了全新解决方案。

Gmail新增Gemini驱动AI功能,智能优先级和摘要来袭

谷歌宣布对Gmail进行重大升级,全面集成Gemini AI功能,将其转变为"个人主动式收件箱助手"。新功能包括AI收件箱视图,可按优先级自动分组邮件;"帮我快速了解"功能提供邮件活动摘要;扩展"帮我写邮件"工具至所有用户;支持复杂问题查询如"我的航班何时降落"。部分功能免费提供,高级功能需付费订阅。谷歌强调用户数据安全,邮件内容不会用于训练公共AI模型。

华为研究团队突破代码修复瓶颈,8B模型击败32B巨型对手!

华为研究团队推出SWE-Lego框架,通过混合数据集、改进监督学习和测试时扩展三大创新,让8B参数AI模型在代码自动修复任务上击败32B对手。该系统在SWE-bench Verified测试中达到42.2%成功率,加上扩展技术后提升至49.6%,证明了精巧方法设计胜过简单规模扩展的技术理念。

联想集团混合式AI实践获权威肯定,CES期间获评“全球科技引领企业”

CES上杨元庆首谈AGI,碾压人类的叙事不会让AI更聪明

CES 2026 | 重大更新:NVIDIA DGX Spark开启“云边端”模式

Gmail新增Gemini驱动AI功能,智能优先级和摘要来袭

研究发现商业AI模型可完整还原《哈利·波特》原著内容

Razer在2026年CES展会推出全息AI伴侣项目

CES 2026:英伟达新架构亮相,AMD发布新芯片,Razer推出AI奇异产品

通过舞蹈认识LimX Dynamics的人形机器人Oli

谷歌为Gmail搜索引入AI概览功能并推出实验性AI智能收件箱

DuRoBo Krono:搭载AI助手的智能手机尺寸电子阅读器

OpenAI推出ChatGPT Health医疗问答功能

Anthropic寻求3500亿美元估值融资100亿美元