AI训练性能超越GPU Habana Gaudi2在MLPerf测试中表现出色 原创

目前MLPerf是AI行业唯一可靠的基准测试,MLPerf社区旨在设计公平且极具实际价值的基准测试,以公平地测量机器学习解决方案的准确度、速度和效率。

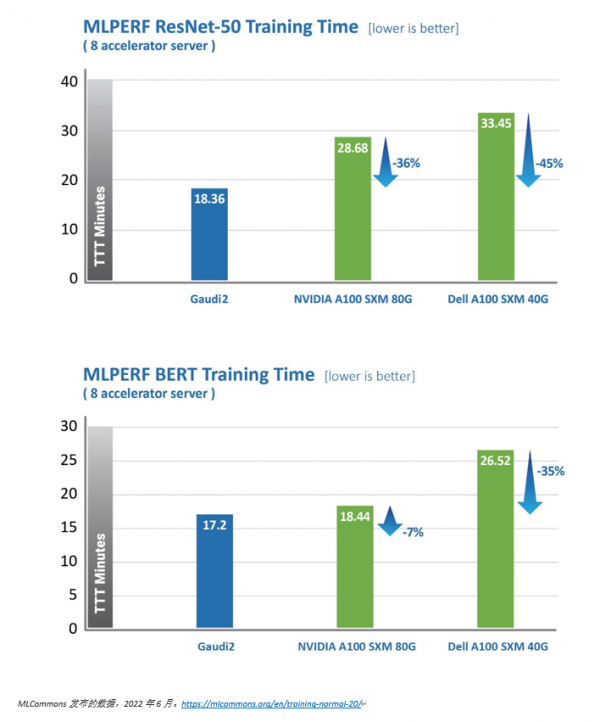

在最新的MLPerf训练2.0版本中,英特尔公司旗下Habana Labs的Habana Gaudi2处理器在视觉(ResNet-50)和语言(BERT)模型缩短训练时间(TTT)方面相较第一代Gaudi有了显著提升。Habana Labs于2022年5月提交的Gaudi2处理器在视觉和语言模型训练时间上已超越英伟达A100-80G的MLPerf测试结果。

其中,针对视觉模型ResNet-50,Gaudi2处理器的TTT结果相较英伟达A100-80GB缩短了36%,相较戴尔提交的同样针对ResNet-50和BERT模型、采用8个加速器的A100-40GB服务器,Gaudi2的TTT测试结果则缩短了45%。

其实早在5月份举行的英特尔On产业创新峰会(Intel Vision)上,Habana就展示了Gaudi2在运行ResNet-50(v1.1)的计算机视觉以及BERT Phase-1和Phase-2的自然语言处理工作时的训练性能,几乎是英伟达A100-80GB处理器的两倍。

基于与第一代Gaudi相同的体系架构,Habana Gaudi2处理器大幅提高了训练性能。客户在云端运行Amazon EC2 DL1实例以及本地运行Supermicro Gaudi训练服务器时,其性价比比现有GPU解决方案提升了40%。

相比于第一代Gaudi处理器,Gaudi2在ResNet-50模型的训练吞吐量提高了3倍,BERT模型的训练吞吐量提高了4.7倍。这些归因于制程工艺从16纳米提升至7纳米、Tensor处理器内核数量增加了三倍、增加GEMM引擎算力、封装的高带宽存储容量提升了三倍、SRAM带宽提升以及容量增加一倍。对于视觉处理模型的训练,Gaudi2处理器集成了媒体处理引擎,能够独立完成包括AI训练所需的数据增强和压缩图像的预处理。

除了Gaudi2在MLPerf测试中的卓越表现,第一代Gaudi在128个加速器和256个加速器的ResNet基准测试中展现了强大的性能和令人印象深刻的近线性扩展,支持客户高效系统扩展。

为提高模型的准确性和实时性,客户需要更频繁地进行训练。根据IDC的数据,在2020年接受调查的机器学习从业者中,有74%的人对其模型进行过5-10次迭代训练,超过50%需要每周或更频繁地重建模型, 26%的人则每天甚至每小时会重建模型。56% 的受访者认为培训成本是阻碍其组织利用人工智能解决问题,创新和增强终端客户体验的首要因素。基于此,第一代 Gaudi和Gaudi2在内的Gaudi平台解决方案应运而生。

Habana与Supermicro计划在2022年第三季度推出Supermicro Gaudi2训练服务器。同时,Habana亦与DDN联合打造采用Supermicro服务器和搭配DDN AI400X2存储的AI解决方案。

为支持客户将当前基于GPU的模型业务和系统迁移到Gaudi2服务器,并帮助保护软件开发投入,Habana SynapseAI软件栈针对深度学习业务进行优化,旨在简化模型的开发和迁移。SynapseAI集成了TensorFlow和PyTorch框架,并提供30多个流行的计算机视觉和自然语言参考模型,能够满足深度学习开发者的多样化需求。

好文章,需要你的鼓励

非洲电信基础设施巨头数字化转型实战访谈

Helios Towers供应链总监Dawn McCarroll在采访中分享了公司的数字化转型经验。作为一家在非洲和中东地区运营近15000个移动通信塔站的公司,Helios正通过SAP S/4Hana系统升级、AI技术应用和精益六西格玛方法论来优化供应链管理。McCarroll特别强调了公司Impact 2030战略中的数字包容性目标,计划在未来五年内培训60%的合作伙伴员工掌握精益六西格玛原则,并利用大数据和AI技术实现端到端的供应链集成。

德国机构首创免训练人脸质量评估技术:Vision Transformer也能当“质检员“

德国弗劳恩霍夫研究院提出ViTNT-FIQA人脸质量评估新方法,无需训练即可评估图像质量。该方法基于Vision Transformer层间特征稳定性原理,通过测量图像块在相邻层级间的变化幅度判断质量。在八个国际数据集上的实验显示其性能可媲美现有最先进方法,且计算效率更高,为人脸识别系统提供了即插即用的质量控制解决方案,有望广泛应用于安防监控和身份认证等领域。

n8n 供应链攻击利用社区节点窃取 OAuth 令牌

威胁行为者在npm注册表上传8个恶意包,伪装成n8n工作流自动化平台的集成组件来窃取开发者OAuth凭据。其中一个名为"n8n-nodes-hfgjf-irtuinvcm-lasdqewriit"的包模仿Google Ads集成,诱导用户在看似合法的表单中关联广告账户,然后将凭据传输到攻击者控制的服务器。这种攻击利用了工作流自动化平台作为集中凭据库的特点,能够获取多个服务的OAuth令牌和API密钥。

临床AI大模型的人格面具:布朗大学揭示医疗角色扮演的双刃剑效应

布朗大学联合图宾根大学的研究团队通过系统实验发现,AI医疗助手的角色设定会产生显著的情境依赖效应:医疗专业角色在急诊场景下表现卓越,准确率提升20%,但在普通医疗咨询中反而表现更差。研究揭示了AI角色扮演的"双刃剑"特性,强调需要根据具体应用场景精心设计AI身份,而非简单假设"更专业等于更安全",为AI医疗系统的安全部署提供了重要指导。