性能表现破纪录 NVIDIA AI平台继续引领MLPerf行业基准测试 原创

MLPerf是国际权威的AI性能基准评测,每年各有两次AI推理和AI训练测试,以对迅速增长的AI计算需求与性能进行及时的跟踪测评。

在最新的MLPerf训练2.0版本中,NVIDIA与16家合作伙伴提交了本轮结果,占了所有参赛生态伙伴的90%,并且继续提供了最佳的整体AI训练性能和提交了最多的测试项。

出色成绩来自持续创新

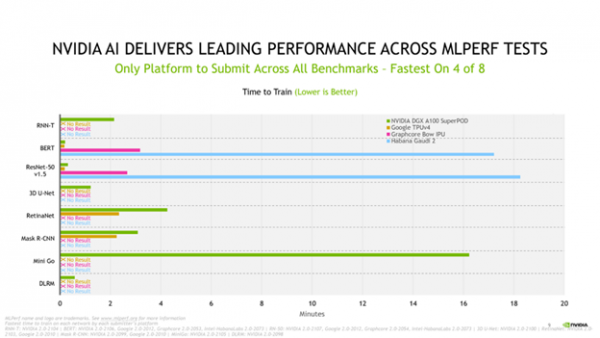

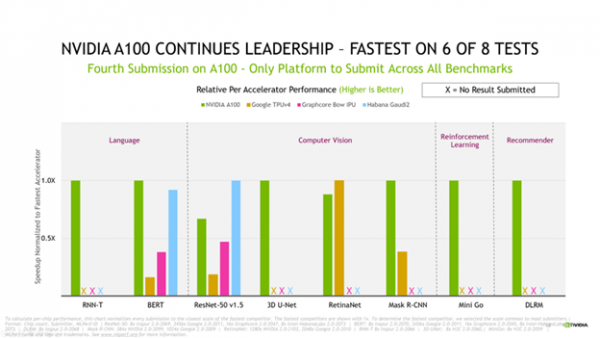

在连续第四次MLPerf训练提交结果中,基于NVIDIA Ampere架构的NVIDIA A100 Tensor Core GPU依然表现出色。NVIDIA A100还保持了单芯片性能上的领导地位,在八项测试中的六项测试中呈现了最快的速度。

同时,Selene在八项大规模工作负载测试的四项中获得“最快训练时间”。Selene是NVIDIA内部的一台AI超级计算机,它基于模块化的NVIDIA DGX SuperPOD,并由NVIDIA A100 GPU、软件堆栈和NVIDIA InfiniBand网络驱动。

从首次基于A100提交MLPerf基准测试以来的两年时间里,NVIDIA AI平台继续在MLPerf 2.0中提供最高的性能,仍是唯一能够提交所有基准测试的平台。

得益于跨GPU、软件和大规模改进的全栈式创新,NVIDIA AI平台在3年半时间里,在基准测试中实现了23倍的性能提升。

比如在提交结果中大量使用的CUDA Graphs,该软件可以最大限度地减少跨多个加速器上运行作业的启动开销。NVIDIA Magnum IO和SHARP将部分AI功能卸载到网络中,以获得更好的性能。

据了解,NVIDIA所使用的所有软件均可从MLPerf资源库中获取。NVIDIA还不断地将这些优化集成到NVIDIA的GPU应用软件中心——NGC上提供的容器中,并通过NVIDIA AI Enterprise提供完全由NVIDIA支持,并经过优化的软件。

通吃各种AI模型让AI快速落地

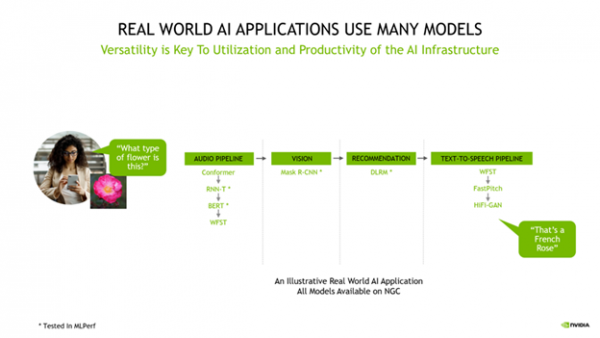

MLPerf训练基准测试代表了流行的AI用例,包括语音识别、自然语言处理、推荐系统、目标检测、图像分类等。

NVIDIA AI仍是唯一能够运行MLPerf行业基准测试中所有测试的平台,A100 GPU自发布以来连续两年一直保持着获胜次数最多的纪录。

NVIDIA AI平台覆盖了其中的所有八项基准测试,突显了其领先的通用性,保护用户已有的AI平台投资。

对于用户而言,人工智能应用需要多种类型的AI模型按顺序工作,用户需要能够快速且灵活地设计、训练、部署和优化这些模型。NVIDIA AI平台的通用性让其在各种AI模型中表现出色,可以帮助用户构建相关应用。

通常AI研究人员需要快速测试新的想法,这需要通用性来训练任何模型,以及大规模训练模型所能提供的速度。

凭借NVIDIA AI,客户可以在整个AI流程中使用相同的基础设施,重新利用它来适配数据准备、训练和推理之间的不同需求,这极大地提高了利用率,实现了非常高的投资回报率。

NVIDIA AI兼容并适用于每个模型、可以扩展到任何规模,并加速从数据准备到训练再到推理的端到端AI流程,能够实现最高的单位成本生产力。

今天的结果再次证明了NVIDIA在迄今为止所有MLPerf训练、推理和HPC评测中所展示的丰富而深厚的AI专业性。

结语

MLPerf行业基准测试是企业进行AI采购的重要参考,而NVIDIA AI平台的上佳表现将会增强已有用户的信心,并吸引更多用户部署。

我们看到这次参与测试还是基于 NVIDIA Ampere架构的A100,要知道NVIDIA于3月发布了NVIDIA Hopper架构,这样在未来的MLPerf基准测评中NVIDIA的表现将会很值得期待。

好文章,需要你的鼓励

OpenAI收购高管教练AI工具Convogo团队

OpenAI宣布收购商业软件平台Convogo的团队,该平台帮助高管教练、顾问和人力资源团队自动化领导力评估和反馈报告。OpenAI仅收购团队而非技术,三位联合创始人将加入OpenAI从事AI云服务工作。Convogo产品将停止运营。这是OpenAI一年内的第九次收购,主要目的是获取人才和能力。

AWS推出AI图像编辑新突破:用说话就能精准移动图片中的物体!

这项由香港中文大学和AWS团队联合开发的研究推出了TALK2MOVE系统,实现了用自然语言精准操作图片中物体的位置、角度和大小。该系统采用强化学习训练方式,通过空间感知奖励机制和智能步骤采样技术,在移动、旋转、缩放三类操作上的准确率显著超越现有方法,同时大幅降低了对昂贵训练数据的依赖,为AI图像编辑领域带来重要突破。

抛弃传统的市场推广手册,迎接AI时代的新策略

在Build Mode节目中,GTMfund合伙人Paul Irving分享了AI时代初创企业市场推广的实用建议。他强调当技术优势变得短暂时,分销渠道成为最后的护城河,每家公司都需要针对特定客户群体制定独特的市场策略。Irving建议专注于一到两个推广渠道,利用AI实现精准客户触达,并通过建立真实关系网络获得成功。

斯坦福大学等联合发布:AI助手在企业政策执行上竟然“偏科“得如此严重

斯坦福大学等知名机构联合研究发现,企业AI助手在执行组织政策时存在严重"偏科"问题:处理允许请求时成功率超95%,但拒绝违规请求时仅13-40%。研究团队开发的COMPASS评估框架通过8个行业5920个测试问题,揭示了AI助手普遍缺乏"拒绝技能"的问题,并提出了针对性训练解决方案。

OpenAI推出ChatGPT Health医疗问答功能

OpenAI收购高管教练AI工具Convogo团队

抛弃传统的市场推广手册,迎接AI时代的新策略

谷歌将Gemini AI功能推送至Gmail,用户可选择关闭

AI竞赛点燃欧洲数据中心债券市场热潮

IBM API Connect关键漏洞可导致身份验证绕过

CES 2026智能戒指新品:Pebble Index 01记录想法不追踪健康

AI聊天机器人让人上瘾的隐秘手段揭秘

AI将在2026年重塑网络安全策略

CES主题演讲分析:智能体AI如何为现实世界影响奠定基础

Snowflake收购Observe以增强其可观测性能力

三星Galaxy Tab A9 Plus限时降价70美元