实战攻略:企业如何一步步建立自己的数字孪生

近几周,SmartCow AI模拟团队通过真实案例探索出了一套数字孪生路径,希望帮助企业了解如何借助虚拟环境设计出更好、更智能、更高效的真实空间。

这一切,都将在数字孪生这一前沿技术的支持下逐步完成。作为一种大规模模拟系统,数字孪生能够在虚拟环境中建立起与现实物体或流程精确对应的副本。

数字孪生的概念最初诞生于1991年,出自David Gelernter的《镜像世界》,他在其中写道:

“镜像世界是一片信息的海洋,由许多数据流共同构成。一部分数据流代表着在计算机终端上手动输入的数据,它们徐徐流动;也有部分数据流源自数据收集与监控设备的自动获取,例如医院重症监护室仪器、天气监控设备、安装在道路上的交通流量传感器等。”

到世纪之交,Michael Grieves博士开始将数字孪生的概念引入软件和现实生活。到2010年之后,NASA的John Vickers正式提出“数字孪生”一词。如今,数字孪生系统如雨后春笋般涌现,负责监控各类数据结构、从真实场景中采集信息,并据此提炼出有助于特定目标的宝贵知识。

数字孪生强在哪里?

SmartCow AI模拟团队发现,数字孪生的最大优势之一就是良好的通用性。如果能够在3D环境中重现现实空间,自然也可以灵活移动其中的对象、或者调整具体条件,完全不必担心对现实世界中的对象造成影响。

这就让大规模流程观察与分析成为可能,同时也把测试成本控制在极低的水平。而且既然是出现了意外状况、或者测试未能按计划正常进行,也可以随时重置数字孪生副本。

该团队一直致力于打造自己的数字孪生环境,希望探索智慧城市与智能空间应用。在这套系统中,SmartCow AI模拟团队打算引入数据可视化并据此开展研究,并把收集到的数据反馈回现实世界。最后用这些数据来模拟现有数据中不存在、但在现实场景下可能发生的各类情况。

自己动手,完成数字化建模

数字孪生就是一套基于真实物理空间的3D系统,所以该团队打算以比利时安特卫普的一个十字路口为起点,把这里的建筑、植物、路灯和交通系统通通搬进虚拟世界。

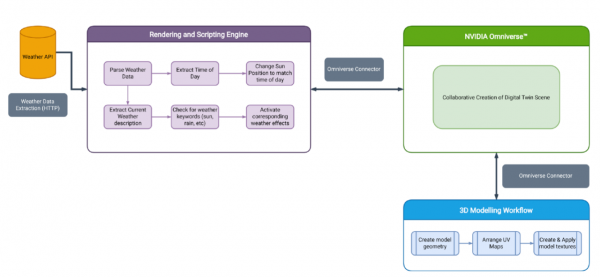

数字孪生中的所有场景资产都由3D建模软件进行创建。之后,使用渲染引擎进行可视化。为了降低开发难度,团队选择了英伟达Omniverse平台作为主渲染引擎,能够提供极强的GPU实时渲染能力。下面是通过构建管道开发出的,能支持实时天气与昼夜循环的数字孪生模型:

SmartCow小教程:如何在数字孪生中建立天气系统

先从3D建模阶段起步,这是复杂度最高、也最耗时的过程。场景中的每个项目都需要用大量多边形进行建模,应用正确的纹理贴图和/或材质,并与周边对象保持统一。其中的大部分资产都由专职3D艺术家创建而成。

在制造这些资产时,SmartCow采取了标准化的建模流程:先在3D空间中创建出由平面四边形构成的资产几何图形,相当于绘画时先确定大小关系和场景结构。其间,还特意选择了易于拆分成三角形的几何图形,这是因为三角形在渲染后更能维持目标物体的准确整体形状。之后SmartCow又定义了UV贴图,并为每个UV贴图应用相应的纹理。虚拟场景中的数字副本必须跟现实对应物1:1还原,所以要特别注意对象间的空间关系。一旦比例错误,场景的沉浸感和视觉保真度都会大打折扣。

几何图形的细节水平也非常重要。高保真几何图形视觉效果更好,沉浸感也更出色,但运行速度较慢且会占用大量存储空间。

超现实风3D圆桌。

下一步就是在模拟/渲染程序中实现所有3D数据,之后将手绘的3D纹理配置到资产的材质当中。接下来,把各个对象放置在与现实场景相对应的正确位置上。空场景创作完成,舞台就算搭建完成了,然后就是引入数据流和模拟功能。

所有资产集合于一处,数字孪生正式启动!

在功能方面,SmartCow构建的环境已经能够支持多种实时天气效果,包括但不限于:

- 晴天 ?

- 雨天 ?

- 雪天 ?

- 雾天 ?

- 多云 ?

为了实现这么多种天气变化,SmartCow把每种天气条件定义成相应的配置文件,其中分别包含模拟天气(例如下雪或下雨)的粒子效果和光照条件。如此一来,数字孪生环境就能在下雨时通过正确的光线组合提供更柔和昏暗的光照,并在晴天时呈现出更加明亮饱和的视觉效果。

为了更进一步,SmartCow还决定从最近发布的CityStation产品中获取实时天气数据。通过团队编写的自定义连接器,CityStation中的数据被摄取并解析至数字孪生环境中,进而根据条件激活正确的天气配置文件。这样外面的天气与孪生环境里就完全一样了。

也正是因为有了这些实时数据,SmartCow的视觉保真度提升才有实际意义。作为环境增强的另一套解决方案,SmartCow用类似于天气变化的设置实现了昼夜循环,包括对应不同日期下太阳和月亮的轮廓和位置。根据具体时间,标准太阳高度公式将始终呈现出正确的日月位置,甚至连日出日落的视觉效果也都能呈现到位。

后续还可以添加更多功能,例如车辆交通系统、行人交通系统、行人计数系统等等。

好文章,需要你的鼓励

无需Linux即可运行自由开源软件

本文介绍了如何在Windows和macOS等主流操作系统上使用免费开源软件,无需更换操作系统即可摆脱付费订阅。文章推荐了Ninite等工具来安装免费软件,并详细介绍了Firefox、Thunderbird、LibreOffice、VLC等优秀的开源替代方案。作者强调虽然学习新工具需要时间投入,但从长远来看,使用不依赖订阅模式的替代工具将带来巨大回报。

港大团队让AI学会动态空间推理:像人类一样理解物体在三维空间中的运动变化

香港大学和腾讯联合研究团队开发DSR Suite框架,首次让AI掌握动态空间推理能力。该技术通过自动化流水线从真实世界视频提取三维几何信息,构建了包含5万个训练样本的DSR-Train数据集和1484个评估样本的DSR-Bench基准。核心创新GSM几何选择模块能根据问题精准提取相关几何知识,避免信息过载。实验显示新方法在动态空间推理任务上达到58.9%准确率,超越最强对比模型20个百分点,为机器人导航、自动驾驶等应用奠定重要基础。

超越 SEO:AI 引擎优化如何改变在线可见性格局

随着生成式人工智能系统提供直接答案而非链接列表,传统搜索引擎优化正面临重大变革。谷歌AI概述功能已覆盖约30%的美国搜索,导致网站点击率大幅下降。专家预测,到2030年AI将占B2B软件研究的70%以上。AI引擎更重视结构化数据、实体识别和权威性,而非传统的关键词和反向链接。营销人员需要采用实体权威工程等新策略来优化AI可见性。

南京大学团队推出T2AV-Compass评测基准:让AI生成视频与音频完美匹配的“统一考场“

南京大学团队发布T2AV-Compass,这是全球首个文本到音视频生成模型的综合评测基准。研究构建了500个复杂测试场景和双重评估体系,发现当前AI模型存在"音频真实感瓶颈"—视频质量优秀但音频效果较差。该基准为AI视频生成领域提供统一评估标准,指出了未来技术改进的关键方向。