引领人工智能发展:英特尔的独家方法论

英特尔是领先的且更有能力引领人工智能应用时代的公司

内容摘要

- 人工智能是增长最快的计算工作负载,其复杂性也在不断增长,对计算、功率和带宽的要求也越来越高。

- 我们处于一个转折点:人工智能正在逐渐突破数据中心,随着人工智能应用时代的到来,人工智能的未来更在数据中心之外。

- 英特尔以独家方法论推动人工智能从云到端再到边缘的发展。

- 英特尔的人工智能策略是通过降低用户的进入门槛加速人工智能普及。基于英特尔®至强®处理器和英特尔强大的产品组合及开放的软件生态系统,我们不仅能够引领人工智能的发展,也可以深入影响更广泛的行业趋势,让每个人都可以更便捷地使用人工智能。

Sandra Rivera

英特尔公司执行副总裁兼数据中心与人工智能事业部总经理

人工智能(AI)的核心是使机器识别模式并据此做出准确预测的能力。而随着AI模型持续变得更加精妙和复杂,对更多计算、内存、带宽和功率的需求也与日俱增。

AI是增长最快的计算工作负载,也是英特尔认为将对世界产生变革性影响的四大超级技术力量之一。尽管它诞生于数据中心,但我相信AI的未来在数据中心之外。AI在客户端和边缘的应用时代已经来临,为了让AI从云端扩展到边缘,社区需要一种更加开放和整体的解决方案来加速并简化整个数据建模和部署管道。我们的策略是复制公司历史上为其他重大技术转型所采取的措施:向更多客户开放,加速AI的普及化并推动更大规模的应用。

在全球范围内,英特尔是为数不多的能够更好地引领世界进入AI下一个时代的公司。基于我们强大的生态系统和开放式软件,以及至关重要的CPU、GPU、ASIC等架构能够满足无数AI使用场景的特定需求,这将使我们能够引领市场发展并为无处不在的开放式AI打下坚实基础。

一系列具备AI特性的领先架构

提及AI,许多人立刻会联想到深度学习训练和显卡性能。由于训练往往是大规模并行的,因此显卡得到了很多关注,但这只是AI的一部分。大部分AI实践中的解决方案会包含经典机器学习算法和中低复杂度的深度学习模型的组合,而这些功能都已经被集成在至强等现代CPU内。

目前,AI数据流水线主要在至强处理器上运行。通过内置加速和优化软件,我们能够让至强处理器运行得更快。基于此,我们一方面通过Sapphire Rapids,将AI的总体性能比上一代产品提高最多30倍;同时,我们还通过将更多AI工作负载引入至强处理器以减少对独立加速器的需求,从而进一步提高至强处理器的产品竞争力。对于诸如至强等英特尔产品而言,AI功能和优化并不是一个新概念。因此,我们计划扩展这种方法,将AI融入我们交付到数据中心、客户端、边缘、显卡等诸多领域的每个产品中。

对于那些真正在GPU上表现最佳的深度学习训练,我们希望客户能够自由选择最适合其AI工作负载的计算。现阶段的GPU是专有且封闭的,但我们有一款针对特定领域的Habana Gaudi AI处理器,和一款专为高性能计算打造的Ponte Vecchio显卡,它们将基于开放的行业标准。我们对Gaudi目前取得的进展感到十分高兴,AWS在2021年第四季度宣布全面推出基于Habana Gaudi的DL1实例,其性价比较基于显卡的现有实例高40%,并在早期Gaudi使用测试中表现优异。

打造成熟的生态系统吸引更多客户

特定的模型、算法和要求会因使用场景和行业而变化。例如,一家自动驾驶汽车公司需要解决感知(使用物体检测、定位和分类)、高清地图和路线规划等问题,并采取需要适应动态环境的行动。此外,技术支持软件的聊天机器人也需要了解特定公司和行业的技术术语,才能准确地回答相关问题。同理,对AI软硬件需求也因客户、细分市场、工作负载和设计点而异。设备端、嵌入式和客户端AI系统需要在功耗和散热受限条件下实现低延迟推理。人们也越来越需要云中开发的AI具有边缘感知能力,以便云中开发的解决方案可以部署在边缘,反之亦然。

所有这些因素都在推动从数据中心到网络再到边缘的全面创新,并影响诸如高带宽和大容量内存、快速互连和智能软件在内的系统级硬件架构。

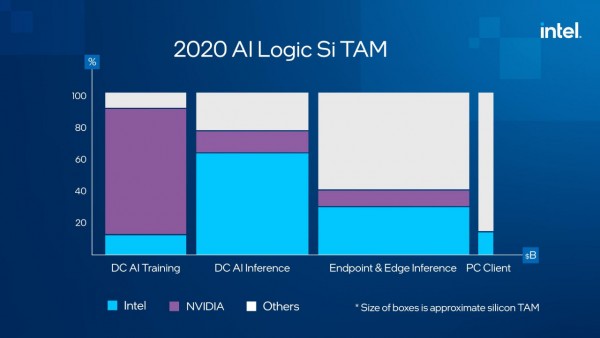

端到端AI流水线中最大的增长点在于模型部署和AI推理阶段。如今,超过70%的AI推理在至强处理器上运行,其中一个增长最快的AI推理使用场景是智能边缘,而至强已在此领域深耕多年。

在过去的八个月中,我一直在与主要客户保持密切沟通,以更深入了解他们的需求和工作负载。这些交流不仅让我们深入了解到如云服务供应商之类的有较强影响力客户的需求,也向我们展示了战略合作伙伴如何帮助我们了解我们自身产品组合所应用的关键领域。现阶段,有数以万计的云实例在英特尔处理器上运行,而且它的增长速度比任何其他架构都快。与此同时,针对x86架构编写的代码有数千亿行,整个行业也已经安装了数亿颗至强处理器。因此,英特尔具备得天独厚的优势,不仅可以通过行业标准横向推动行业发展,亦能在需求更加专业的自动化和医疗等领域纵向推动行业发展。

面向AI开发者的开放软件堆栈

硬件只是解决方案的一部分,因此我们在AI策略上始终秉持“软件优先”的理念。其中,“软件优先”包括安全的AI软件组件,即让用户能够利用至强处理器的独特软件和安全功能,如通过英特尔®软件防护扩展(英特尔® SGX)进行机密计算,保护使用中的关键数据和软件。英特尔®SGX是业界第一个也是部署最多的基于硬件的数据中心可信执行环境,在此基础之上,我们的至强产品路线图也涵盖更多机密计算技术,这也将夯实我们的技术领先性。

我们花费数年时间为CPU优化最流行的开源框架和函数库,而且我们拥有基于开放标准开发的最广泛的特定领域加速器组合,使代码更容易移植且避免被锁定。此外,为增强技术领先性并持续推动创新,我们持续深耕技术,希望能够打造开放式AI,以涵盖从云和数据中心到客户端、边缘和更多领域。

尽管在AI框架中默认启用英特尔优化对于推动大规模芯片应用至关重要,但我们仍然需要满足各类AI开发者的需求,如从事软件堆栈底部工作的框架开发者、在堆栈较高位置工作的低代码或无代码主题专家,以及部署、运行、训练和维护AI模型(MLOps)的所有工程和运营人员。尽管他们的角色迥然不同,但AI工作流程的每个阶段都有共同的目标,即以最低的成本和风险快速从概念扩展到现实世界,这也意味着他们需要选择以及基于易于部署和维护的通用框架的开放解决方案。

基于此,我们已经开发了BigDL和OpenVino™。其中,BigDL支持在现有大数据基础设施上进行大规模机器学习;而通过数百个提前训练的模型,OpenVino™可以加速并简化推理在许多不同硬件上的部署。通过一致的标准和API,为从事底层AI堆栈工作的开发者提供可组合或优化的构建块,以及为低代码开发者提供优化和产品化的工具和套件,英特尔助力AI开发者茁壮成长。我们持续深耕AI加速器和安全性,这将让我们能够使这些关键计算元素在所有客户、细分市场和产品中广泛存在。

英特尔推动AI Everywhere

现阶段AI已经在深刻变革各行各业,未来它也有望改善地球上每个人的生活,但前提是它能够被更容易地大规模部署。我们认为,降低AI的进入门槛需要正确的AI技术集合。经过实践,我们验证了一个成功的模式,以加速AI创新的下一个时代:通过开源工作帮助定义开发环境,我们将能够开发和影响客户的解决方案,从而影响整个行业。我们预测,到2026年,英特尔AI逻辑芯片的市场规模将超过400亿美元。我们正以强大的实力抓住这个机会,我对未来充满信心。

好文章,需要你的鼓励

据说算力高达1000 TOPS,华硕Ascent GX10深度评测——开箱

当超级计算机被压缩进一个比书本还小的盒子里,这画面有多炸裂?想象一下,你桌面上摆着的不是什么花瓶摆件,而是一台能跑200B参数AI推理的"超算怪兽"——这就是我们今天要聊的主角:华硕Ascent GX10。

Adobe与UCLA联手突破AI模型速度瓶颈:让图像生成快一倍的“稀疏化魔法“

Adobe研究院与UCLA合作开发的Sparse-LaViDa技术通过创新的"稀疏表示"方法,成功将AI图像生成速度提升一倍。该技术巧妙地让AI只处理必要的图像区域,使用特殊"寄存器令牌"管理其余部分,在文本到图像生成、图像编辑和数学推理等任务中实现显著加速,同时完全保持了输出质量。

不用再训练AI模型,香港科技大学团队发明“智能管家“,让AI一眼就知道该抓哪里用哪里

香港科技大学团队开发出A4-Agent智能系统,无需训练即可让AI理解物品的可操作性。该系统通过"想象-思考-定位"三步法模仿人类认知过程,在多个测试中超越了需要专门训练的传统方法。这项技术为智能机器人发展提供了新思路,使其能够像人类一样举一反三地处理未见过的新物品和任务。

据说算力高达1000 TOPS,华硕Ascent GX10深度评测——开箱

苹果发现:只需一个注意力层,就能让AI图像生成既快又好

YouTube推出基于Gemini 3的创作者游戏制作工具

英伟达是唯一能负担免费提供AI模型的厂商

OpenAI发布新旗舰图像生成AI模型GPT Image 1.5

脑启发算法可大幅降低AI能耗

Mac办公桌升级必备配件指南:提升工作效率的最佳选择

PTC Windchill+ 助力 HOLON研发全球首批符合汽车行业标准的 L4 级电动汽车

航旅行业的AI“乘法效应”:迈向指数级进化

OpenAI推出GPT Image 1.5模型加速图像生成竞争

Zoom推出AI Companion 3.0智能体工作流程

ChatGPT成为互联网最受阻止的爬虫机器人

最热门的 AI 模型:它们的功能和使用方法

这款古怪的 AI 智能手机可以创建你的数字分身

Faireez 获 750 万美元融资,为租赁市场提供 AI 驱动的酒店式管家服务

Broadcom 大获全胜:70% 大型 VMware 客户购买其最全面解决方案

Peer 获得1050万美元元宇宙引擎投资,推出3D个人星球功能

获 3000 万美元融资,Crogl 发布面向安全分析师的全新 AI "钢铁侠战衣"

Turing 获得 1.11 亿美元融资,估值达到 22 亿美元,为 OpenAI 等大语言模型公司提供关键代码支持

Tavus 推出系列 AI 模型,实现实时人脸交互技术突破

Welevel 获得 570 万美元融资,革新程序化游戏开发

AI 驱动的卓越运营:企业如何通过人人可及的流程智能提升成功