Meta打造全球最快AI超级计算机 助力元宇宙雄心壮志

Meta Platforms正在构建所谓全球最快的、专注于人工智能的超级计算机,以处理涉及自然语言处理和计算机视觉的新型高级工作负载。

今天该公司透露,这套名为AI Research SuperCluster(RSC)的超级计算机虽然尚未完成,但已经启动并运行,用于训练具有数十亿参数的大型AI模型。

Meta长期以来一直是人工智能研究领域一个雄心勃勃的参与者,其原因也随着这套最新的超级计算机问世而变得越来越明显。Meta认为,人工智能在所谓元宇宙的发展中,将发挥着重要作用。元宇宙是一种虚拟世界,Meta认为人们将越来越多地聚集在Meta进行社交、工作和娱乐。

Meta AI研究人员Kevin Lee和Shubho Sengupta在一篇博文中这样写道:“我们希望RSC能够帮助我们构建全新的AI系统,例如,可以为那些说不同语言的人们提供实时语音翻译,这样让他们可以在研究项目上无缝地展开协作,或者一起玩AR游戏。最终,RSC相关的工作成果将为下一代主流计算平台——元宇宙——的技术铺平道路,在元宇宙中,AI应用和产品将发挥重要作用。”

Meta研究人员解释说,最近Meta在“自我监督学习”领域取得了长足的进步,这项技术是指算法可通过大量未标记的示例中进行学习,此外,Meta还让AI可通过专注于某些特定领域的输入来实现更高效的推理。

Meta总结说,为了让自我监督式学习和基于转换器的模型发挥全部优点,就需要训练越来越复杂的、适应性更强的AI模型,而这就意味着要处理更多的数据。例如,要开发更先进的计算机视觉模型,需要以更高的数据采样率处理更大更长的视频。

同时,语音识别也需要面对有大量背景噪音、最具挑战性的场景,自然语言处理必须理解不同的语言、口音和方言,因此Meta需要一台比目前现有计算机更强大的超级计算机。

RSC的功能非常强大,在760个Nvidia DGX A100系统中配置了6080个Nvidia最新型A100 GPU,而且这些GPU组合成了DGX节点,节点采用Nvidia高性能Quantum 200 Gb/s InfiniBand实现网络互连。RSC还采用了Pure Storage FlashArrays提供的175 PB存储,以及来自Penguin Computing Altus系统的46 PB缓存存储。

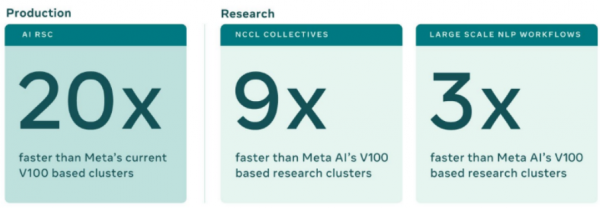

“与Meta传统生产型和研究型基础设施相比,RSC的早期基准测试表明,它运行计算机视觉工作流程的速度提高了20倍,运行Nvidia NCCL的速度提高9倍多,训练大规模NLP的模型快了3倍,这意味训练一个有数百亿参数的模型只需要3周时间,而之前需要9周,”Meta AI研究人员这样表示。

然而,Meta的目标是让RSC变得越来越强大,计划今年年中将实现连接16000个GPU。

除了专注于速度和功率之外,RSC还考虑到了安全性。Meta在人工智能领域的雄心壮志,需要能够使用来自自身生产系统的大量真实数据,所以需要非常小心谨慎地保护这些数据信息。

“RSC的设计从一开始就考虑到了隐私和安全性,因此Meta的研究人员可以使用经过加密的用户数据安全地训练模型,而且这些数据在训练完成之前都一直是加密的,”Lee和Sengupta这样写道。

这些保护措施包括确保RSC与公共互联网隔离,没有直接的入站或出站连接。同时,从Meta的存储系统到GPU的整个路径都是加密的,只有在数据被真正使用之前,才会被解密,不管是在GPU端点,还是内存中。

Constellation Research分析师Holger Mueller表示,主宰虚拟世界的竞赛正如火如荼地展开,AI将成为其中至关重要的一部分。

“毫无疑问,Meta作为对元宇宙抱有远大抱负的主要参与者之一,正在建造他们第一台用于研究目的的AI超级计算机。元宇宙仍处于起步阶段,需要进行大量研究才能真正起飞,因此Meta正在朝着实现这一目标迈出关键的第一步。”

Meta解释说,RSC现在已经启动并运行,很快就会变得越来越强大。今年Meta计划把RSC的GPU数量从6080个增加到16000个,整体AI训练性能提高到当前水平的2.5倍多。

Meta解释说:“我们预计,要让计算能力实现这种阶跃函数式的变化,不仅使我们能够为现有服务打造更准确的AI模型,而且还可以实现全新的用户体验,尤其是在元宇宙中。我们在自我监督式学习和使用RSC构建下一代AI基础设施方面的长期投资,将帮助我们打造基础技术为元界提供动力,并在更广泛的层面上推动AI社区的发展。”

来源:业界供稿

好文章,需要你的鼓励

超越能源使用:数据中心可持续运营策略

随着AI广泛应用推动数据中心建设热潮,运营商面临可持续发展挑战。2024年底美国已建成或批准1240个数据中心,能耗激增引发争议。除能源问题外,服务器和GPU更新换代产生的电子废物同样严重。通过采用模块化可修复系统、AI驱动资产跟踪、标准化数据清理技术以及与认证ITAD合作伙伴合作,数据中心可实现循环经济模式,在确保数据安全的同时减少环境影响。

剑桥大学突破性研究:如何让AI在对话中学会真正的自信判断

剑桥大学研究团队首次系统探索AI在多轮对话中的信心判断问题。研究发现当前AI系统在评估自己答案可靠性方面存在严重缺陷,容易被对话长度而非信息质量误导。团队提出P(SUFFICIENT)等新方法,但整体问题仍待解决。该研究为AI在医疗、法律等关键领域的安全应用提供重要指导,强调了开发更可信AI系统的紧迫性。

2026年超大规模数据中心运营商发展前瞻:全球最大数据中心运营商的未来走向

超大规模云数据中心是数字经济的支柱,2026年将继续保持核心地位。AWS、微软、谷歌、Meta、甲骨文和阿里巴巴等主要运营商正积极扩张以满足AI和云服务需求激增,预计2026年资本支出将超过6000亿美元。然而增长受到电力供应、设备交付和当地阻力制约。截至2025年末,全球运营中的超大规模数据中心达1297个,总容量预计在12个季度内翻倍。

威斯康星大学研究团队破解洪水监测难题:AI模型终于学会了“眼观六路“

威斯康星大学研究团队开发出Prithvi-CAFE洪水监测系统,通过"双视觉协作"机制解决了AI地理基础模型在洪水识别上的局限性。该系统巧妙融合全局理解和局部细节能力,在国际标准数据集上创造最佳成绩,参数效率提升93%,为全球洪水预警和防灾减灾提供了更准确可靠的技术方案。

Littelfuse推出适用于电动汽车电池、电机和安全系统的汽车级电流传感器

CES 2026 | 机器人开发的“ChatGPT时刻”已到 老黄定调“物理AI”的路线图

超越能源使用:数据中心可持续运营策略

2026年超大规模数据中心运营商发展前瞻:全球最大数据中心运营商的未来走向

TOTOLINK EX200存在未修复固件漏洞可被完全远程接管

Ring推出Fire Watch功能,利用家庭摄像头追踪野火威胁

Snowflake与Google Gemini深度整合,全云环境支持数据分析

联想和摩托罗拉推出自有设备端AI助手

机器海龟游向环保使命:仿生技术守护珊瑚礁

CES 2026最酷笔记本电脑:可拆卸设计成为新趋势

AMD 在 CES 2026 发布新款锐龙处理器、Ryzen AI 及 AMD ROCm,全面扩展其在客户端、图形和软件领域的 AI 领先地位

AMD发布Instinct GPU新品挑战英伟达数据中心霸主地位