云服务、OEM借助NVIDIA AI让AI训练更上层楼

借助 NVIDIA AI,戴尔、浪潮、Microsoft Azure 和 Supermicro 在今天发布的新 MLPerf 基准测试中创下快速训练 AI 模型的记录。

看看谁刚刚在快速训练 AI 模型方面创下新速度记录:戴尔科技、浪潮、Supermicro和在 MLPerf 基准测试中首次亮相的 Azure 均在使用 NVIDIA AI。

在今天宣布的 MLPerf 训练 1.1 结果中,NVIDIA平台在所有八个热门工作负载中都创下了记录。

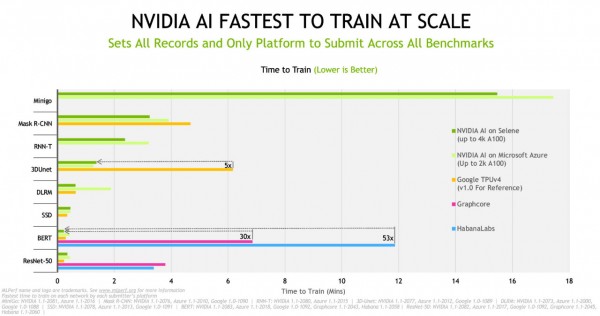

图示:在新一轮的测试中,NVIDIA AI 训练所有模型的速度都快于替代方案。

NVIDIA A100 Tensor Core GPU 提供了最出色每芯片性能, Selene 是NVIDIA内部基于模块化NVIDIA DGX SuperPOD架构构建的AI超级计算机,借助NVIDIA InfiniBand网络和NVIDIA软件栈进行扩展,A100在Selene上实现了最快的AI训练速度 。

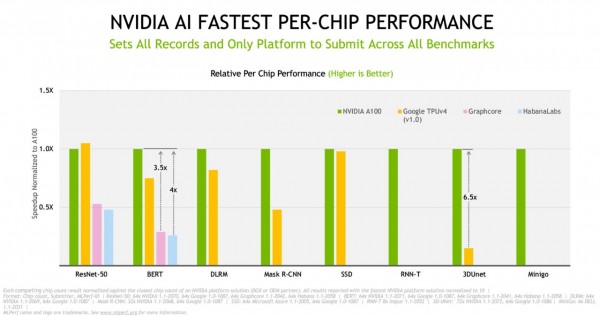

图示:NVIDIA A100 GPU 在所有八项 MLPerf 1.1 测试中均实现最好的每芯片训练性能。

云服务更上一层楼

根据最新结果,在训练 AI 模型方面,Azure 的 NDm A100 v4 实例的速度遥遥领先。它运行了新一轮的每项测试,扩展到多达 2,048 个 A100 GPU。

Azure 不仅展示了出色性能,而且在美国的六个地区,现在所有人都可以租借和使用其出色性能。

AI 训练是一项需要大量投入的大型工作。NVIDIA希望用户借助他们选择的服务或系统以创纪录的速度训练模型。

因此,NVIDIA将 NVIDIA AI 与面向云服务、主机托管服务、企业和科学计算中心的产品相结合。

服务器制造商各显身手

在 OEM 中,浪潮凭借其八路GPU服务器NF5688M6 和NF5488A5液冷服务器在单节点性能方面创下了最多记录。戴尔和 Supermicro 在四路 A100 GPU 系统上创下了记录。

共有 10 家 NVIDIA 合作伙伴提交了本轮测试结果,其中包含 8 家 OEM 和 2 家云服务提供商。它们占所有提交的 90% 以上。

这是 NVIDIA 生态系统在 MLPerf 训练测试中的第五次亮相,也是到目前为止最出色的亮相。

NVIDIA的合作伙伴之所以积极参与,是因为他们知道 MLPerf 是唯一符合行业标准、经过同行评审的 AI 训练和推理基准测试。对于评估 AI 平台和供应商的客户来说,这是一个有价值的工具。

为速度认证的服务器

百度 PaddlePaddle、戴尔科技、富士通、技嘉科技、慧与、浪潮、联想和 Supermicro 提交了基于本地数据中心的结果(单节点和多节点任务)。

NVIDIA几乎所有的 OEM 合作伙伴都在 NVIDIA 认证系统上运行了测试,NVIDIA为需要加速计算的企业客户验证了服务器。

提交的范围展示了 NVIDIA 平台的广度和成熟度,该平台为各种规模的企业提供最佳的解决方案。

既快速又灵活

NVIDIA AI 是唯一用于提交所有基准测试和用例的平台参与者,这展示了其通用性和高性能。快速灵活的系统提供客户所需的生产力,以加快他们的工作速度。

AI训练基准测试涵盖当今最热门的八个 AI 工作负载和场景,例如计算机视觉、自然语言处理、推荐系统、增强学习等。

MLPerf 测试透明、客观,因此用户可以依靠结果做出明智的购买决策。该行业基准测试组织成立于 2018 年 5 月,得到阿里巴巴、ARM、Google、Intel 和 NVIDIA 等数十家行业领先公司的支持。

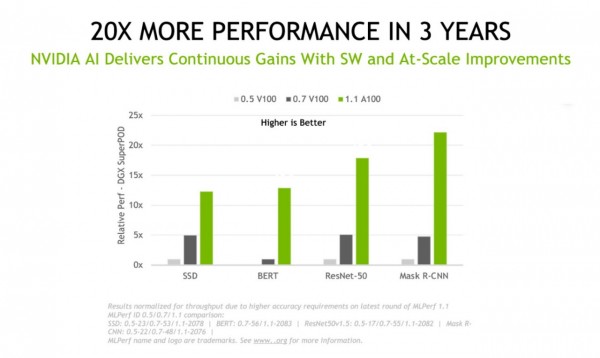

三年内加速 20 倍

回顾过去,数据显示,仅在过去 18 个月,NVIDIA A100 GPU 的性能就提升了 5 倍以上。这要归功于软件的持续创新,这也是NVIDIA目前工作的重心。

自从三年前 MLPerf 测试首次亮相,NVIDIA 的性能提高了 20 倍以上。这种大规模加速源于NVIDIA在全栈 GPU、网络、系统和软件方面取得的进步。

图示:NVIDIA AI 在三年内实现了 20 倍以上的改进。

持续改进软件

NVIDIA的新进展来自多项软件改进。

例如,借助一类新的内存复制操作,NVIDIA在针对医学成像的 3D-UNet 基准测试中实现 2.5 倍的操作加速。

得益于微调 GPU 以进行并行处理的方式,NVIDIA在针对物体检测的 Mask R-CNN 测试中实现 10% 的速度提升,而在针对推荐系统的测试中实现了 27% 的提升。NVIDIA只是重叠了独立操作,这种技术尤其适合跨多个 GPU 运行的作业。

NVIDIA扩展了 CUDA 图形的使用范围,尽可能减少与主机 CPU 的通信。得益于此,NVIDIA在针对图像分类的 ResNet-50 基准测试中实现了 6% 的性能提升。

NVIDIA在 NCCL 上实施了两种新技术。NCCL 是NVIDIA的库,用于优化 GPU 之间的通信。对于 BERT 等大型语言模型,这样可以将结果加速高达 5%。

利用NVIDIA工作结果

NVIDIA使用的所有软件均在 MLPerf 仓库提供,因此每个人都可以获得NVIDIA的出色结果。NVIDIA不断将这些优化整合到 NGC(NVIDIA的 GPU 应用程序软件中心)上的容器。

它是全栈平台的一部分,已在新的行业基准测试中得到验证,可从各种合作伙伴处获得,能够处理当今真正的 AI 作业。

好文章,需要你的鼓励

CES上杨元庆首谈AGI,碾压人类的叙事不会让AI更聪明

很多人担心被AI取代,陷入无意义感。按照杨元庆的思路,其实无论是模型的打造者,还是模型的使用者,都不该把AI放在人的对立面。

MIT递归语言模型:突破AI上下文限制的新方法

MIT研究团队提出递归语言模型(RLM),通过将长文本存储在外部编程环境中,让AI能够编写代码来探索和分解文本,并递归调用自身处理子任务。该方法成功处理了比传统模型大两个数量级的文本长度,在多项长文本任务上显著优于现有方法,同时保持了相当的成本效率,为AI处理超长文本提供了全新解决方案。

Gmail新增Gemini驱动AI功能,智能优先级和摘要来袭

谷歌宣布对Gmail进行重大升级,全面集成Gemini AI功能,将其转变为"个人主动式收件箱助手"。新功能包括AI收件箱视图,可按优先级自动分组邮件;"帮我快速了解"功能提供邮件活动摘要;扩展"帮我写邮件"工具至所有用户;支持复杂问题查询如"我的航班何时降落"。部分功能免费提供,高级功能需付费订阅。谷歌强调用户数据安全,邮件内容不会用于训练公共AI模型。

华为研究团队突破代码修复瓶颈,8B模型击败32B巨型对手!

华为研究团队推出SWE-Lego框架,通过混合数据集、改进监督学习和测试时扩展三大创新,让8B参数AI模型在代码自动修复任务上击败32B对手。该系统在SWE-bench Verified测试中达到42.2%成功率,加上扩展技术后提升至49.6%,证明了精巧方法设计胜过简单规模扩展的技术理念。

联想集团混合式AI实践获权威肯定,CES期间获评“全球科技引领企业”

CES上杨元庆首谈AGI,碾压人类的叙事不会让AI更聪明

CES 2026 | 重大更新:NVIDIA DGX Spark开启“云边端”模式

Gmail新增Gemini驱动AI功能,智能优先级和摘要来袭

研究发现商业AI模型可完整还原《哈利·波特》原著内容

Razer在2026年CES展会推出全息AI伴侣项目

CES 2026:英伟达新架构亮相,AMD发布新芯片,Razer推出AI奇异产品

通过舞蹈认识LimX Dynamics的人形机器人Oli

谷歌为Gmail搜索引入AI概览功能并推出实验性AI智能收件箱

DuRoBo Krono:搭载AI助手的智能手机尺寸电子阅读器

OpenAI推出ChatGPT Health医疗问答功能

Anthropic寻求3500亿美元估值融资100亿美元