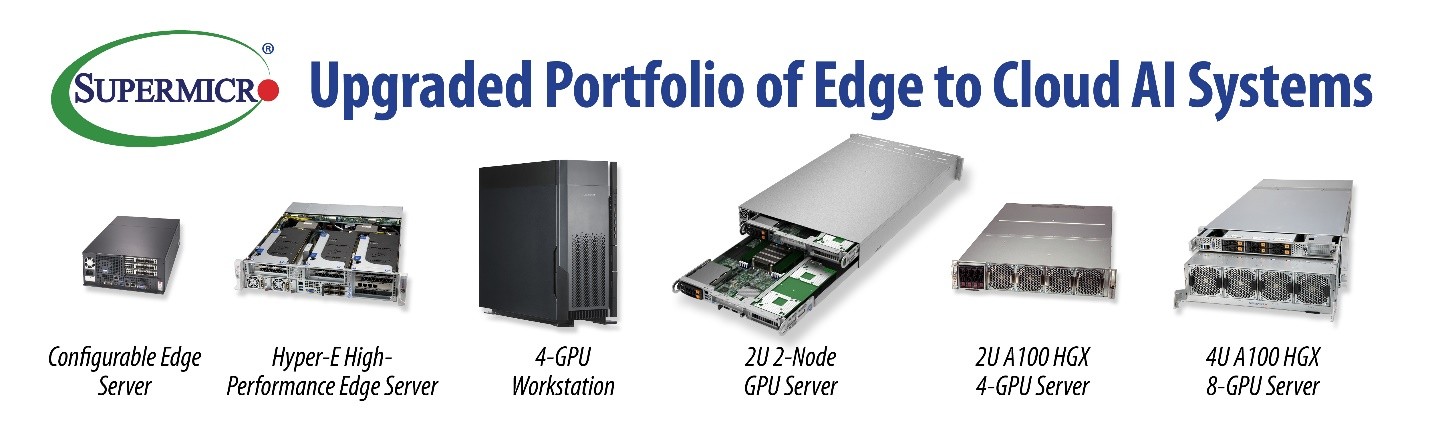

Supermicro加速推理和新智能结构支持,增强广泛边缘到云端人工智能系统产品组合

为企业级运算、储存、网络解决方案和绿色计算技术等领域的Super Micro Computer, Inc. (SMCI) ,近日宣布扩大最广泛的人工智能(AI)GPU服务器产品组合,此系列整合了最新的NVIDIA Ampere系列GPU,包括NVIDIA A100、A30和A2。

Supermicro最新的NVIDIA认证系统的AI性能是前几代产品的高十倍,确保支持AI的应用程序,如图像分类、物体检测、强化学习、推荐、自然语言处理(NLP)、自动语音识别(ASR),能大幅降低成本,更快得到深入洞察。除了推理,Supermicro高效能的A100 HGX 8-GPU和4-GPU服务器相比于前几代系统,在大数据分析方面提高了三倍AI训练速度和八倍性能。

Supermicro总裁暨首席执行官Charles Liang表示:“Supermicro以广泛的系统组合持续引领GPU市場,针对从边缘到云端的任何工作负载进行优化。我们针对云游戏的整体解决方案在一个2U 2节点系统中提供多达12个单宽度GPU,实现了卓越的密度和效率。此外,Supermicro还推出了新的通用GPU平台,將所有主要的CPU、GPU,以及结构和散热解决方案整合在一起。”

Supermicro E-403服务器是分布式AI推理应用的理想选择,适用于如交通控制和办公大楼环境等。Supermicro Hyper-E边缘服务器通过每个系统有多达三个A100 GPU为边缘应用带来了前所未有的推理能力。Supermicro現在提供完整的IT解決方案,可加速工程和设计专业人员之间的协作,其中包含了NVIDIA认证的服务器、储存装置、网络交换机以及用于专业级可视化和协作的NVIDIA Enterprise Omniverse软件。

NVIDIA加速计算部总经理兼副总裁Ian Buck表示:“ Supermicro广泛的NVIDIA认证系统由采用NVIDIA Ampere架构的完整GPU产品组合提供支持。Supermicro的客户可从中获得卓越效能,应用于各种类型的现代化AI工作流程——从边缘的推理,到云端的高效能运算,还有两者之间的一切应用。”

Supermicro效能强大的数据中心2U和4U GPU(Redstone、Delta)系统将率先上市,支持新的Quantum-2 InfiniBand产品系列和BlueField DPU。NVIDIA Quantum-2 InfiniBand解决方案包括高带宽、超低延迟适配器、交换机和电缆,以及能为数据中心带来高效能的完整软件,该解决方案运行于整个Supermicro产品系列。

与上一代InfiniBand通讯适配器和交换机相比,采用Quantum-2 InfiniBand的系统提供400 Gb/s的传输速率、每端口高2倍的带宽、更高的交换器密度,和每交换机高32倍的AI加速,并且能同时支持Intel或AMD处理器。

随着混合式工作环境成为常态,产业需要新技术来确保人力的技术平等。NVIDIA的Omniverse Enterprise和Supermicro GPU服务器的组合,将彻底颠覆复杂的3D工作流程,从而带来无限迭代和更快速的创新产品上市时间。此外,NVIDIA的Omniverse Enterprise,以及用于将AI整合到其企业工作流程中的AI Enterprise on VMware已针对Supermicro的NVIDIA认证系统进行了优化和测试,使地理位置分散的团队也能够无缝协作。

来源:业界供稿

好文章,需要你的鼓励

苹果2026年六大产品发布前瞻

苹果计划在2026年推出多款重磅新品,包括配备miniLED面板和A19 Pro芯片的27英寸外接显示器、搭载homeOS系统的7英寸智能家居控制设备、首次采用OLED屏幕的全新MacBook Pro、具备7.8英寸内屏的iPhone Fold折叠手机、售价699美元起的入门级MacBook,以及升级OLED显示技术的iPad mini。

阿里巴巴团队首次让AI学会真正“冲浪“网页:小模型也能像侦探一样深度挖掘网络信息

阿里巴巴团队开发出革命性AI浏览技术NestBrowse,让AI学会像侦探般深度挖掘网络信息。该系统采用双层嵌套结构,外层负责整体决策,内层专注信息提取,突破传统搜索局限。仅40亿参数的小模型就能超越大型系统,在复杂信息搜索任务中表现出色,为AI技术普及开辟新路径。

OpenAI招聘新任安全准备主管应对AI潜在危害

OpenAI正在招聘新的安全准备主管,负责预测其AI模型的潜在危害和滥用方式,以指导公司安全策略。这一职位出现在ChatGPT因对用户心理健康影响而面临多起诉讼的背景下。CEO阿尔特曼承认模型对心理健康的影响是2025年预见的挑战之一。该职位年薪55.5万美元加股权,将领导OpenAI准备框架的技术策略。

西湖大学携手蚂蚁集团突破AI视频理解瓶颈:OmniAgent让机器像人类一样“边听边看“分析视频

西湖大学联合蚂蚁集团推出OmniAgent,首个能够"边听边看"主动分析视频的AI系统。该技术突破了传统方法的局限,采用音频引导的"粗到细"感知策略,让AI像侦探破案一样灵活调用不同工具。在三大基准测试中,OmniAgent准确率比现有最佳模型提升10-20%,为智能视频理解开辟了全新路径。