论云原生时代云服务器的进化之道 原创

现在越来越多的企业上云、用云,我们距离云原生有多远呢?

在云计算诞生之前,应用的创建、运行、升级、维护都是比较痛苦的事情,因为应用与底层IT资源之间是紧密相连的。而在云的模式下,满足弹性所需的云计算替代了传统IT,并带来了云原生的理念。

因为现在有很多的机会让我们接触到公有云或是私有云,那我们对于应用的管理方式是不是也应该有一种当下的方式,我们就称其为云原生的方式。

云原生的本质,就是让应用距离云更近。云和本地是相对的,传统应用必须运行在本地服务器上,现在主流的应用都跑在云端,充分利用云资源的优点,比如云服务的弹性和分布式优势。

云原生并不是把原先在物理服务器上的业务应用直接迁移到云上,因为真正的云化不仅是基础设施和平台的事情,应用也要做出改变,改变传统,实现云化的应用。

特别是基础设施层面的创新非常重要,就拿云服务器来说,为了适配云原生技术就需要与时俱进不断进化。

云原生包含微服务、DevOps、可持续交付、容器化等四个要素,这些要求云服务器具备坚实的支撑能力,比如性能、灵活性等,满足云端应用的需求。

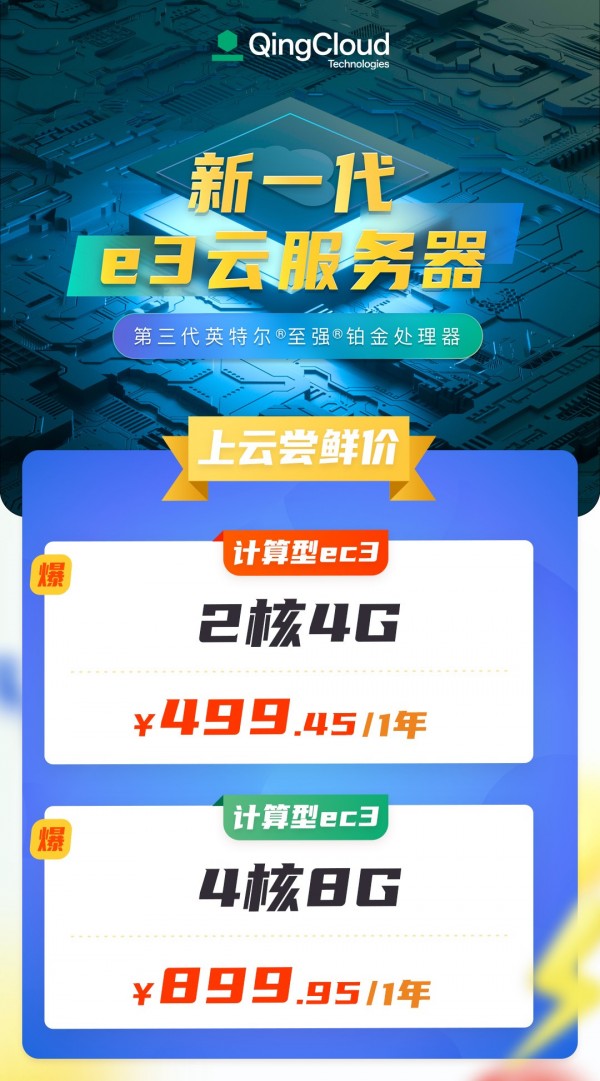

近日,青云QingCloud新一代企业级云服务器e3正式发布,基于e3自身优秀的计算性能、弹性伸缩和分布式存储等特点,可轻松满足企业面向云原生技术落地,高效开发云原生构架应用的进阶需求,提升应用开发效率。

场景与技术驱动云服务器进化

如今,云上“经济”模式呈爆发式增长,越来越多的企业通过云服务商提供的云上计算、网络、存储、安全、数据服务等资源,降本增效,驱动业务创新。

在这一过程中,我们看到云服务器在其中起到了至关重要的角色。这是因为云从最开始提供的是IaaS服务,而随着各种智能化应用的兴起,云服务器也成为了从IaaS到智能化应用连接的关键环节。

越来越多的行业对云服务的关注点逐步从资源层上移到应用层,这就对云服务器的能力提出了更高的要求。

例如,企业云上业务类型越来越多样化,基于云端的创新应用要求云服务器在性能方面和弹性伸缩方面依托分布式架构满足云原生应用需求。

同时,人工智能技术融入到云端应用,这就要求云服务器能够提供GPU资源池化,满足AI类应用的算力需求;5G、智能终端等驱动边缘计算发展,这就对云服务器的网络吞吐性能有了更高的要求,以承载NFV、SD-WAN等网络密集型应用。

在这种情况下,如果我们再用旧有的眼光来看云服务器,肯定是行不通的,我们需要从场景与技术两个维度来选择云服务器,也就是说云服务器自身的进化已经“时不我待”。

e3云服务器的迭代升级之道

基于对企业业务场景和技术潮流的思考,青云QingCloud e3云服务器在计算性能、网络和存储能力上进行了升级,匹配Web服务器、高性能数据库以及各类企业级计算密集型应用开发测试等场景。

在计算层面,e3云服务器搭载了最新的第三代英特尔®至强®可扩展处理器,实现了更高性能和更低功耗,不仅提升了复杂业务承载、处理能力,帮助企业应对瞬时高爆发海量数据处理需求,能够有效保障企业应用的稳定性和反馈及时性,支撑核心关键业务上云,也对大数据应用和AI等场景需求表现出极高的性能优势。

在存储层面,e3云服务器采用了RDMA技术,搭载即将上线的增强型SSD云硬盘,实现单盘最高可达100k IOPS。其次,e3云服务器数据吞吐量大幅提升,达到750MB/s,写延迟低于50μs。在数据库、日志分析等场景下,可为用户提供海量数据的即时处理能力,以及更加可靠的数据传输通道。

在网络层面,网络增强型e3云服务器搭载了50Gbps网卡,最大内网带宽可达32Gbps,网络转发率可达20M PPS,网络延时低至50μs,并支持RDMA和DPDK功能,适配HPC、AI、NFV和SD-WAN等应用。

撇开应用场景谈配置和性能都是耍流氓。e3云服务器这些升级都是针对业务场景的量身定制。例如在物联网场景大量传感器数据(如烟雾、湿度、温度等)需要存储到数据库中,e3利用低存储延时优势和IOPS的升级特性,为智慧城市解决方案供应商提供海量数据的即时处理能力。

而在MySQL等数据库场景和Redis等缓存场景应用中,e3云服务器比市面主流云服务器的网络和储存延时更低,可以更好地帮助企业开发云原生应用,例如加速互联网点餐高峰阶段的订单处理、实现大批量的实时物流跟踪系统等。

此外,青云科技一直在推动云资源的价格下调,降低企业的用云成本。e3云服务器也具备较高性价比。

结语

企业数字化转型逐渐深入,应用上云需求持续增加,特别是在云原生技术驱动下,企业对于云服务器的要求也越来越高。而e3云服务器在算力和网络、存储性能等方面不断进化,更好地与企业应用场景进行融合,为企业云上创新提供了坚实的“底座”。

来源:至顶网计算频道

好文章,需要你的鼓励

AI智能体漏洞挖掘成本骤降,Anthropic呼吁AI防御

Anthropic发布SCONE-bench智能合约漏洞利用基准测试,评估AI代理发现和利用区块链智能合约缺陷的能力。研究显示Claude Opus 4.5等模型可从漏洞中获得460万美元收益。测试2849个合约仅需3476美元成本,发现两个零日漏洞并创造3694美元利润。研究表明AI代理利用安全漏洞的能力快速提升,每1.3个月翻倍增长,强调需要主动采用AI防御技术应对AI攻击威胁。

NVIDIA联手多所高校推出SpaceTools:AI机器人有了“火眼金睛“和“妙手回春“

NVIDIA联合多所高校开发的SpaceTools系统通过双重交互强化学习方法,让AI学会协调使用多种视觉工具进行复杂空间推理。该系统在空间理解基准测试中达到最先进性能,并在真实机器人操作中实现86%成功率,代表了AI从单一功能向工具协调专家的重要转变,为未来更智能实用的AI助手奠定基础。

Spotify年度盘点2025首次推出多人互动功能“盘点派对“

Spotify年度总结功能回归,在去年AI播客功能遭遇批评后,今年重新专注于用户数据深度分析。新版本引入近十项新功能,包括首个实时多人互动体验"Wrapped Party",最多可邀请9位好友比较听歌数据。此外还新增热门歌曲播放次数显示、互动歌曲测验、听歌年龄分析和听歌俱乐部等功能,让年度总结更具互动性和个性化体验。

机器人学会“三思而后行“:中科院团队让AI机器人告别行动失误

这项研究解决了现代智能机器人面临的"行动不稳定"问题,开发出名为TACO的决策优化系统。该系统让机器人在执行任务前生成多个候选方案,然后通过伪计数估计器选择最可靠的行动,就像为机器人配备智能顾问。实验显示,真实环境中机器人成功率平均提升16%,且系统可即插即用无需重新训练,为机器人智能化发展提供了新思路。

联想全面激活世界杯官方技术合作伙伴身份,天禧AI足球智能体重磅上线

AI测试成数智化合规必选项,驱动企业高质量发展

AI智能体漏洞挖掘成本骤降,Anthropic呼吁AI防御

Spotify年度盘点2025首次推出多人互动功能"盘点派对"

英国SAP用户因商业套件重启授权迷局感到困惑

AWS发布Graviton5定制CPU,为云工作负载带来强劲性能

美光放弃Crucial品牌:告别消费级存储市场

手机里的NPU越来越强,为什么AI体验还在原地踏步?

如何使用现有基础设施让数据做好AI准备

IT领导者快问快答:思科光网络公司首席数字信息官Craig Williams分享AI转型经验

Anthropic CEO警告AI行业泡沫化,批评"YOLO"式投资

雅虎利用AI实时总结橄榄球比赛精彩内容