AI风暴:危机之下,我们如何在三周内打造美国最强大的工业计算机

Selene背后蕴含的是通过系统专业知识将高性能计算带入数据中心的故事。

Selene一部分的艺术渲染图

当下,疫情席卷全球,而一个小团队用不到一个月的时间就成功组装了全球速度排名第七的计算机。

如今,这一名为Selene的大型系统不仅能够在Slack上与操作员进行通信、拥有自己的机器人服务生,还推动着AI在汽车、医疗保健和自然语言处理领域的发展。

许多超级计算机采用了具有异域风情的专有设计,但这样的设计往往需要花费数月时间才能完成,而Selene基于NVIDIA与客户共享的开放式架构。

位于芝加哥附近的阿贡国家实验室(Argonne National Laboratory)正在使用基于DGX SuperPOD设计的Selene构建的系统来研究遏制冠状病毒的方法。佛罗里达大学也将使用该设计构建学术界最快的AI计算机。

DGX SuperPOD也正推动着大陆集团在汽车领域、微软在云计算服务领域的业务成果。

AI系统的诞生

NVIDIA如何打造Selene,又是缘何要打造Selene呢?故事要从2015年说起。

NVIDIA工程师出于两个动机,启动了他们的首个系统级设计。他们希望构建一种通用工具,既能对其同事为自动驾驶汽车而构建的AI模型进行训练,同时适用性足够强从而能满足所有深度学习研究人员的需求。

2016年,他们的研究成果——基于NVIDIA Pascal GPU 的SATURNV集群诞生了。一年后,功能更强大的NVIDIA Volta GPU首次面世。此时,这一尚处于萌芽期的系统团队的研究动力和设计能力也得到大幅提升。

AI的用武之地不止于加速器

该系统团队负责人、首席架构师Michael Houston表示:“我们正在根据研究人员的反馈来预测未来发展方向,打造用途多且使用寿命长的机器,并尽可能提升处理、内存和存储能力。”

“早在2017年,我们就注意到,新的应用将推动对多节点训练的需求,这就要求系统之间能够进行高速通信,并可访问高速存储。”他说道。

AI模型发展迅速,需要多GPU来进行处理。工作量的增长导致需要新的计算方式(例如模型并行性)保持与时俱进。

因此,该团队很快就打造了当时最大的基于V100的NVIDIA DGX-2系统集群,即DGX POD。他们最初使用32个DGX-2节点,随后使用64个,最终打造了名为DGX SuperPOD的96节点架构。

他们将其以一位极具魅力的希腊女神“Circe”命名。Circe于2019年6月面世,当时在全球最快的超级计算机TOP500排名中位列第22位,目前位列第23位。

在计算机的丛林中,对电缆“快刀斩乱麻”

在此过程中,团队学习了有关网络、存储、功率和热能的课程。他们将这些经验都融入到了最新的NVIDIA DGX系统、参考架构、以及当今的280节点Selene中。

从当时最大的集群到Circe,一路走来,有些经验教训着实来之不易。

“我们经历了两次拆开重来,真的是直接剪断了电缆。这是加速项目进程最快的方法,但仍造成了大量的停机时间,同时耗费了大量成本。因此,我们发誓不再这样做,而是将易于扩展和增量部署作为基本设计原则。” Houston如是说。

团队重新设计了整个网络,以简化系统组装。

他们定义了由20个节点组成的模块,这些模块可通过相对简单的“薄型交换机”连接。这些“可扩展单元”中的每一个都可被单独添加,以相同的模式,启动运行并进行测试,然后再添加下一个。

这样的设计让工程师能够指定一定长度的电缆,以便可与工厂的Velcro捆绑在一起。通过对机架进行标记和映射,可从根本上简化在机架上填充数十个系统的过程。

InfiniBand助力实现运算加倍

早期,该团队学会了将计算、存储和管理结构拆分为独立的面板,从而,将它们分布在更多、更快的网络接口卡上。

NIC与GPU的比例增加了一倍,达到了1:1。因此,速度也提升了一倍,从Circe的每秒100 Gbit InfiniBand到Selene的200G HDR InfiniBand。最终,导致有效节点带宽增加了4倍。

同样,内存及存储链路的容量和吞吐量也有所增长,以处理有热存储、温存储和冷存储需求的作业。四个存储层跨越了100 TB/秒的内存,链接到100 GB/秒的存储池。

功率和热能维持在风冷限制内。默认设计的使用租用数据中心中典型的35kW机架,但对于最强大的超级计算机中心,可扩展到50kW以上,而某些电信公司使用的机架则可缩至7kW。

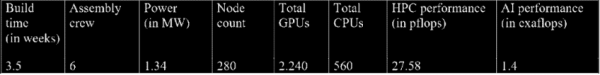

Selene数据一览

打造平衡的大型系统

最终成果是打造了更为平衡的设计,能够处理当今各种不同的工作负载。这种灵活性让研究人员能够自由地探索AI和高性能计算的全新发展方向。

“从某种程度上来说,高性能计算和AI都需要最高的性能,但是你必须仔细考虑如何在功率、存储和网络以及原始处理方面实现这样的性能。”高级开发团队负责人Julie Bernauer说道。她领导的团队参与了NVIDIA所有大型系统的开发工作。

疫情期间,骨干团队严守规章制度

2020年初,付出得到了回报。

在疫情爆发几天后,首批NVIDIA Ampere架构GPU面世了,工程师们面临着组装280节点Selene的严峻工作。

在最理想的情况下,数十名工程师可能需要花费几个月的时间,进行超级计算机级系统的组装、测试和调试。而NVIDIA必须在几周之内就让Selene启动运行,以参加行业基准测试,并履行对Argonne等客户的义务。

工程师必须严格遵守疫情期间的公共卫生准则。

Bernauer表示:“我们的骨干团队必须严守相关规章制度,以确保员工的健康。”

“在拆箱组装系统时,我们以两人为一组,各组之间互不接触,同组人员甚至会同时休假。在布线时,人员距离保持六英尺。这确实是一种构建系统的新方式。”她说。

即使面临COVID-19疫情的限制,工程师每天也能搭建多达60个系统,这是他们装卸平台能力的上限。通过虚拟登录,管理员可以远程验证电缆连接,并在部署20节点模块的同时,对其进行测试。

Bernauer的团队实现了几层的自动化。这就减少了对Selene所在的协同区域内人员的需求,该场所距离NVIDIA硅谷总部只有一个街区。

通过Slack与超级计算机沟通

Selene可以像同事一样通过Slack与员工交谈。它会报告电缆松动,并隔离出现故障的硬件,以维持系统持续运行。

“我们不希望因为集群出现问题而在半夜起床处理。” Bernauer说道。

如果客户遵循DGX POD和SuperPOD架构中的指导,就能实现一定程度的自动化。

例如,得益于这种方法,佛罗里达大学将为其HiPerGator系统集成140节点的扩展,并致力于在交付后的10天内就开始运行学术界最强大的AI超级计算机。

作为补充,NVIDIA团队从Double Robotics购买了一个远程机器人。如此一来,居家办公的非必需设计人员可与Selene保持日常联系。他们半开玩笑地为其取名为“Trip(意为绊倒)”,因为此前担心它可能会撞上现场的重要技术人员。

Trip基于NVIDIA Jetson TX2模块,这对那些预想自己未来可能会修改其编程的团队成员来说,是又是一个额外的吸引点。

自7月下旬以来,工程师们经常使用Trip,以虚拟方式穿行于Selene的过道,并通过机器人的摄像头和麦克风来观察系统。

Bernauer 表示:“Trip并不能代替人工,但有了Trip的帮助,如果你担心凌晨2点会出现问题,不用开车到数据中心,也能进行检查。”

Trip帮助工程师在搭建Selene时对其进行检查

大规模交付HPC和AI成果

最终还是结果为王,而且结果来的很迅速。

6月,Selene在最节能系统的TOP500榜单中位列第7,在Green500榜单中位列第2。7月,Selene在最新的MLPerf基准测试中对AI训练性能的所有八项系统测试中均创下纪录。

Houston表示:“对我而言,最大的惊喜是,在我们使用新的处理器和开发板的情况下,一切都进展非常顺利。我感谢一路以来所有的测试,帮助团队致力于提高这台机器的性能,紧锣密鼓地进行一系列严格的基准测试,带给团队很大的提升。”

为阿贡实验室进行的NGC容器和HPC软件预测试工作更加令人满意。该实验室已开始着手解决蛋白质对接和量子化学领域的难题,以期进一步了解冠状病毒。

另外,Circe将其许多免费周期捐赠给了致力于对抗COVID的Folding @ Home计划。

同时,NVIDIA研究人员正在使用Selene来训练自动驾驶汽车并完善对话式AI,近期有望快速取得进展。到目前为止,有超过一千个基于该系统的工作同时运行。

同时,该团队已经提出了未来的初步想法。“我们将为注重性能的工程师提供足够的马力和电缆,以期造出令人惊奇的成果。” Bernauer如是说。

来源:业界供稿

好文章,需要你的鼓励

奥运级别的努力:首席信息官为2026年AI颠覆做准备

AI颠覆预计将在2026年持续,推动企业适应不断演进的技术并扩大规模。国际奥委会、Moderna和Sportradar的领导者在纽约路透社峰会上分享了他们的AI策略。讨论焦点包括自建AI与购买第三方资源的选择,AI在内部流程优化和外部产品开发中的应用,以及小型模型在日常应用中的潜力。专家建议,企业应将AI建设融入企业文化,以创新而非成本节约为驱动力。

字节跳动发布GAR:让AI能像人类一样精准理解图像任何区域的突破性技术

字节跳动等机构联合发布GAR技术,让AI能同时理解图像的全局和局部信息,实现对多个区域间复杂关系的准确分析。该技术通过RoI对齐特征重放方法,在保持全局视野的同时提取精确细节,在多项测试中表现出色,甚至在某些指标上超越了体积更大的模型,为AI视觉理解能力带来重要突破。

Spotify推出AI播放列表功能让用户掌控推荐算法

Spotify在新西兰测试推出AI提示播放列表功能,用户可通过文字描述需求让AI根据指令和听歌历史生成个性化播放列表。该功能允许用户设置定期刷新,相当于创建可控制算法的每周发现播放列表。这是Spotify赋予用户更多控制权努力的一部分,此前其AI DJ功能也增加了语音提示选项,反映了各平台让用户更好控制算法推荐的趋势。

Inclusion AI推出万亿参数思维模型Ring-1T:首个开源的超大规模推理引擎如何重塑AI思考边界

Inclusion AI团队推出首个开源万亿参数思维模型Ring-1T,通过IcePop、C3PO++和ASystem三项核心技术突破,解决了超大规模强化学习训练的稳定性和效率难题。该模型在AIME-2025获得93.4分,IMO-2025达到银牌水平,CodeForces获得2088分,展现出卓越的数学推理和编程能力,为AI推理能力发展树立了新的里程碑。

为AI+而生,海辰储能发布全球首款锂钠协同AIDC全时长储能解决方案

长时储能开启智慧未来:海辰储能生态日全球首发三大新品

Arm 借助融合型 AI 数据中心,重塑计算格局

奥运级别的努力:首席信息官为2026年AI颠覆做准备

Spotify推出AI播放列表功能让用户掌控推荐算法

Adobe押注生成式AI获得回报,年度营收创历史新高

OpenAI与迪士尼达成十亿美元合作协议,米老鼠和漫威角色进入Sora

甲骨文150亿美元数据中心投资导致股价下跌

Spoor鸟类监测AI软件需求飞速增长

制药行业AI数据质量危机:垃圾进垃圾出的隐患

Harness获得2.4亿美元融资,估值达55亿美元,专注自动化AI编码后的开发流程

英伟达CEO黄仁勋独家专访:万亿美元押注AI工厂将成为新时代计算机