加速HPC与AI融合 NVIDIA发布全系列新品赋能科学计算 原创

每年ISC、SC公布的TOP榜单可谓是HPC领域最受关注的事件之一,因为业界不光关注厂商的排名,还关注这些上榜的系统背后的架构情况,比如使用了什么CPU和GPU等。

在今年ISC2020上,TOP10的HPC中,有8台系统采用了NVIDIA GPU、InfiniBand网络技术,或同时采用了两种技术,其中包括美国、欧洲和中国领跑的HPC系统。

如今,AI和数据分析已成为科学计算中的新需求,而NVIDIA一直不断创新,借助软硬结合的解决方案,加速了HPC与AI的融合进程。而在近日举行的SC2020期间,NVIDIA则推出了包括NVIDIA A100 80GB GPU、NVIDIA HGX AI超级计算平台、NVIDIA DGX Station A100以及NVIDIA Mellanox 400G InfiniBand等一系列的产品,将AI超级计算推向了一个新的高度。

AI超级计算全球最强GPU:NVIDIA A100 80GB GPU

针对现在日益负载的HPC与AI工作负载,特别是面向深度学习与机器学习等应用,NVIDIA推出了A100 80GB GPU,其可以称为目前AI超级计算全球最强GPU。因为,A100 80GB GPU基于NVIDIA Ampere架构,为其带来了突破性的特性。

借助第三代Tensor Core核心,通过全新TF32,NVIDIA A100 80GB GPU将上一代Volta架构的AI吞吐量提高多达20倍。通过FP64,将HPC性能提高多达2.5倍。通过INT8,将AI推理性能提高多达20倍,并且支持BF16数据格式。

凭借其多实例GPU(MIG)技术,NVIDIA A100 80GB GPU可分割为多达7个GPU实例,每个实例具有10GB内存。该技术是一种安全的硬件隔离方法,在处理各类较小的工作负载时,可实现GPU最佳利用率。对于如RNN-T等自动语言识别模型的AI推理,单个A100 80GB MIG实例可处理更大规模的批量数据,将生产中的推理吞吐量提高1.25倍。

在计算性能提升的同时,NVIDIA A100 80GB GPU基于A100 40GB的多样化功能,采用HBM2e技术,可将A100 40GB GPU的高带宽内存增加一倍至80GB,提供每秒超过2TB的内存带宽。这使得数据可以快速传输到全球最快的数据中心GPU A100上,使研究人员能够更快地加速其应用,处理最大规模的模型和数据集。

同时,依托第三代NVLink和NVSwitch互连技术,NVIDIA A100 80GB GPU之间的带宽增加至原来的两倍,将数据密集型工作负载的GPU数据传输速度提高至每秒600gigabytes。

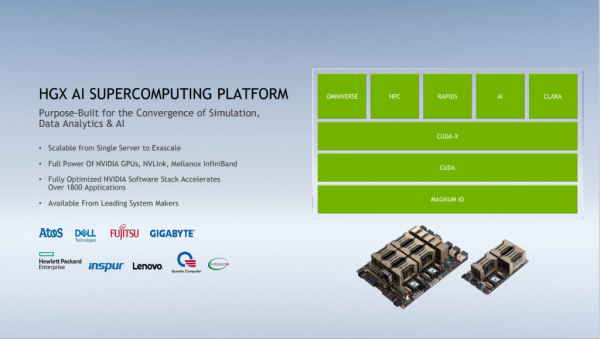

目前,NVIDIA A100 80GB GPU已经支持NVIDIA HGX AI超级计算平台。NVIDIA HGX AI超级计算平台将NVIDIA GPU、NVIDIA NVLink 、NVIDIA InfiniBand网络以及全面优化的NVIDIA AI和HPC软件堆栈的全部功能整合在一起,以提供最优越的应用性能。

由于GPU内存比上一代提升一倍,HGX服务器中搭载的A100 80GB还可训练具有更多参数的最大模型,如GPT-2,能够为研究人员和工程师们提供空前的速度和性能,助力实现新一轮AI和科学技术突破。

同时,源讯、戴尔科技、富士通、技嘉科技、慧与、浪潮、联想、云达科技、超微预计将于2021年上半年,提供基于HGX A100集成底板的系统,该集成底板搭载4-8个A100 80GB GPU。

一体式AI数据中心:NVIDIA DGX Station A100

NVIDIA全球唯一的千兆级工作组服务器NVIDIA DGX Station A100正式发布。作为开创性的第二代人工智能系统,DGX Station A100加速满足位于全球各地的公司办公室、研究机构、实验室或家庭办公室中办公的团队对于机器学习和数据科学工作负载的强烈需求。

DGX Station A100的AI性能可达2.5petaflops,是唯一一台配备四个通过NVIDIA NVLink完全互连的全新NVIDIA A100 Tensor Core GPU的工作组服务器,可提供高达320GB的GPU内存,能够助力企业级数据科学和AI领域以最速度取得突破。

DGX Station A100配备四组80GB或40GB NVIDIA A100 Tensor Core GPU,比上一代DGX Station提速4倍以上,对于诸如BERT Large训练与推理等复杂的对话式AI模型,其性能提高近3倍,让数据科学和AI研究团队能够结合自身工作负载和预算来选择系统。

DGX A100系统将配备全新NVIDIA A100 80GB GPU使每个DGX A100系统的GPU内存容量增加一倍(最高可达640GB),从而确保AI团队能够使用更大规模的数据集和模型来提高准确性,承载更大规模的数据中心工作负载。

作为服务器级的系统,DGX Station A100无需配备数据中心级电源或散热系统,却具有与NVIDIA DGX A100数据中心系统相同的远程管理功能。当数据科学家和研究人员在家中或实验室办公时,系统管理员可轻松地通过远程连接,执行任何管理任务。

DGX Station A100也是唯一支持NVIDIA多实例GPU(MIG)技术的工作组服务器。借助MIG,单一DGX Station A100最多可提供28个独立GPU实例以运行并行任务,并可在不影响系统性能的前提下支持多用户。

全新DGX A100 640GB系统也将集成到企业版NVIDIA DGX SuperPOD解决方案,使机构能基于以20 个DGX A100系统为单位的一站式AI超级计算机,实现大规模AI模型的构建、训练和部署。

据悉,配备A100 80GB GPU的NVIDIA DGX SuperPOD系统将率先安装于英国的Cambridge-1超级计算机,以加速推进医疗保健领域研究,以及佛罗里达大学的全新HiPerGator AI超级计算机,该超级计算机将赋力这一“阳光之州”开展AI赋能的科学发现。

目前,DGX Station的用户已经遍布教育、金融服务、政府、医疗健康、和零售等行业,其中包括宝马集团、德国人工智能研究中心、NTT Docomo、太平洋西北国家实验室(PNNL)等。

NVIDIA DGX Station A100和NVIDIA DGX A100 640GB系统将于本季度通过全球NVIDIA合作伙伴网络经销商供货。NVIDIA DGX A100 320GB用户可选择升级。

最快网络性能:NVIDIA Mellanox 400G InfiniBand

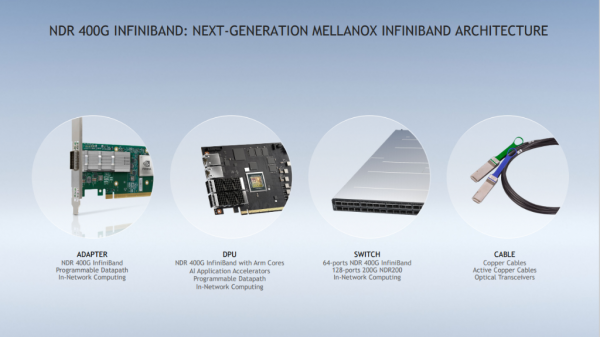

通常AI应用需要更快,更智能,更具扩展性的网络,而Mellanox InfiniBand一直是AI超级计算的最佳网络解决方案,今天NVIDIA正式推出了面向AI超级计算的业界最强大的网络解决方案——下一代NVIDIA Mellanox 400G InfiniBand,为AI开发人员和科学研究人员提供了最快的网络互连性能。

第七代Mellanox InfiniBand NDR 400Gb/s产品提供超低延迟,并在上一代产品的基础上实现了数据吞吐量翻倍,同时增加了新的NVIDIA网络计算引擎,实现了额外的加速。

Mellanox NDR 400G InfiniBand交换机,可提供3倍的端口密度和32倍的AI加速能力。此外,它还将框式交换机系统的聚合双向吞吐量提高了5倍,达到1.64petabits/s,从而使用户能够以更少的交换机,运行更大的工作负载。

网络协同技术已经彻底改变HPC行业,传统的以CPU为中心的数据中心架构很多功能需要CPU处理,而过渡到以数据为中心的新体系结构要求网络高速且有效,这意味着它们必须把更多的功能从CPU卸载到网络中的其他地方。第三代NVIDIA Mellanox SHARP技术使InfiniBand网络能够卸载并加速深度学习训练操作,使AI加速能力提高32倍。与NVIDIA Magnum IO软件栈相结合,可开箱即用,加速科学计算。

基于Mellanox InfiniBand架构的边缘交换机的双向总吞吐量可达51.2Tb/s,实现了具有里程碑意义的每秒超过665亿数据包的处理能力。基于Mellanox InfiniBand的模块化交换机的双向总吞吐量将达到每秒1.64petabits,比上一代产品高5倍。

而且,Mellanox InfiniBand架构基于业界标准,以确保前后代产品兼容性,并保护数据中心投资。基于该架构的解决方案预计将于2021年第二季度提供样品。

结语

从此次NVIDIA发布的产品可以看到,NVIDIA为AI超级计算提供了全面的技术方案,包括GPU、网络以及一体化的产品组合。而依托全新的NVIDIA Ampere架构,NVIDIA让GPU在加速HPC与AI融合方面更进了一步,赋能科技计算。

好文章,需要你的鼓励

Google推出通用商务协议并在Gemini中集成购买按钮

谷歌在AI购物战中加码,宣布将Gemini打造成购物平台,并与Shopify、沃尔玛、塔吉特等主要零售商合作推出开源标准。公司发布了通用商务协议(UCP),旨在简化AI代理与零售商系统间的通信。新标准将为搜索和Gemini提供结账功能,用户可直接通过AI工具购买商品。已获得Visa、万事达、PayPal等20多家公司支持。此举使谷歌与微软Copilot和OpenAI的ChatGPT竞争。

德国机构首创免训练人脸质量评估技术:Vision Transformer也能当“质检员“

德国弗劳恩霍夫研究院提出ViTNT-FIQA人脸质量评估新方法,无需训练即可评估图像质量。该方法基于Vision Transformer层间特征稳定性原理,通过测量图像块在相邻层级间的变化幅度判断质量。在八个国际数据集上的实验显示其性能可媲美现有最先进方法,且计算效率更高,为人脸识别系统提供了即插即用的质量控制解决方案,有望广泛应用于安防监控和身份认证等领域。

非洲电信基础设施巨头数字化转型实战访谈

Helios Towers供应链总监Dawn McCarroll在采访中分享了公司的数字化转型经验。作为一家在非洲和中东地区运营近15000个移动通信塔站的公司,Helios正通过SAP S/4Hana系统升级、AI技术应用和精益六西格玛方法论来优化供应链管理。McCarroll特别强调了公司Impact 2030战略中的数字包容性目标,计划在未来五年内培训60%的合作伙伴员工掌握精益六西格玛原则,并利用大数据和AI技术实现端到端的供应链集成。

临床AI大模型的人格面具:布朗大学揭示医疗角色扮演的双刃剑效应

布朗大学联合图宾根大学的研究团队通过系统实验发现,AI医疗助手的角色设定会产生显著的情境依赖效应:医疗专业角色在急诊场景下表现卓越,准确率提升20%,但在普通医疗咨询中反而表现更差。研究揭示了AI角色扮演的"双刃剑"特性,强调需要根据具体应用场景精心设计AI身份,而非简单假设"更专业等于更安全",为AI医疗系统的安全部署提供了重要指导。