芯片行业需要更多软件才能赶上在人工智能领域领先的Nvidia

AI(人工智能)芯片初创公司BrainChip产品开发负责人Anil Mankar周二在著名的Linley Fall Processor会议上介绍了BrainChip公司技术的详细信息。会议组织者Linley Gwennap提出,整个行业需要更多的软件功能才能赶上在AI领域遥遥领先的Nvidia。(图:BrainChip)

半导体行业目前处于芯片设计和性能改进的复兴时期,但要赶上图形芯片巨头Nvidia(英伟达)却还需要更多的软件。业界会议Linley Fall Processor Conference(Linley秋季处理器会议)星期二提出了此观点。

Linley Fall Processor Conference本周和下周以虚拟形式举行。Linley Fall Processor Conference每年举行一次,为年轻的芯片公司提供交流机会。

该会议的主持人Linley Gwennap是个有二十年经验的半导体分析师。他在周二上午的大会开幕式上发表主题演讲表示,对于那些想挑战英伟达在人工智能方面领先优势的公司而言,软件仍然是绊脚石。

Gwennap表示,“一些芯片供应商和云服务供应商为AI加速开发出了令人印象深刻的硬件,但下一个障碍是软件。”

他在提到英伟达竞争对手遇到的困难时风趣地表示,“软件是个极难的单词。”

他称有些公司或是不支持流行AI框架(例如TensorFlow)的某些功能,或是某些用于竞争芯片的AI应用程序甚至都可能没法正确地编译。

他表示,“这些供应商要与Nvidia和英特尔等公司的深度软件堆栈竞争就必须支持广泛的框架和开发环境,提供相应的驱动程序、编译器和调试工具,为各种客户工作负载提供全面的加速和最佳性能。”

Nvidia在构建神经网络的训练操作方面领先十几年。Nvidia的CUDA是个软件系统。一些曾与Nvidia芯片合作构建神经网络的AI领域明星级人物曾一再提出,AI领域需要竞争才能打破Nvidia对AI科学领域的控制。

Global Foundries总经理Hiren Majmudar在会上详细介绍了Global Foundries公司在物理设备方面的各种创新, AI初创公司可以利用这些创新取得性能优势。(图:Global Foundries)

AI的开发传统上是用在汽车和基础架构的嵌入式设备上,现在已经扩展到云计算数据中心。英国的Imagination and Think Silicon是芯片设备巨头Applied Materials的一个部门。Imagination and Think Silicon开发了一些临界低功耗设备,可以应用于功耗受限的设备,例如由电池供电的微控制器产品。

英伟达上个月宣布打算以400亿美元收购Arm Plc。这样一来,要缩小与巨头的差距就更难了。芯片行业所有挑战者生产的芯片知识产权的核心属于Arm制造。因此,英伟达软件就会占更大的上风。

Gwennap表示,那些希望从Nvidia手里挖走市场份额的公司只得构建自己的软件及复制Nvidia的某些功能,但还没有产品能消除差距。

他表示,“目前存在一些开源努力,但并没有很大的吸引力。大多数公司要开发自己的替代方案,这就是为什么花了这么长时间。”

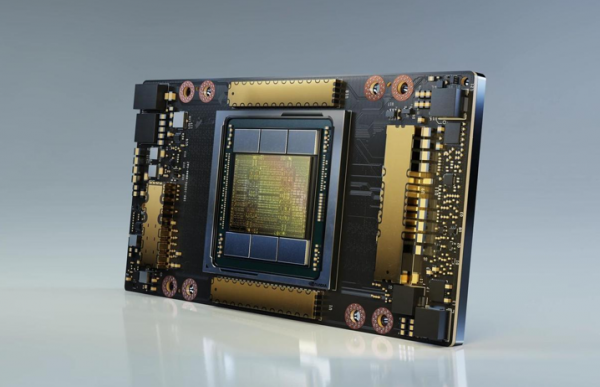

尽管受到BrainChip和其他公司激增的竞争挑战,Nvidia芯片(例如A100)仍继续在市场份额和整体性能方面处于领先地位。(图:英伟达)

这次会议吸引了许多新公司和已有所建树的公司,每个公司都有一些在某些AI任务的原始性能方面优于Nvidia的创新。创业公司包括Tenstorrent、Brainchip和SiFive等。包括英特尔和谷歌在内的一些知名公司也参与了该次会议。

合同芯片制造商Global Foundries为大批芯片公司生产处理器。Global Foundries在会上展示了创新的广度和深度。Global Foundries公司描述了如何改善底层芯片的物理性能进而创建更好的晶体管,晶体管是所有芯片的基本组成部分。

尽管各方面的发展,英伟达新的和旧的部件的性能仍然令人印象深刻,MLPerf行业组织周三发布的最新AI基准测试结果证明了这一点(https://www.zdnet.com/article/nvidia-makes-a-clean-sweep-of-mlperf-predictions-benchmark-for-artificial-intelligence/)。

Gwennap表示,软件仍然是缩小差距的症结所在。

记者问Gwennap要采取哪些措施才能与Nvidia进行实质性竞争,他表示,“英特尔和高通拥有良好的软件堆栈,他们在软件上进行了大量投资并拥有大量的资源,我们看到一些资金雄厚的初创公司取得了一些进展,一些不错的进展,但一切都仍然需要时间。”

会议的组织者Linley Gwennap表示,软件仍然是那些想与Nvidia竞争公司的最大弱点。(图:Linley集团)

他表示,“取决于团队的规模和专业知识,开发此软件可能要花费数月甚至数年。”

诸如Cerebras Systems和Graphcore的公司出售自己的计算系统,这些公司打造了全新的软件程序,用在自己芯片上神经网络处理方式的优化。但这些个别的努力可能会使新芯片的使用趋向分化。

相比之下,英伟达的CUDA为人工智能设计人员提供了一致的平台,设计人员可以在这样的平台上集中精力工作。

Gwennap建议,可能需要组合各种不同的努力才能形成对Nvidia有一定的挑战。

Gwennap在谈到一些初创公司各种不同的软件开发工作时表示:“我认为需要在某个时进行整合,帮助其中一些公司增加软件投资。”

Gwennap表示,无论要花费多少,软件都是必不可少的。如果没有一套完整的软件程序、软件堆栈,那么“AI加速器的客户前景将受到限制”。

Gwennap告诉记者,该大会已举办15年了,今年有1,000多名与会者,是前几年在硅谷酒店宴会厅举行的会议会者的三倍多。

会议周三周四继续,下周二、周三和周四进行第二轮演讲,包括周二谷歌的主题演讲。

好文章,需要你的鼓励

超越能源使用:数据中心可持续运营策略

随着AI广泛应用推动数据中心建设热潮,运营商面临可持续发展挑战。2024年底美国已建成或批准1240个数据中心,能耗激增引发争议。除能源问题外,服务器和GPU更新换代产生的电子废物同样严重。通过采用模块化可修复系统、AI驱动资产跟踪、标准化数据清理技术以及与认证ITAD合作伙伴合作,数据中心可实现循环经济模式,在确保数据安全的同时减少环境影响。

剑桥大学突破性研究:如何让AI在对话中学会真正的自信判断

剑桥大学研究团队首次系统探索AI在多轮对话中的信心判断问题。研究发现当前AI系统在评估自己答案可靠性方面存在严重缺陷,容易被对话长度而非信息质量误导。团队提出P(SUFFICIENT)等新方法,但整体问题仍待解决。该研究为AI在医疗、法律等关键领域的安全应用提供重要指导,强调了开发更可信AI系统的紧迫性。

2026年超大规模数据中心运营商发展前瞻:全球最大数据中心运营商的未来走向

超大规模云数据中心是数字经济的支柱,2026年将继续保持核心地位。AWS、微软、谷歌、Meta、甲骨文和阿里巴巴等主要运营商正积极扩张以满足AI和云服务需求激增,预计2026年资本支出将超过6000亿美元。然而增长受到电力供应、设备交付和当地阻力制约。截至2025年末,全球运营中的超大规模数据中心达1297个,总容量预计在12个季度内翻倍。

威斯康星大学研究团队破解洪水监测难题:AI模型终于学会了“眼观六路“

威斯康星大学研究团队开发出Prithvi-CAFE洪水监测系统,通过"双视觉协作"机制解决了AI地理基础模型在洪水识别上的局限性。该系统巧妙融合全局理解和局部细节能力,在国际标准数据集上创造最佳成绩,参数效率提升93%,为全球洪水预警和防灾减灾提供了更准确可靠的技术方案。

Littelfuse推出适用于电动汽车电池、电机和安全系统的汽车级电流传感器

CES 2026 | 机器人开发的“ChatGPT时刻”已到 老黄定调“物理AI”的路线图

超越能源使用:数据中心可持续运营策略

2026年超大规模数据中心运营商发展前瞻:全球最大数据中心运营商的未来走向

TOTOLINK EX200存在未修复固件漏洞可被完全远程接管

Ring推出Fire Watch功能,利用家庭摄像头追踪野火威胁

Snowflake与Google Gemini深度整合,全云环境支持数据分析

联想和摩托罗拉推出自有设备端AI助手

机器海龟游向环保使命:仿生技术守护珊瑚礁

CES 2026最酷笔记本电脑:可拆卸设计成为新趋势

AMD 在 CES 2026 发布新款锐龙处理器、Ryzen AI 及 AMD ROCm,全面扩展其在客户端、图形和软件领域的 AI 领先地位

AMD发布Instinct GPU新品挑战英伟达数据中心霸主地位

最热门的 AI 模型:它们的功能和使用方法

这款古怪的 AI 智能手机可以创建你的数字分身

Faireez 获 750 万美元融资,为租赁市场提供 AI 驱动的酒店式管家服务

Broadcom 大获全胜:70% 大型 VMware 客户购买其最全面解决方案

Peer 获得1050万美元元宇宙引擎投资,推出3D个人星球功能

获 3000 万美元融资,Crogl 发布面向安全分析师的全新 AI "钢铁侠战衣"

Turing 获得 1.11 亿美元融资,估值达到 22 亿美元,为 OpenAI 等大语言模型公司提供关键代码支持

Tavus 推出系列 AI 模型,实现实时人脸交互技术突破

Welevel 获得 570 万美元融资,革新程序化游戏开发

AI 驱动的卓越运营:企业如何通过人人可及的流程智能提升成功