Nvidia首次发布在网络边缘交付AI的超级计算平台

Nvidia本周一晚在洛杉矶举行的世界移动通信大会(Mobile World Congress)上宣布最新的EGX Edge超级计算平台全面上市,该平台完全是针对人工智能处理所谓“边缘数据”而打造的。

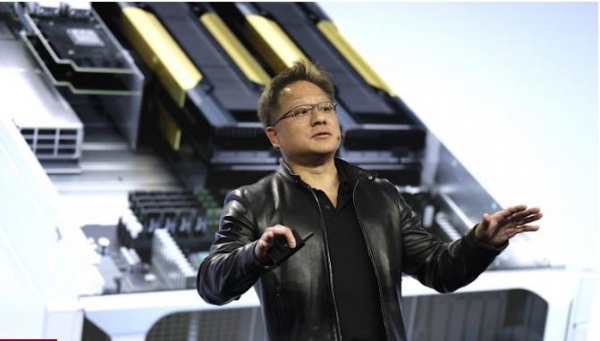

Nvidia公司创始人兼首席执行官黄仁勋表示,EGX将使企业能够利用工厂车间或者城市街道的快速流数据来大规模且更低延迟地交付“下一代AI、物联网和基于5G的服务”。

他在一份声明中表示:“我们进入了一个新的时代,在这个时代数十亿个永远在线的物联网传感器将通过5G连接并由AI处理。这就需要新型且高度安全、可以在远程轻松操作的联网计算机作为基础。因此,我们打造了Nvidia EGX Edge超级计算平台,让计算超越了个人、超越了云,可以在全球范围内运行。”

使AI能够在智能手机、传感器和工厂机器等边缘设备上运行,这是技术发展的下一个阶段。这在以前是不可能的,由于最早的AI算法非常复杂,只能在运行于云数据中心的强大计算机以进行处理,这就需要通过网络发送大量信息。但这是很麻烦的,因为它需要大量的带宽并会导致更高的延迟,所以很难实现“实时” AI。

企业真正想要的是在生成数据的地方执行AI,无论是在制造设施、零售商店还是在仓库,而这正是Nvidia EGX所瞄准的。它将Nvidia的AI技术与数据中心厂商Mellanox的安全、存储和网络技术进行了结合。Nvidia此前曾表示,计划在年底前以69亿美元的价格收购Mellanox。

EGX平台运行Nvidia Edge Stack,这是针对实时AI服务(例如分析,语音和视觉)进行了优化的软件堆栈。该平台还结合了Nvidia的CUDA-X软件、一系列针对AI的库、工具和技术,以及Nvidia认证的GPU服务器。此外,它还支持用于构建智能城市和智能视频分析应用的框架Nvidia Metropolis。

作为已经在充分使用Nvidia EGX的企业客户之一,德国汽车制造商宝马公司使用EGX从位于南卡罗来纳州制造工厂检测线的多个摄像头和传感器收集数据,以实现所谓的“智能视频分析”。

洛杉矶市也是Nvidia平台的另一个早期采用者,该市利用EGX捕获车辆数据和行人数据,自动管理街道信号计时。

Nvidia Aerial

EGX平台的另一个关键,是今天宣布推出的Nvidia Aerial软件开发套件。黄仁勋在主题演讲中表示,Nvidia Aerial对于5G提供商来说至关重要,因为它让5G提供商可以使用EGX来构建和交付“软件定义的高性能5G无线无线电接入网络”,包括从Mellanox网络接口卡到GPU内存的低延迟数据路径,以及5G物理层信号处理引擎,以确保所有数据都保存在GPU内存中。

他表示,电信企业借助Nvidia Aero能够构建完全虚拟化的5G RAN,以支持增强现实、虚拟现实、云游戏和智能工厂等用例。

Nvidia目前已经与瑞典网络公司Telefonaktiebolaget展开合作,建立了全球首个软件定义的5G RAN,而且两家企业正在致力于该技术商业化。

爱立信公司执行副总裁、网络业务负责人Fredrik Jejdling表示:“作为技术领导者,我们拥抱开放性和新平台,在这些平台上我们可以继续创新并突破界限,为客户提供最佳解决方案。我们将与Nvidia共同研究如何将替代解决方案推向市场,以虚拟化完整的无线电接入网络。”

扩展合作伙伴关系

Nvidia还宣布扩大与Red Hat和微软的合作伙伴关系。

首先,Nvidia将向电信企业提供运行在Red Hat OpenShift平台上的高性能、软件定义5G无线基础设施。黄仁勋表示,此举旨在让用户更容易在电信边缘访问AI应用。

同时Nvidia表示,EGX平台正在与微软Azure云紧密集成,以提供更高级的“边缘到云AI计算能力”。两家厂商将专注于智能边缘计算,帮助各个行业的企业组织更好地管理诸如零售商店、仓库、制造厂、联网建筑物和城市基础设施生成的数据,并从中获取洞察。

黄仁勋表示:“全球最大型的那些行业希望将AI计算放在边缘,从连续的数据流中提取洞察,并在行动时感知、推理并采取行动。”

好文章,需要你的鼓励

让自动驾驶AI学会“聚焦重点“,速度提升7倍却更加安全

来自北京大学多媒体信息处理国家重点实验室和小鹏汽车的研究团队发布了一项重要研究成果,提出了一种名为FastDriveVLA的创新框架,让自动驾驶AI能够像人类司机一样,学会在纷繁复杂的道路场景中快速识别并聚焦于真正重要的视觉信息。

清华团队让机器学会“透视眼“:用视频AI破解透明物体深度估计难题

清华团队开发DKT模型,利用视频扩散AI技术成功解决透明物体深度估计难题。该研究创建了首个透明物体视频数据集TransPhy3D,通过改造预训练视频生成模型,实现了准确的透明物体深度和法向量估计。在机器人抓取实验中,DKT将成功率提升至73%,为智能系统处理复杂视觉场景开辟新路径。

TechCrunch创业战场大赛消费和教育科技领域26强公司榜单

TechCrunch年度创业战场大赛从数千份申请中筛选出200强,其中20强进入决赛角逐10万美元大奖。本次消费科技和教育科技领域共有26家公司入选,涵盖无障碍出行、AI视频制作、服装租赁、护肤推荐、纹身预约等创新应用,以及AI语言学习、个性化数学教育、职场沟通培训等教育科技解决方案,展现了科技创新在日常生活和教育领域的广泛应用前景。

ByteDance推出全新混合专家模型训练法:让AI专家团队各司其职,大幅提升大语言模型性能

字节跳动研究团队提出了专家-路由器耦合损失方法,解决混合专家模型中路由器无法准确理解专家能力的问题。该方法通过让每个专家对其代表性任务产生最强响应,同时确保代表性任务在对应专家处获得最佳处理,建立了专家与路由器的紧密联系。实验表明该方法显著提升了从30亿到150亿参数模型的性能,训练开销仅增加0.2%-0.8%,为混合专家模型优化提供了高效实用的解决方案。

TechCrunch创业战场大赛消费和教育科技领域26强公司榜单

新Mac开箱必备:完美工作桌面升级指南

如何使用ChatGPT新增应用集成功能

谷歌地图AI工具让节日和新年出行规划变得轻松便捷

2025年七大IT灾难回顾

openGauss熊伟:oGRAC+超节点,AI数据库的下一个五年

R语言重获关注 Tiobe编程语言排行榜重返前十

JDK 26:Java 26的新特性详解

AWS在re:Invent 2025后仍难构建企业AI完整解决方案

Linux基金会推出自主式AI基金会

GitHub个人访问Token被曝光后威胁激增,攻击者可直达云环境

Manus被收购,枫清科技将获过亿元投资:资本市场重估中国AI智能体