英特尔发布首款人工智能专用芯片Springhill

英特尔今天在以色列海法的一次特别活动中,悄然推出了首款专用人工智能处理器。

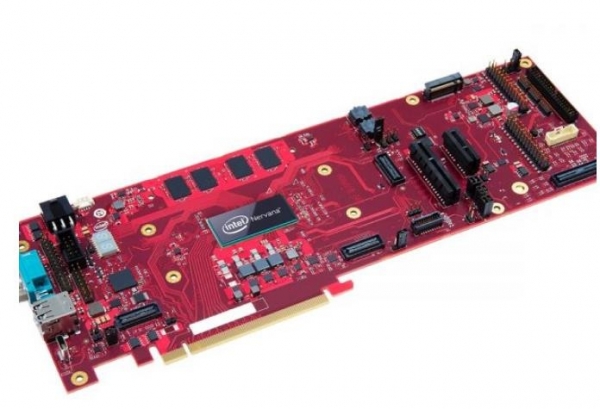

这款名为Nervana Neural Network Processor for Inference的处理器(也称为Springhil),是在位于海法的英特尔实验室开发的,据称是专为运行人工智能工作负载的大型数据中心设计的。据路透社报道,它基于改进的10纳米Ice Lake处理器,能够处理密集型工作负载,同时能耗极少。

英特尔表示,包括Facebook在内的多家客户已经开始在他们的数据中心使用该芯片。

Nervana NNP-I芯片是英特尔“AI无处不在”战略的一个组成部分。英特尔采用GPU、FPGA以及定制的ASIC来处理人工智能中的各种复杂任务,包括创建用于语音翻译和对象识别神经网络,以及通过推理过程运行训练模型。

Nervana NNP-I芯片足够小,可以通过所谓的M.2存储设备部署在数据中心,然后插入主板标准的M.2端口。这样就可以让英特尔标准的至强处理器从推理工作负载中脱离,更专注于一般性的计算任务。

Moor Insights&Strategy分析师Patrick Moorhead表示:“大多数推理工作负载都是在CPU上运行完成的,即便是像Nvidia T系列这样的加速器可以提供更高的性能。当延迟无关紧要而原始性能更重要的时候,则首选是加速器。英特尔的Nervana NNP-I旨在与Nvidia甚至Xilinx FPGA这样的分立加速器展开竞争。”

英特尔表示,Nervana NNP-I芯片实际上是改进版的10纳米Ice Lake芯片,带有两个计算机核心,图形引擎被剥离以容纳12个推理计算引擎,这些目的都是为了加速推理过程,也就是针对语音和图像识别等任务实施经过训练的神经网络模型。

Constellation Research分析师Holger Mueller表示,这对英特尔来说是一次重要的发布,因为此前英特尔在人工智能推理方面基本处于观望状态。

Mueller说:“英特尔正在提升在能耗和存储方面的能力,并在处理器套件中寻求协同效应。由于Springhill是通过M2设备和端口部署的,这在几十年前称为协同处理器,这有效地卸载了至强处理器。但我们必须等待,看看Springhill能否与更专业的、通常是基于GPU的处理器架构相抗衡。”

好文章,需要你的鼓励

如何终结针对IT部门的指责游戏

超过二十年前,记者尼古拉斯·卡尔在《哈佛商业评论》中提出IT是商品化服务,缺乏竞争优势,这一争议再次成为焦点。当前由AI和自动化推动的技术变革中,许多企业领导者将技术决策推给IT部门,然后对结果不满。问题的核心在于组织未能构建让技术成功的环境。企业需要三个转变:将基础IT服务视为公用设施,在传统IT外构建数字和AI能力,让业务领导者对技术成果负责。

剑桥大学突破性研究:如何让AI在对话中学会真正的自信判断

剑桥大学研究团队首次系统探索AI在多轮对话中的信心判断问题。研究发现当前AI系统在评估自己答案可靠性方面存在严重缺陷,容易被对话长度而非信息质量误导。团队提出P(SUFFICIENT)等新方法,但整体问题仍待解决。该研究为AI在医疗、法律等关键领域的安全应用提供重要指导,强调了开发更可信AI系统的紧迫性。

Windchill + Makersite,让可持续性从“理念”变为“行动”

企业不仅能精准掌握碳足迹,更能在运营中产生可量化的商业价值,真正将可持续性从“理念”变为“行动”。

威斯康星大学研究团队破解洪水监测难题:AI模型终于学会了“眼观六路“

威斯康星大学研究团队开发出Prithvi-CAFE洪水监测系统,通过"双视觉协作"机制解决了AI地理基础模型在洪水识别上的局限性。该系统巧妙融合全局理解和局部细节能力,在国际标准数据集上创造最佳成绩,参数效率提升93%,为全球洪水预警和防灾减灾提供了更准确可靠的技术方案。

Nvidia发布Vera Rubin AI计算平台,性能大幅提升

7种削弱IT业务价值的致命做法

PTC在NRF 2026大会上发布AI驱动的FlexPLM新功能

如何终结针对IT部门的指责游戏

Windchill + Makersite,让可持续性从“理念”变为“行动”

Linux基金会领导者:我们并未处在AI泡沫中

全新软件与模型优化为 NVIDIA DGX Spark 注入强大动力

NVIDIA DGX Spark 为桌面端最新开源与前沿AI模型提供强大算力支持

AI流量激增为何现在就需要光网络自动化

AMD 推出锐龙 AI 嵌入式处理器产品组合,为汽车、工业和物理 AI 领域提供 AI 驱动的沉浸式体验

Kubernetes推出AI一致性认证计划,VMware率先通过认证

为何MCP服务器已成为关键微服务架构组件

最热门的 AI 模型:它们的功能和使用方法

这款古怪的 AI 智能手机可以创建你的数字分身

Faireez 获 750 万美元融资,为租赁市场提供 AI 驱动的酒店式管家服务

Broadcom 大获全胜:70% 大型 VMware 客户购买其最全面解决方案

Peer 获得1050万美元元宇宙引擎投资,推出3D个人星球功能

获 3000 万美元融资,Crogl 发布面向安全分析师的全新 AI "钢铁侠战衣"

Turing 获得 1.11 亿美元融资,估值达到 22 亿美元,为 OpenAI 等大语言模型公司提供关键代码支持

Tavus 推出系列 AI 模型,实现实时人脸交互技术突破

Welevel 获得 570 万美元融资,革新程序化游戏开发

AI 驱动的卓越运营:企业如何通过人人可及的流程智能提升成功