赛灵思加速进入数据中心芯片市场

赛灵思(Xilinx)公司在近期召开的年度分析师日活动中向各位华尔街分析师展示了其发展规划。在此次活动期间,该公司对充满活力的数据中心芯片市场做出了充分展望,特别强调了其中的机器学习市场。分析师们预计,该市场的总体价值将由2020年的18亿美元增长至61亿美元。

赛灵思公司的关注重点是大量新型平台产品,这些产品在功能上远远超越其已经销售了数十年的FPGA。这就要求AI应用的开发者们在计算机当中实现全面加速,而不仅仅是关注神经网络本身的性能表现。

数据中心业务目前只占赛灵思整体收入的一小部分,在截至今年3月的上一财年当中,公司总收入为31亿美元,而数据中心业务收入为2.32亿美元。然而,其同时也是赛灵思增长速度最快的业务,在过去一年中增长了46%。该公司日前表示,预计其数据中心收入增长将进一步加速,本财年内增幅将达到55%至65%,这意味着其2017财年至2019财年的年均复合增长率将为42%。

赛灵思希望通过其“Versal”可编程芯片中“AI引擎”部分内相互连接的计算模块,即“tiles”,在机器学习推理领域取得进展。

为了实现这一目标,赛灵思正着手将其在FPGA领域积累到的传统经验迁移至更为复杂的领域。FPGA当中包含大量能够重新排列的逻辑门,其能够根据任务的实际需求进行调整,从而带来更出色的性能与更高的能源效率。

赛灵思如今希望转向出售平台芯片。这类平台芯片仍然包含可编程的逻辑门,但同时亦集成有众多功能性元件。这些功能元件具有更强的任务针对性,例如机器学习,且所有元件都封装在单一芯片晶片当中。

该公司首席执行官Victor Peng在演讲中表示,这是一种类似三明治的结构,机器学习算法将在其中被夹在两个部分的中央——这两部分分别为预处理步骤与后处理步骤。赛灵思目前的关注重点在推理任务,即机器学习模型的预测过程——而非训练过程。Peng指出,如果用于机器学习的芯片不仅能够在中间阶段加快神经网络的处理速度,而且能够同时加快预/后处理部分的性能表现,则将大大提高任务的整体性能水平。

Peng表示,“虽然神经网络是最热门的讨论话题,但这里关注的不仅仅只有神经网络处理,而是整个应用。”

Victor Peng在该公司的分析师日活动中强调称,在性能提升的探索当中,应该得到关注的是整个应用而非单纯只是神经网络。该公司希望凭借着自家Versal以及其它集成化“平台”产品实现这一目标。

Peng表示,举例来说,在无人驾驶汽车等技术当中,“先进驾驶辅助系统(简称ADAS)的总延迟才是大家最关心的,机器学习只是其中的一步。”

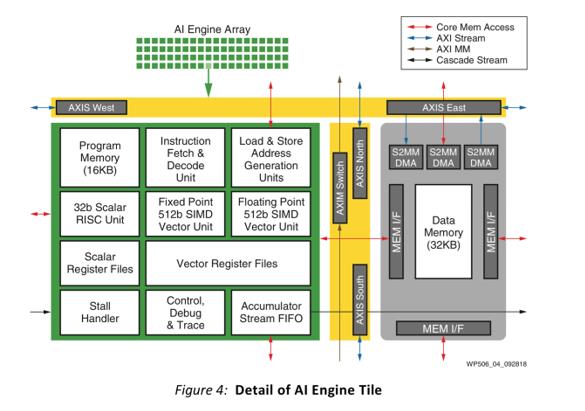

面对这一系列目标,赛灵思认为英特尔公司的CPU与英伟达的GPU都力有不逮。相反,开发人员需要的是既具有可编程逻辑,但又提供某些特定功能单元的片上系统。这首先引出了赛灵思已经推出的Zynq处理器,其中包含有嵌入在大量可编辑逻辑门的ARM CPU。下一步则是一款名为“Versal”的产品,赛灵思已经将其纳入计划。Versal拥有多个对应不同计算功能的可编程内核,其中之一正是“AI引擎”逻辑块。所谓AI引擎实际上代表着一组tiles(即芯片上具有矢量处理能力并配备专用存储器缓存的单一区域),各个tile之间缓过 调整总线相互连接。

当然,目前机器学习开发人员正在不断挖掘FPGA的优势,因此他们是否愿意分出精力关注其它平台仍然有待观察。除了英特尔与英伟达之外,赛灵思还面临着一波又一波竞争压力,包括同时销售CPU与GPU产品的AMD公司;刚刚发布了自己的机器学习芯片的高通公司;谷歌等正在自主构建计算元件的云供应商;以及Efinix等一大批拥有FPGA研发背景的初创企业。

在问答环节中,Peng强调称Versal“家族”将由“六种不同的产品”构成,这意味着该平台方案的范围将不断扩大。他还向参与此次会议的金融分析师们保证,Versal“具有真正的颠覆能力”。其“不仅仅只是芯片”,更代表着各种软件工具——其中一些正在开发当中,这也会令该公司今年的运营支出有所增加。

赛灵思预计数据中心芯片市场将快速增长,特别是其中的机器学习部件。

负责数据中心业务的副总裁Salil Raje则补充称,该公司将利用机器学习方法将来自TensorFlow或者其它机器学习框架的标准代码直接写入至设备当中。Raje解释道,“大多数应用程序都需要在框架的基础之上运作,我们也能够从中获益。具体来讲,只需要接入框架,我们就能提供广泛的支持能力。”

Peng还补充了一些历史背景,包括在多年之前他在ATI公司(后被AMD公司所收购)工作时,“没人知道GP-GPU是什么意思”——是的,这类目前已经在英伟达与AMD那边成为新宠的“通用型GPU”在当初甚至连概念都没有普及。他回忆道,“那时候没人意识到异构计算的意义(Versal这类在芯片中引入多种不同电路类型的混合方案,就属于异构计算)。但现在,每个人都明白异构计算代表着未来,因此我们在某种意义上已经落后了。”但正如自行车比赛一样,领头的车手需要面对较大的风阻,而稍稍落后的选手反而能够节省体力、伺机反超。

在此次会议上,一位金融分析师指出,能够容纳创新型推理芯片的市场恐怕需要很长时间才能建立起来——英特尔仍然凭借着自家CPU占据市场主导地位。Peng承认这一点,并补充道“我们在CPU领域还有很多工作要做。但已经有Twitch等客户主动找到我们,因为他们的任务在现有通用CPU上无法完成。”这里,他指的是亚马逊刚刚发布的流媒体在线游戏服务。亚马逊与百度共同在全球范围内建立起多个“可用中心”,玩家可以借此租用赛灵思的FPGA资源。

Peng希望大家保持耐心。他表示,赛灵思仍然需要“逐步构建起完整的软件堆栈”,其中包括面向Zynq与Versal的各类工具。他指出,其中用于降低芯片部署难度的新型即插即用处理卡Alveo刚刚在2018年年底发布。

他最后总结称,“我们一直认为这代表着巨大的发展机遇,只是还需要一定的时间。”

好文章,需要你的鼓励

至顶AI实验室硬核评测:联想推理加速引擎让AI PC解题快如闪电

联想此次推出的推理加速引擎(Inference Acceleration Engine),是联想携手清华大学无问芯穹团队联合打造的本地AI加速解决方案。这款引擎将预装在联想年底发布的新一代AI PC产品线中,目标是让端侧推理性能直接看齐云端大模型水平。

香港中大联合牛津等名校:AI视频已能完美骗过人工智能检测,连顶级模型都认不出真假

香港中文大学等顶尖院校联合研究发现,当前最先进的AI视频生成技术已能制作出连顶级检测系统都无法识别的假视频。研究团队开发了Video Reality Test平台,测试结果显示最强生成模型Veo3.1-Fast的假视频仅有12.54%被识别,而最强检测系统Gemini 2.5-Pro准确率仅56%,远低于人类专家的81.25%。研究还发现检测系统过度依赖水印等表面特征,音频信息能提升检测准确性,但技术发展已对信息真实性判断带来严峻挑战。

如何让一张照片重建完整3D世界?

Meta超级智能实验室推出的SAM 3D模型,通过创新的"模型在环"数据标注流程和多阶段训练策略,成功实现从单张图像重建完整3D物体的能力。该研究打破了3D领域的数据壁垒,在真实世界场景中展现出远超现有方法的性能,为机器人、AR/VR、游戏制作等应用开启新可能。

Google DeepMind让AI画图快了一半,“预览模式“让创作者告别漫长等待

Google DeepMind团队提出了革命性的"扩散预览"模式,通过ConsistencySolver技术实现AI图像生成的"预览+精修"工作流程。该技术能在5-10步内生成高质量预览图像,与传统40步完整生成保持高度一致性,用户体验测试显示总体时间节省近50%,大大提高了创作效率和创意探索的自由度。