Nvidia首次推出云服务器平台 人工智能和高性能计算统一化

为了在人工智能和高性能计算领域保持领先水平,Nvidia在本周二晚些时候推出了一个新的计算架构,并声称将统一人工智能和高性能计算这两个快速增长的领域。

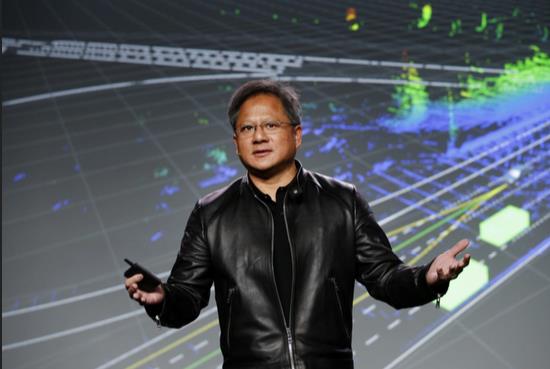

Nvidia公司首席执行官黄仁勋在台湾台北举行的GPU Technology Conference(GTC)大会上宣布推出了HGX-2云服务器平台(如图所示),针对很多结合了人工智能和高性能计算的新应用。

“我们相信未来需要一个统一的平台用于人工智能和高性能计算,”Nvidia加速计算部产品营销经理Paresh Kharya在周二的新闻发布会上这样表示。

其他人表示认同。“我认为人工智能将使高性能计算发生革命性的变化,”Moor Insights&Strategy高级分析师Karl Freund这样表示。“我估计很多超级计算中心都会部署HGX2,因为它可以为高性能计算和人工智能增加巨大的计算能力。”

更具体地说,这种新的架构可以实现包括科学计算和模拟(如天气预报)在内的各种应用,以及人工智能模型(如深度学习神经网络)的训练和运行,用于诸如图像和语音识别以及自驾汽车导航等任务。Kharya说:“这些模型正在以前所未有的速度更新,”有时甚至是每小时更新一次。

由Nvidia GPU提供动力的HGX架构是一种数据中心设备,用于微软的Project Olympus项目、Facebook的Big Basin系统、Nvidia自己的DGX-1 AI超级计算机、以及公有云计算领导者AWS的服务中。该架构的第一个版本HGX-1是在一年前推出的。

HGX-2包含16个Nvidia高端V100 GPU,为计算机制造商提供了打造系统的基本构建块。Nvidia表示,使用Nvidia NVLink芯片互连系统让这16个GPU看起来就像一个整体,提供2 petaflops的浮点运算性能。

“基本上你可以将HGX用作16个GPU组成的池,就像是一个非常大的计算资源,”Freund解释说。

Nvidia也表示,最近推出的DGX-2 AI超级计算机是第一个使用HGX-2的系统。它将在第三季度销售,售价为399,000美元。黄仁勋在主题演讲中开玩笑说,它有“很大的价值”。

Nvidia已经打造了三类服务器,这些服务器将CPU与GPU混合用于人工智能训练、人工智能推理、模型运行、以及超级计算的优化配置。

Kharya将HGX架构定位为类似于英特尔和微软开发的ATX个人电脑主板配置标准,后者导致许多公司制造兼容系统组件的爆炸式增长。

周二宣布计划推出支持HGX-2的服务器制造商包括联想、QTC、超微、Wiwynn公司。另外,所ODM厂商商鸿海精密工业公司(Foxconn)、英业达(Inventec)、广达电脑(Quanta Computer)和纬创公司(Wistron),全球一些最大的云数据中心都在使用他们的系统。他们称将在今年晚些时候推出HGX-2系统。

与此同时,英特尔正加紧扩大在人工智能计算方面的业务,上周预览了一款新型芯片,预计在2019年晚些时候发布该芯片。英特尔表示,该芯片旨在更快地构建人工智能模型。英特尔人工智能集团负责人Naveen Rao抨击了Nvidia,称关于GPU比英特尔最新至强处理器快得多的说法是一个“神话”。

好文章,需要你的鼓励

AI投资有望在2026年获得真正回报的原因解析

尽管全球企业AI投资在2024年达到2523亿美元,但MIT研究显示95%的企业仍未从生成式AI投资中获得回报。专家预测2026年将成为转折点,企业将从试点阶段转向实际部署。关键在于CEO精准识别高影响领域,推进AI代理技术应用,并加强员工AI能力培训。Forrester预测30%大型企业将实施强制AI培训,而Gartner预计到2028年15%日常工作决策将由AI自主完成。

北大学者革新软件诊断方式:让代码问题的“病因“无处遁形

这项由北京大学等机构联合完成的研究,开发了名为GraphLocator的智能软件问题诊断系统,通过构建代码依赖图和因果问题图,能够像医生诊断疾病一样精确定位软件问题的根源。在三个大型数据集的测试中,该系统比现有方法平均提高了19.49%的召回率和11.89%的精确率,特别在处理复杂的跨模块问题时表现优异,为软件维护效率的提升开辟了新路径。

2026年软件定价大洗牌:IT领导者必须知道的关键变化

2026年软件行业将迎来定价模式的根本性变革,从传统按席位收费转向基于结果的付费模式。AI正在重塑整个软件经济学,企业IT预算的12-15%已投入AI领域。这一转变要求建立明确的成功衡量指标,如Zendesk以"自动化解决方案"为标准。未来将出现更精简的工程团队,80%的工程师需要为AI驱动的角色提升技能,同时需要重新设计软件开发和部署流程以适应AI优先的工作流程。

德国达姆施塔特工业大学团队首次揭秘:专家混合模型AI的“安全开关“竟然如此脆弱

这项由德国达姆施塔特工业大学领导的国际研究团队首次发现,当前最先进的专家混合模型AI系统存在严重安全漏洞。通过开发GateBreaker攻击框架,研究人员证明仅需关闭约3%的特定神经元,就能让AI的攻击成功率从7.4%暴增至64.9%。该研究揭示了专家混合模型安全机制过度集中的根本缺陷,为AI安全领域敲响了警钟。

稚晖君发布全球最小全身力控人形机器人,上纬启元开启个人机器人时代

2026年软件定价大洗牌:IT领导者必须知道的关键变化

Linux 在 2026 年将势不可挡,但一个开源传奇可能难以为继

CES 2026趋势展望:全球最大科技展五大热门话题预测

人工智能时代为何编程技能比以往更重要

AI颠覆云优先战略:混合计算成为唯一出路

谷歌发布JAX-Privacy 1.0:大规模差分隐私机器学习工具库

谷歌量子AI发布新型优化算法DQI:量子计算优化领域的重大突破

缓解电动汽车里程焦虑:简单AI模型如何预测充电桩可用性

Titans + MIRAS:让AI拥有长期记忆能力

Gemini为STOC 2026大会理论计算机科学家提供自动化反馈

夸克AI眼镜持续升级:首次OTA,支持89种语言翻译

最热门的 AI 模型:它们的功能和使用方法

这款古怪的 AI 智能手机可以创建你的数字分身

Faireez 获 750 万美元融资,为租赁市场提供 AI 驱动的酒店式管家服务

Broadcom 大获全胜:70% 大型 VMware 客户购买其最全面解决方案

Peer 获得1050万美元元宇宙引擎投资,推出3D个人星球功能

获 3000 万美元融资,Crogl 发布面向安全分析师的全新 AI "钢铁侠战衣"

Turing 获得 1.11 亿美元融资,估值达到 22 亿美元,为 OpenAI 等大语言模型公司提供关键代码支持

Tavus 推出系列 AI 模型,实现实时人脸交互技术突破

Welevel 获得 570 万美元融资,革新程序化游戏开发

AI 驱动的卓越运营:企业如何通过人人可及的流程智能提升成功